CRC校验源码详解与常见算法解析

需积分: 44 195 浏览量

更新于2024-09-15

收藏 28KB PDF 举报

CRC校验是一种广泛应用于数据传输和存储中的一种错误检测技术,它通过计算发送数据的伪哈希值来检验数据传输过程中的完整性。本文档主要针对CRC校验的源码分析,作者在实际项目中首次接触CRC校验时遇到困难,因此决定从实际代码出发,以易于理解的方式解释这一概念。

首先,CRC校验的核心是根据特定的多项式来执行位级的操作。常见的CRC类型包括CRC8、CRC-CCITT (16位)、CRC12和CRC32,它们的多项式有所不同,如CRC8的多项式为X8+X5+X4+1,CRC-CCITT多项式为X16+X12+X5+1。这些多项式决定了计算过程中哪些位参与XOR运算。

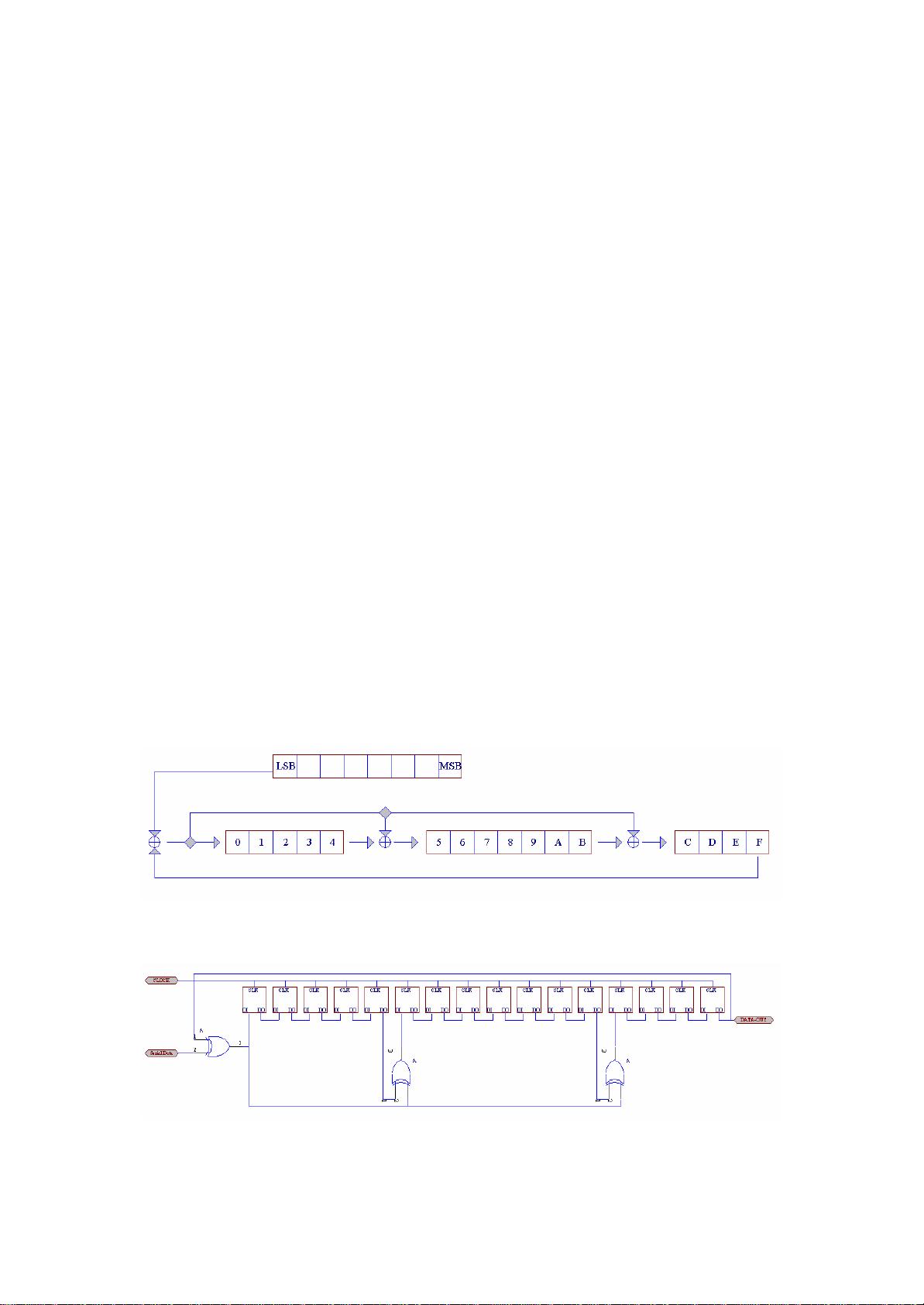

在CRC校验过程中,数据被逐位输入到一个反向耦合移位寄存器中,这是一个在硬件或软件实现中用来临时存储和处理数据的结构。移位寄存器的配置决定了多项式的具体应用,例如在CRC-CCITT中,X5对应于输入数据的第5位,X12对应于第12位,而X16则表示移位寄存器中移出的数据(即当前数据位)。计算过程中,每次将数据位与上一次计算结果的相应位进行XOR操作,然后将结果左移一位,直到所有数据处理完毕。

文档提供了一个使用keilC7.10编译器的示例代码,展示了如何初始化CRC缓冲区(crcbuff[]数组),以及定义和初始化CRC码变量(crc)。`main()`函数中,指针ptr指向数据,通过循环处理每个数据位,并根据多项式计算CRC值。在这个例子中,CRC算法是通过位级操作逐步累积生成的,最后得到的结果就是CRC码,可以用来验证接收到的数据是否完整无误。

这篇文章深入浅出地讲解了CRC校验的基本原理,重点在于源码级别的实现,这对于初次接触CRC校验或者需要在实际项目中应用这项技术的开发者来说,是一份实用的学习资料。理解了这种计算方法,不仅有助于掌握CRC校验的原理,还能快速应用到具体的编程实现中去。

2022-09-20 上传

2022-09-23 上传

2008-07-09 上传

2013-05-08 上传

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

modelfeifei

- 粉丝: 1

- 资源: 7

最新资源

- NIST REFPROP问题反馈与解决方案存储库

- 掌握LeetCode习题的系统开源答案

- ctop:实现汉字按首字母拼音分类排序的PHP工具

- 微信小程序课程学习——投资融资类产品说明

- Matlab犯罪模拟器开发:探索《当蛮力失败》犯罪惩罚模型

- Java网上招聘系统实战项目源码及部署教程

- OneSky APIPHP5库:PHP5.1及以上版本的API集成

- 实时监控MySQL导入进度的bash脚本技巧

- 使用MATLAB开发交流电压脉冲生成控制系统

- ESP32安全OTA更新:原生API与WebSocket加密传输

- Sonic-Sharp: 基于《刺猬索尼克》的开源C#游戏引擎

- Java文章发布系统源码及部署教程

- CQUPT Python课程代码资源完整分享

- 易语言实现获取目录尺寸的Scripting.FileSystemObject对象方法

- Excel宾果卡生成器:自定义和打印多张卡片

- 使用HALCON实现图像二维码自动读取与解码