Kafka消息可靠性解析:存储、复制与保证

25 浏览量

更新于2024-08-29

收藏 571KB PDF 举报

"kafka数据可靠性深度解读"

Kafka是一个由LinkedIn开发并后来成为Apache软件基金会项目的分布式消息系统,因其可扩展性和高吞吐率而广受欢迎。它使用Scala编程语言编写,现已被许多开源分布式处理系统如Cloudera、Apache Storm、Spark等集成。在互联网行业中,Kafka作为消息中间件扮演着关键角色,唯品会等企业也采用了它。确保Kafka的数据可靠性至关重要,涉及消息传输的精确性、存储的准确性和消费的正确性。

Kafka的架构由Producer、Broker、Consumer Group和Zookeeper集群组成。Producer通过push模式将消息发送到Broker,而Consumer则通过pull模式从Broker获取并消费消息。Zookeeper负责集群配置管理、leader选举以及Consumer Group变化时的rebalance操作。

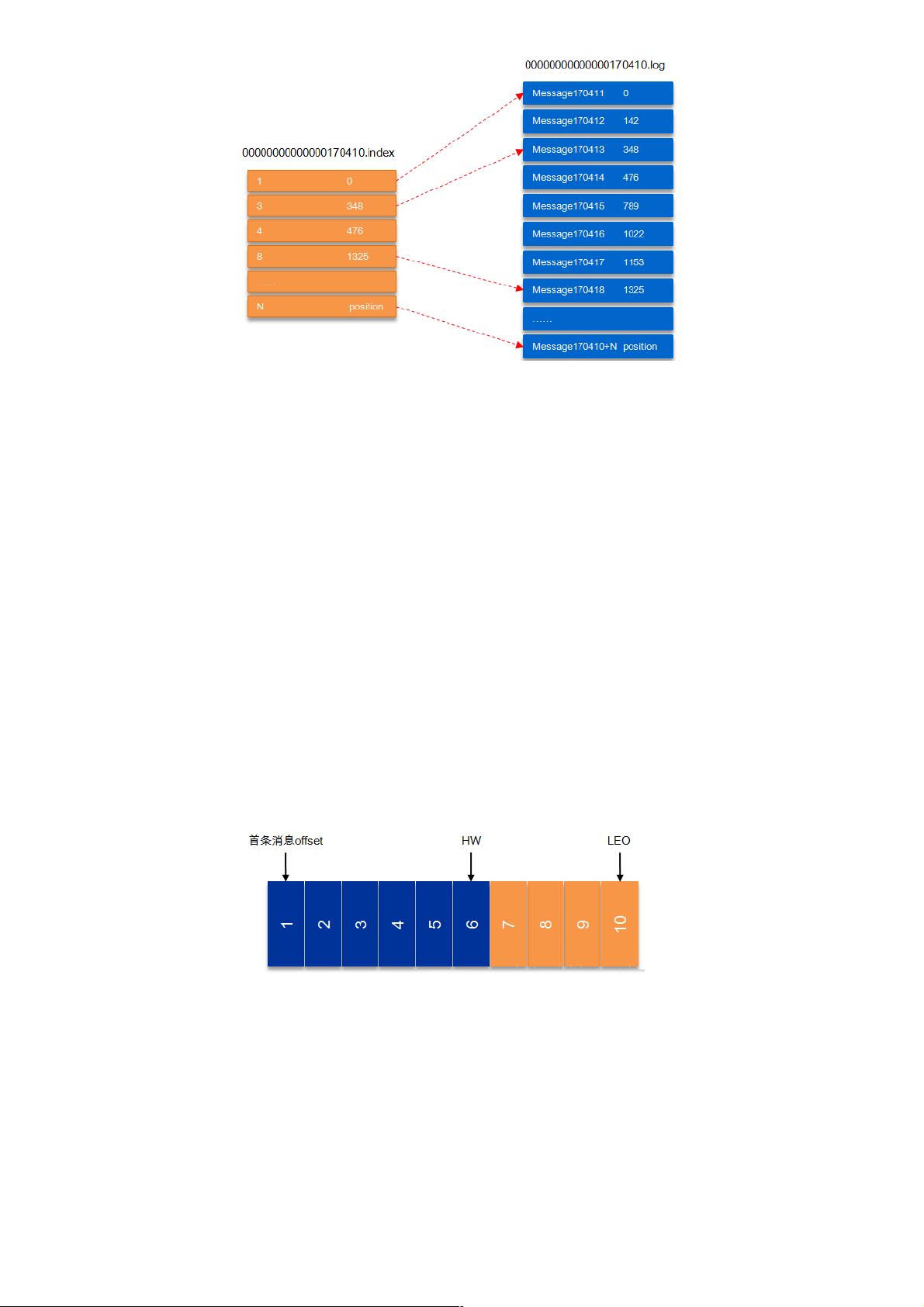

在Kafka中,消息被组织成topics,每个topic可被划分为多个partitions。partitions是以append-only log的形式存储,消息的顺序写入(基于offset)保证了高效的性能。分区内的消息根据特定的partition规则被分配到不同的partition,这有助于负载均衡和提高系统性能。

Kafka的数据可靠性主要体现在以下几个方面:

1. **复制机制**:每个partition在多个broker之间都有副本(replicas),其中一个被选为leader,其余为followers。如果leader失败,followers中的一台将自动晋升为新的leader,确保服务不间断。

2. **同步原理**:followers通过fetch请求从leader同步数据,确保所有副本保持一致。Kafka提供了不同的同步策略(例如,同步复制和异步复制),在延迟和容错性之间取得平衡。

3. **持久性保证**:Kafka将消息写入磁盘,并且可以通过设置保留策略(例如,基于时间或大小)来控制消息的生命周期。即使在broker故障后,数据也可以从副本中恢复。

4. **消费者offset管理**:每个Consumer Group维护自己的offset,记录了每个partition的消费进度。这样,即使consumer失败,从上次已知的offset恢复消费也能保证不丢失消息。

5. **错误恢复**:Kafka提供幂等性和Exactly-Once语义,通过幂等producer和事务特性,确保消息在故障情况下不会被重复处理。

6. **可用性和一致性**:通过Zookeeper协调,Kafka可以在保证数据一致性的同时,实现高可用性。在进行rebalance时,可以避免数据丢失或重复消费。

通过深入理解Kafka的这些机制,我们可以更好地评估和优化系统的可靠性。此外,基准测试(benchmark)也是验证和提升Kafka高可靠性的重要手段,通过实际的性能测试,可以发现并解决潜在问题,进一步增强系统的稳定性。

2018-09-21 上传

2020-01-09 上传

2020-01-08 上传

2021-02-25 上传

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

weixin_38599430

- 粉丝: 0

- 资源: 886

最新资源

- MCS51单片机的寻址

- 用Flash制作选择题模板

- oracle10的优化

- Windows Communication Foundation 入门.pdf

- 中大ACM题库的分类

- datasheet-lm3s1138-zh_cn

- 基于ICL8038函数信号发生器的设计

- Makefile中文教程

- 杭电ACM1002解题答案

- Mean Shift图像分割的快速算法

- vxwork 6.6版本的bsp开发指导说明文档

- Windows嵌入式开发系列课程(3):WindowsCE.NET USB驱动开发基础.pdf

- Java反射机制Demo

- MyEclipse+6+Java开发教程

- 无废话JavaScript和html学习笔记

- 计算机专业软件工程的复习范围