动手写网络爬虫:入门与HTTP状态码解析

需积分: 9 152 浏览量

更新于2024-07-27

收藏 2.57MB PDF 举报

"自己动手写网络爬虫第一章"

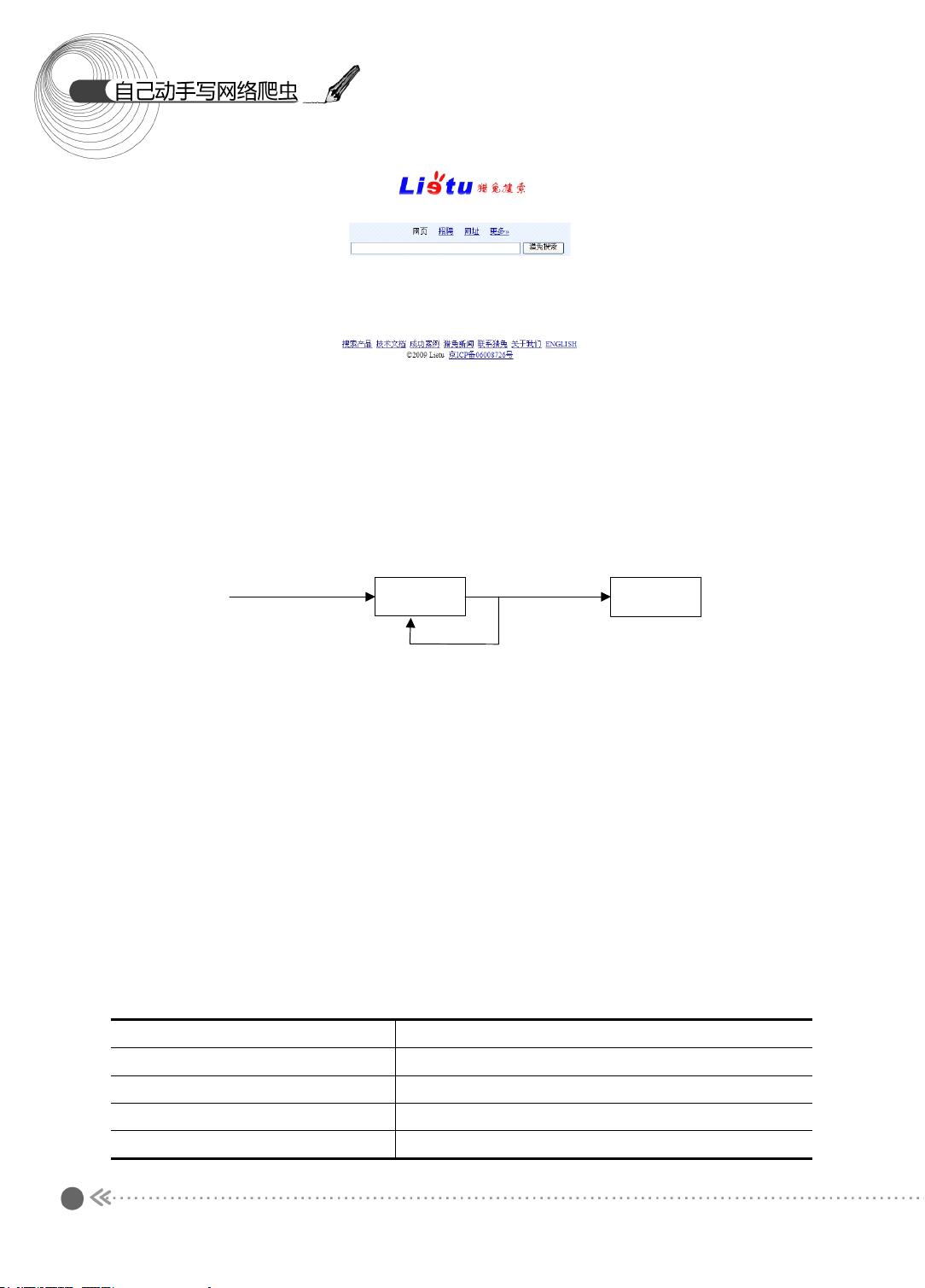

在这一章节中,我们将深入学习网络爬虫的基本原理,以及如何利用开源爬虫工具Heritrix来实现数据抓取。网络爬虫,也称为Spider,是互联网信息获取的重要工具,它能够自动化地遍历网页,收集所需信息。对于大型搜索引擎如百度和Google而言,爬虫是它们获取和更新海量网页信息的基础。

首先,我们需要了解为什么要在已经有了大型搜索引擎的情况下,还要自己编写网络爬虫。尽管搜索引擎已经覆盖了大量信息,但特定的、个性化的数据需求仍然存在。企业可能需要爬取网页数据用于数据仓库的构建或数据挖掘,个人用户也可能有特定目的,如获取股票信息。因此,掌握网络爬虫的技能是非常有价值的。

网络爬虫的基本操作就是抓取网页。这个过程始于URL(统一资源定位符)。当我们输入URL,如http://www.lietu.com,浏览器实际上是向服务器发送了一个请求,请求返回的网页内容则被浏览器解析并显示。我们可以通过浏览器的“查看源文件”功能查看抓取的原始HTML代码。

在深入理解URL之前,先要提到URI(统一资源标识符)。URI是Web上所有资源的唯一标识,包括HTML文档、图片、视频等。它通常由三部分构成:命名机制(如HTTP)、主机名(如www.webmonkey.com.cn)和资源路径。例如,http://www.webmonkey.com.cn/html/h是一个URI实例,它定义了使用HTTP协议访问的webmonkey.com.cn主机上的“html/h”资源。

在实际的网页抓取过程中,Java等编程语言常被用来编写爬虫程序。通过发送HTTP请求,解析返回的HTML内容,我们可以提取出需要的数据。此外,处理HTTP状态码是爬虫开发中的关键环节,它能帮助我们判断请求是否成功,例如200表示成功,404则意味着页面未找到。

Heritrix是一个流行的开源网络爬虫,适用于大规模的网页抓取任务。它提供了灵活的配置和强大的爬取能力,允许开发者定制抓取策略,满足各种数据采集需求。

这一章将引导你从基础的URL概念出发,逐步学习如何使用编程语言实现网页抓取,最终掌握使用Heritrix这样的开源工具构建网络爬虫的方法。通过这一系列的学习,你将具备独立编写网络爬虫的能力,可以自由地抓取并处理互联网上的各类信息。

2011-05-30 上传

106 浏览量

2014-10-03 上传

2011-12-29 上传

2011-12-29 上传

2011-12-29 上传

2011-12-29 上传

2012-03-08 上传

2013-09-11 上传

tang2du

- 粉丝: 17

- 资源: 6

最新资源

- Java集合ArrayList实现字符串管理及效果展示

- 实现2D3D相机拾取射线的关键技术

- LiveLy-公寓管理门户:创新体验与技术实现

- 易语言打造的快捷禁止程序运行小工具

- Microgateway核心:实现配置和插件的主端口转发

- 掌握Java基本操作:增删查改入门代码详解

- Apache Tomcat 7.0.109 Windows版下载指南

- Qt实现文件系统浏览器界面设计与功能开发

- ReactJS新手实验:搭建与运行教程

- 探索生成艺术:几个月创意Processing实验

- Django框架下Cisco IOx平台实战开发案例源码解析

- 在Linux环境下配置Java版VTK开发环境

- 29街网上城市公司网站系统v1.0:企业建站全面解决方案

- WordPress CMB2插件的Suggest字段类型使用教程

- TCP协议实现的Java桌面聊天客户端应用

- ANR-WatchDog: 检测Android应用无响应并报告异常