循环神经网络(RNN)详解:序列数据建模与反向传播

需积分: 0 121 浏览量

更新于2024-08-05

收藏 901KB PDF 举报

"循环神经网络(RNN)是用于处理序列数据的一种深度学习模型,尤其适合文本等具有时间序列特性的任务。它通过内部状态保留先前输入的信息,从而能够捕获序列中的长期依赖关系。然而,RNN在训练过程中存在梯度消失的问题,这主要与反向传播通过时间(BPTT)的机制有关。在BPTT中,由于参数在所有时间步是共享的,导致梯度在反向传播过程中受到递归影响,可能会出现梯度爆炸或消失的情况。"

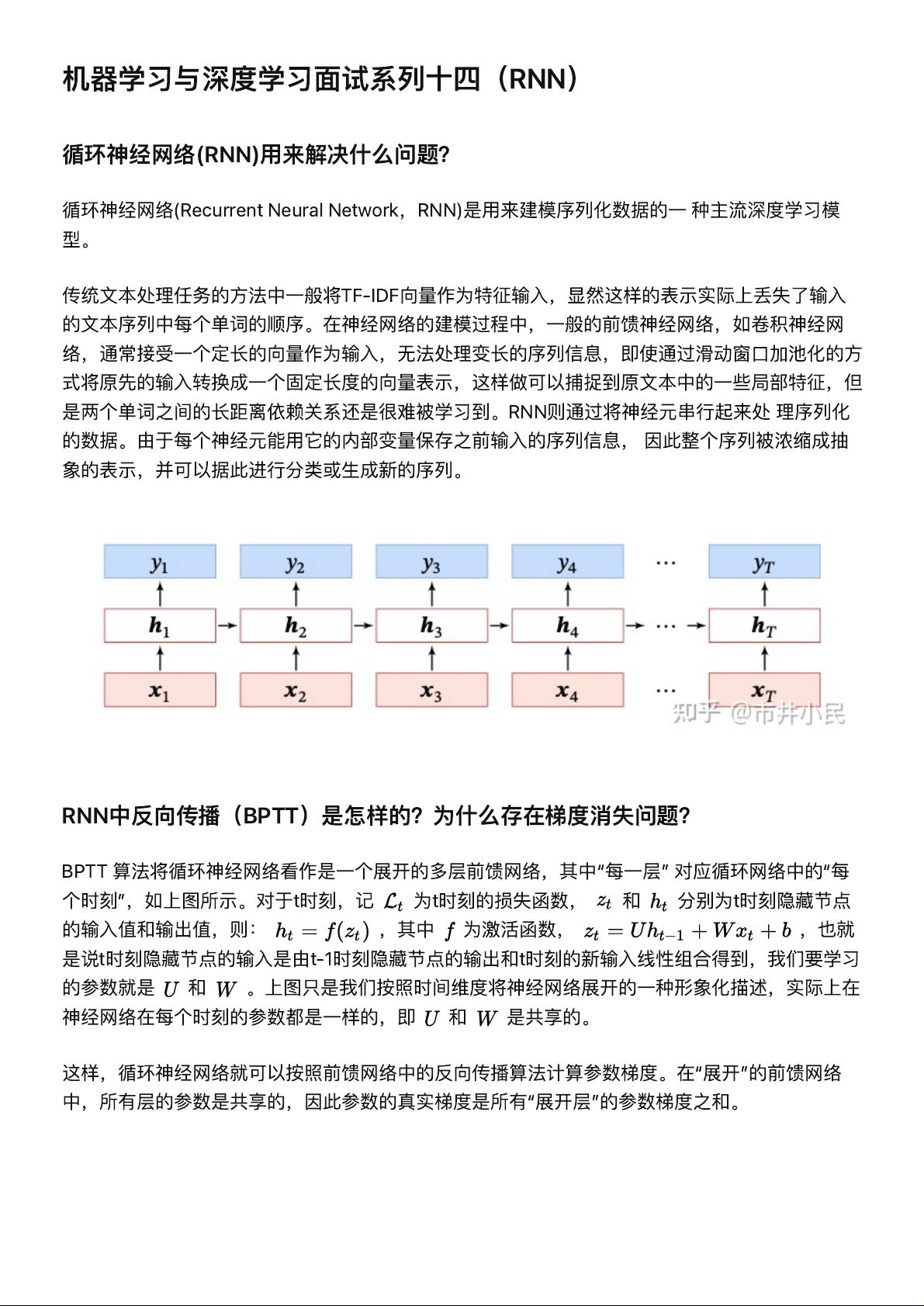

循环神经网络(RNN)是机器学习和深度学习领域中处理序列数据的关键模型。它们被设计用来理解和生成具有时间顺序的输入,如自然语言文本。在传统的文本处理方法中,如使用TF-IDF向量,虽然可以获取词频信息,但无法捕捉到单词间的顺序关系。相比之下,RNN通过其循环结构,允许信息在时间步之间流动,使得模型能够学习并记住长期依赖。

RNN的核心在于其单元状态,它接收当前时间步的输入和上一时间步的隐藏状态,然后产生一个新的隐藏状态。这种结构使得RNN能够处理不同长度的序列,因为它可以根据需要展开到任意长度的序列。例如,在自然语言处理中,RNN可以用来进行情感分析、机器翻译或语言建模等任务。

在反向传播通过时间(BPTT)的过程中,RNN被视作一个时间步展开的多层前馈网络。损失函数沿着时间轴反向传播,更新权重。然而,BPTT引入了一个挑战:梯度消失问题。由于权重在所有时间步共享,梯度会通过多个时间步的链式法则传递,如果激活函数的导数范围有限,这可能导致梯度变得极小,从而使模型难以学习长距离的依赖。

梯度消失问题的根本原因在于RNN中隐藏状态的更新公式,这个公式涉及一个递归过程,其中当前时间步的梯度与前面时间步的梯度相乘。如果激活函数的雅克比矩阵最大特征值小于1,梯度的大小会随时间步指数级减小,导致梯度消失。相反,如果最大特征值大于1,梯度可能会迅速增长,引发梯度爆炸。这两种情况都会妨碍RNN的有效训练。

为了解决这些问题,研究人员提出了各种改进方案,如长短期记忆网络(LSTM)和门控循环单元(GRU),它们引入了额外的门控机制来控制信息流,从而更好地处理长期依赖,并在一定程度上缓解了梯度消失问题。这些门控RNN变体已成为现代序列建模任务的首选模型。

循环神经网络通过其独特的循环结构为序列数据的建模提供了强大的工具,但同时也面临着梯度消失和梯度爆炸的挑战。通过不断的研究和创新,如LSTM和GRU,这些问题已经得到了显著改善,使RNN在自然语言处理、语音识别、时间序列预测等多个领域展现出强大的应用潜力。

134 浏览量

1262 浏览量

360 浏览量

2025-01-10 上传

2025-01-10 上传

王元祺

- 粉丝: 848

- 资源: 303

最新资源

- star NX-650 打印机说明书

- Simulink在直接扩频通信系统中的应用

- DIV+CSS布局大全

- 考研英语核心词汇.pdf

- 《eclipse基础教程中文版》

- Fundamentals of Digital Television Transmission

- Java+Servlet+API说明文档

- 网上书店需求分析书(很正规的一个模板啊)

- Linux Unicode Programming-CH

- 清华大学2005年第23届挑战杯精品集

- ATM Signalling PROTOCOLS AND PRACTICE

- 高质量C++编程指南

- essential c++英文版

- SQL Sever 2005专业教程(英文版)

- CHS]跟我一起写_Makefile

- Computer Arithmetic