卷积神经网络(CNN)详解:结构、参数与应用

需积分: 0 15 浏览量

更新于2024-07-01

1

收藏 3.95MB PDF 举报

"本资源详细介绍了卷积神经网络(CNN)的基本构成、作用、参数以及在不同领域的应用。内容涵盖卷积层、激活层、池化层和全连接层等核心组成部分,讨论了卷积核的选择、参数量的减少方法、转置卷积及其可能产生的棋盘效应,还涉及了局部连接、权值共享和NetVLAD池化等技术。此外,文中还强调了CNN在图像识别、自然语言处理和语音识别等多个领域的应用。"

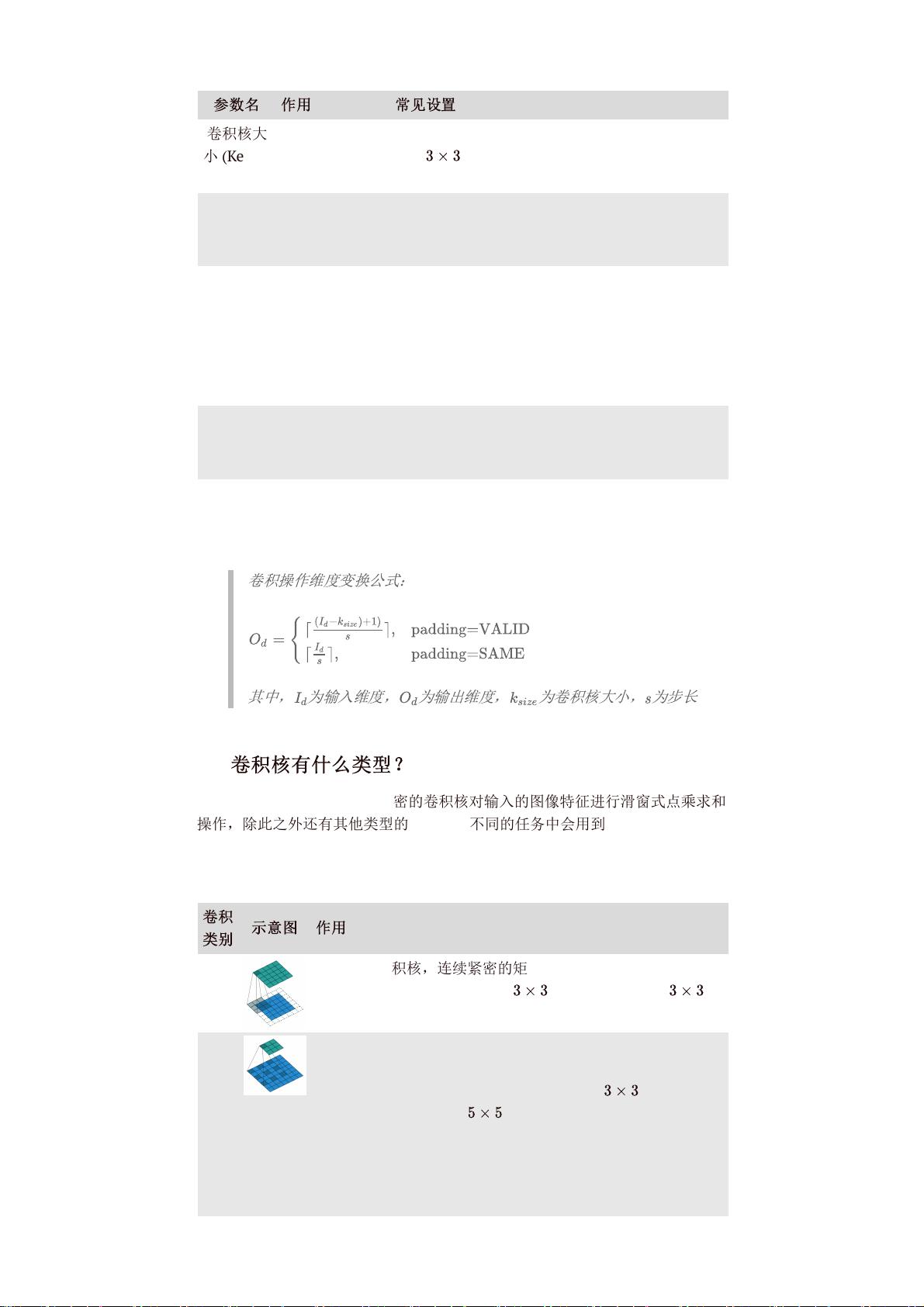

在卷积神经网络(CNN)中,卷积层是核心组件,它通过卷积操作从输入图像中提取特征。卷积层包含多个卷积核,每个卷积核在输入数据上滑动,生成特征映射。卷积核的大小、步长和填充等参数影响着模型的感受野和参数数量。扩张率(DilationRate)是控制感受野大小的新参数,它允许使用较小的卷积核获得较大的视野,从而减少参数量。

激活层如ReLU,用于引入非线性,使得网络能学习更复杂的模式。池化层则通过下采样降低数据维度,减少计算量并防止过拟合。全连接层将特征图转换为分类或回归预测。

卷积核的类型包括方形和非方形,以及不同尺寸的卷积核,选择哪种取决于应用场景和特征需求。二维卷积处理二维数据,如图像,而三维卷积常用于处理视频或3D数据。

池化方法有最大池化、平均池化、L2池化等,每种都有其特定目的。转置卷积用于扩大输出尺寸,但可能导致棋盘效应,即输出图像中规则的空洞结构。为减轻这一现象,可以通过调整步长和填充。

减少卷积层参数量的方法包括使用小尺寸卷积核、权值共享、使用深度可分离卷积和利用跨层参数共享等。在卷积操作时,通道和区域的考虑是必要的,因为它们影响特征提取的多样性和效率。

CNN的局部连接和权值共享有助于捕获局部特征并降低模型复杂度。NetVLAD池化是聚合局部特征的有效方法,常用于图像聚类和识别任务。局部卷积适用于处理局部信息,如边缘检测或纹理分析。

CNN在图像识别、自然语言处理和语音识别等领域的应用广泛,其结构的灵活性和对局部-全局特征的处理能力使其成为这些领域的首选模型。通过优化网络结构和参数设置,可以进一步提高CNN的泛化能力和性能。

2022-08-03 上传

2022-08-04 上传

2020-07-27 上传

2022-08-04 上传

2015-11-06 上传

2023-06-22 上传

2023-04-05 上传

2021-11-06 上传

老许的花开

- 粉丝: 34

- 资源: 328

最新资源

- word 排版技巧 不得不看的资源

- DS1302中文资料

- ajax实战中文版(最新)

- PowerBuilder制作IE风格的图标按钮

- PowerBuilder同时访问多个数据库

- Elements of Information Theory

- the GNU C library

- 关于抽象类和接口的两篇不错文章

- Tomact容器相关知识

- JasperReport 与iReport 的配置与使用

- arcgis介绍文件

- 数字温度计ds18b20的详细中文资料

- Groovy经典入门+.pdf

- 使用WEB方式修改域用戶密碼

- MYECLIPSE 下的 JAVA 教程

- 《Struts in Action中文版》