深度学习入门:卷积神经网络(CNN)解析

"本资源提供对卷积神经网络(CNN)的入门介绍,适合初学者。内容涵盖了CNN的基本概念、历史发展以及在深度学习(DL)时代的重要进展。"

卷积神经网络(CNN)是一种深度学习模型,特别适用于图像识别和处理任务。它的设计灵感来源于生物视觉系统,尤其是大脑的视觉皮层。CNN的主要特点是利用卷积层来检测和学习图像中的特征,这些特征可以是边缘、纹理或更复杂的形状。

早期的CNN模型可以追溯到1980年,当时K. Fukushima提出了“Neocognitron”,这是一种自组织的神经网络模型,能实现位置不变的模式识别。1989年,Y. LeCun等人将反向传播算法应用到手写邮编识别,这是CNN在实际应用中的重要一步。1998年,LeCun等人在《Proceedings of the IEEE》上发表的文章中详细阐述了基于梯度的学习方法在文档识别中的应用,进一步推动了CNN的发展。

随着深度学习时代的到来,CNN得到了显著的扩展和优化。2012年,Alex Krizhevsky、Ilya Sutskever和Geoffrey Hinton在NIPS会议上展示了深度卷积神经网络(Deep CNN)在ImageNet大规模图像分类任务上的优秀性能。这标志着CNN在计算机视觉领域的重要地位。之后,Caffe框架的提出(Jia et al., ACM MM 2014)使得CNN的实现更加便捷,而VGGNet(Simonyan & Zisserman, 2014)通过极深的网络结构进一步提升了特征提取的能力。

2015年的GoogLeNet(Szegedy et al., CVPR 2015)引入了Inception模块,提高了模型的效率和准确性,展示了更深更宽的卷积网络在图像识别上的潜力。这些工作不仅深化了我们对CNN的理解,也极大地推动了相关技术在自动驾驶、医疗影像分析、自然语言处理等多个领域的应用。

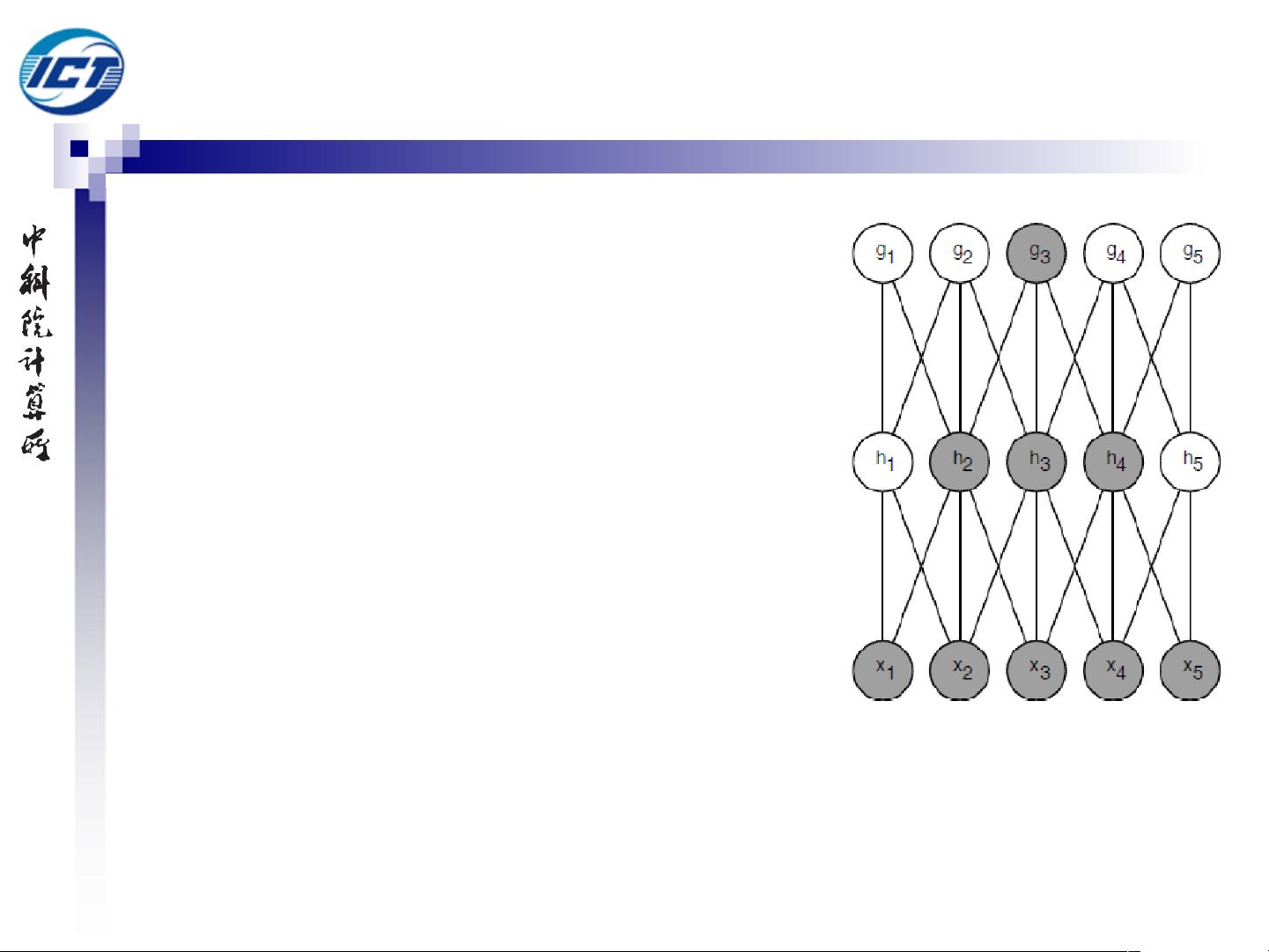

CNN的核心组件是卷积层,它通过滤波器(或称卷积核)对输入数据进行扫描,提取特征。卷积层的一个关键特性是参数共享,即同一滤波器在不同位置的应用使用相同的权重,这大大减少了模型的参数数量,降低了过拟合的风险。此外,池化层用于降低数据的空间维度,增加模型的鲁棒性;全连接层则将提取的特征转换为分类或回归的输出。

卷积操作之所以有效,是因为它们能够在图像中捕捉局部的结构信息,同时保持位置不变性。这种特性使得CNN在处理具有固定模式或结构的数据时表现优异。在训练过程中,网络自动学习这些滤波器,以识别出图像中的关键特征,如边缘、角点等。

总结来说,CNN是深度学习中不可或缺的一部分,尤其在处理图像数据时展现出强大的能力。从最初的Neocognitron到现代的深度CNN架构,这一领域的研究不断推进着人工智能的进步,为图像识别、自然语言处理等众多领域提供了强有力的工具。

1819 浏览量

254 浏览量

2025-02-25 上传

2025-03-09 上传

332 浏览量

2024-07-05 上传

325 浏览量

385 浏览量

CodeCold

- 粉丝: 57

最新资源

- Premiere Pro CS6视频编辑项目教程微课版教案

- SSM+Lucene+Redis搜索引擎缓存实例解析

- 全栈打字稿应用:演示项目实践与探索

- 仿Windows风格的AJAX无限级树形菜单实现教程

- 乐华2025L驱动板通用升级解决方案

- Java通过jcraft实现SFTP文件上传下载教程

- TTT素材-制造1资源包介绍与记录

- 深入C语言编程技巧与实践指南

- Oracle数据自动导出并转换为Excel工具使用教程

- Ubuntu下Deepin-Wine容器的使用与管理

- C语言网络聊天室功能详解:禁言、踢人与群聊

- AndriodSituationClick事件:详解按钮点击响应机制

- 探索Android-NetworkCue库:高效的网络监听解决方案

- 电子通信毕业设计:简易电感线圈制作方法

- 兼容性数据库Compat DB 4.2.52-5.1版本发布

- Android平台部署GNU Linux的新方案:dogeland体验