伯禹伯禹 动手学深度学习动手学深度学习 打卡打卡07 之之 LeNet

Convolutional Neural Networks

使用全连接层的局限性:

图像在同一列邻近的像素在这个向量中可能相距较远。它们构成的模式可能难以被模型识别。

对于大尺寸的输入图像,使用全连接层容易导致模型过大。

使用卷积层的优势:

卷积层保留输入形状。

卷积层通过滑动窗口将同一卷积核与不同位置的输入重复计算,从而避免参数尺寸过大

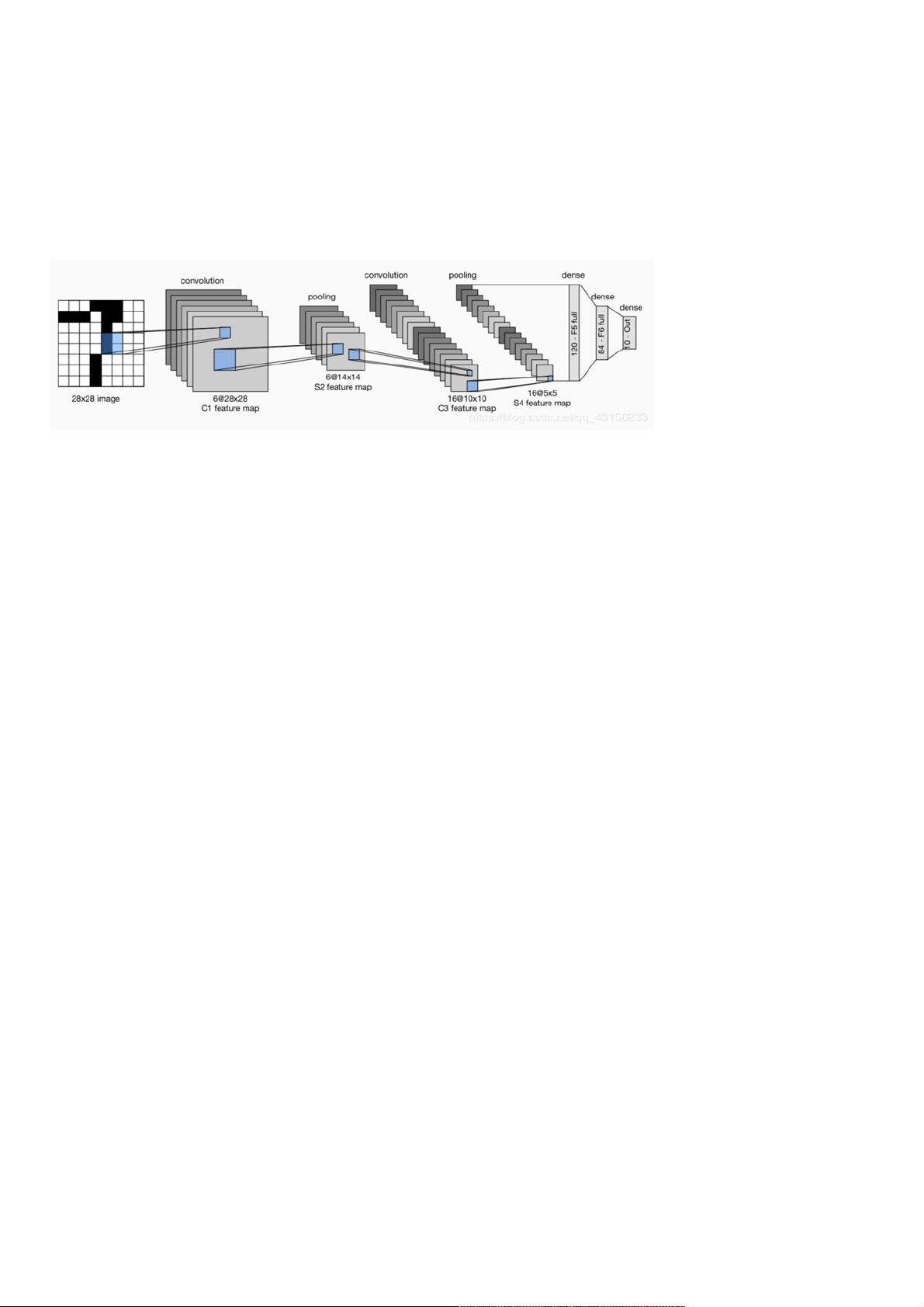

LeNet 模型模型

LeNet分为卷积层块和全连接层块两个部分。下面我们分别介绍这两个模块.

卷积层块里的基本单位是卷积层后接平均池化层:卷积层用来识别图像里的空间模式,如线条和物体局部,之后的平均池化层则用来降低卷积层对位置的敏感

性。

卷积层块由两个这样的基本单位重复堆叠构成。在卷积层块中,每个卷积层都使用5×5的窗口,并在输出上使用sigmoid激活函数。第一个卷积层输出通道数为

6,第二个卷积层输出通道数则增加到16。

全连接层块含3个全连接层。它们的输出个数分别是120、84和10,其中10为输出的类别个数。

下面我们通过Sequential类来实现LeNet模型。

#import

import sys

sys.path.append("/home/kesci/input")

import d2lzh1981 as d2l

import torch

import torch.nn as nn

import torch.optim as optim

import time

net

class Flatten(torch.nn.Module): #展平操作

def forward(self, x):

return x.view(x.shape[0], -1)

class Reshape(torch.nn.Module): #将图像大小重定型

def forward(self, x):

return x.view(-1,1,28,28) #(B x C x H x W)

net = torch.nn.Sequential( #Lelet

Reshape(),

nn.Conv2d(in_channels=1, out_channels=6, kernel_size=5, padding=2), #b*1*28*28 =>b*6*28*28

nn.Sigmoid(),

nn.AvgPool2d(kernel_size=2, stride=2), #b*6*28*28 =>b*6*14*14

nn.Conv2d(in_channels=6, out_channels=16, kernel_size=5), #b*6*14*14 =>b*16*10*10

nn.Sigmoid(),

nn.AvgPool2d(kernel_size=2, stride=2), #b*16*10*10 => b*16*5*5

Flatten(), #b*16*5*5 => b*400

nn.Linear(in_features=16*5*5, out_features=120),

nn.Sigmoid(),

nn.Linear(120, 84),

nn.Sigmoid(),

nn.Linear(84, 10)

接下来我们构造一个高和宽均为28的单通道数据样本,并逐层进行前向计算来查看每个层的输出形状。

#print

X = torch.randn(size=(1,1,28,28), dtype = torch.float32)

for layer in net:

X = layer(X)

print(layer.__class__.__name__,'output shape: ',X.shape)

Reshape output shape: torch.Size([1, 1, 28, 28])

Conv2d output shape: torch.Size([1, 6, 28, 28])

Sigmoid output shape: torch.Size([1, 6, 28, 28])

AvgPool2d output shape: torch.Size([1, 6, 14, 14])

Conv2d output shape: torch.Size([1, 16, 10, 10])

Sigmoid output shape: torch.Size([1, 16, 10, 10])

AvgPool2d output shape: torch.Size([1, 16, 5, 5])

Flatten output shape: torch.Size([1, 400])

Linear output shape: torch.Size([1, 120])

Sigmoid output shape: torch.Size([1, 120])

Linear output shape: torch.Size([1, 84])

Sigmoid output shape: torch.Size([1, 84])

Linear output shape: torch.Size([1, 10])

可以看到,在卷积层块中输入的高和宽在逐层减小。卷积层由于使用高和宽均为5的卷积核,从而将高和宽分别减小4,而池化层则将高和宽减半,但通道数则从

1增加到16。全连接层则逐层减少输出个数,直到变成图像的类别数10。