深度学习入门:卷积神经网络详解

版权申诉

190 浏览量

更新于2024-06-29

收藏 2.42MB PDF 举报

"卷积神经网络(基础入门PPT).pdf"

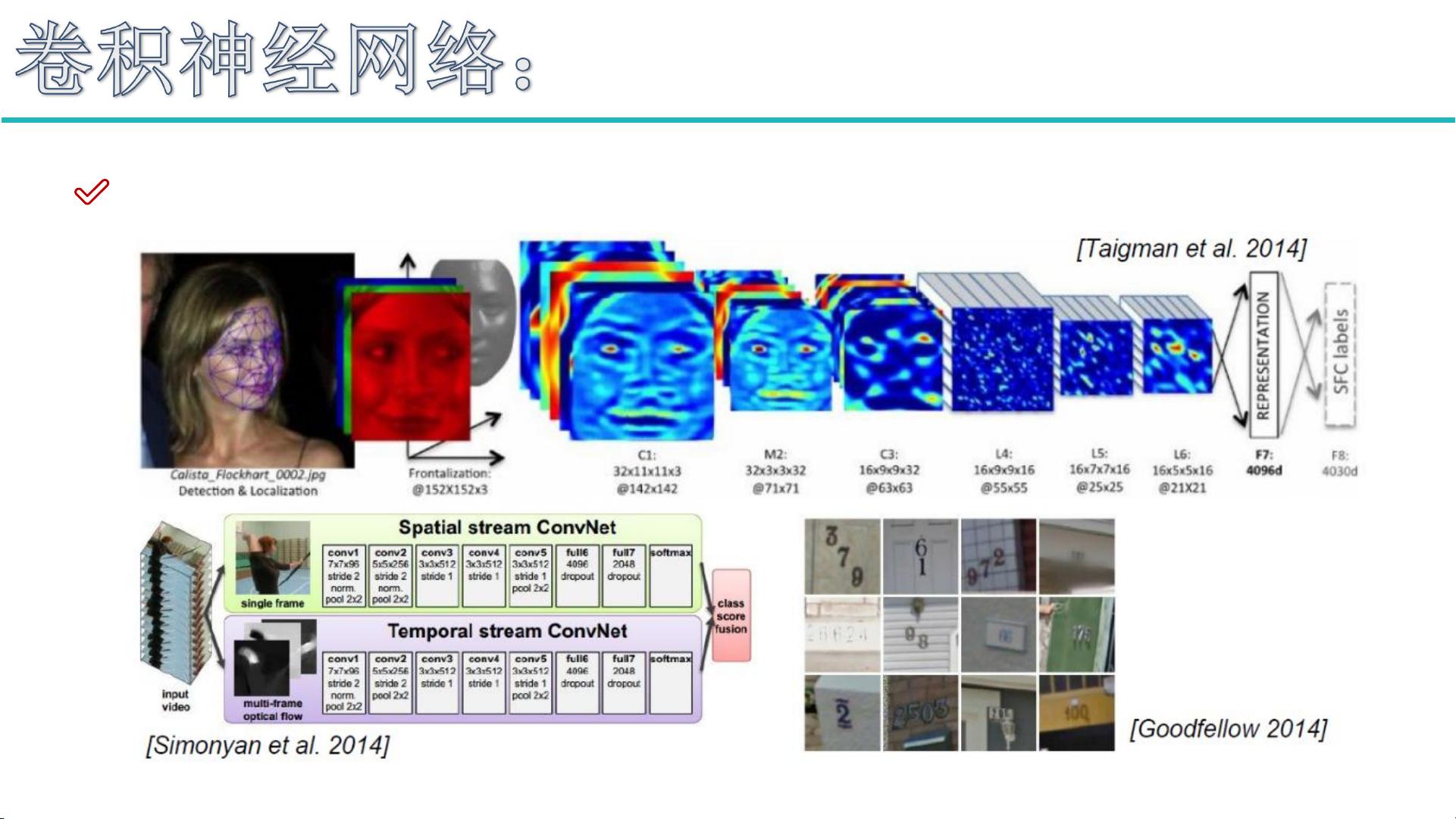

卷积神经网络(CNN)是深度学习领域中的核心组成部分,尤其在图像处理和计算机视觉(CV)任务中扮演着重要角色。CNN的设计灵感来源于人脑的视觉皮层,能够自动学习和识别图像中的特征,从而进行图像分类、检测、超分辨率重构、医学图像分析、无人驾驶、人脸识别等多种应用。

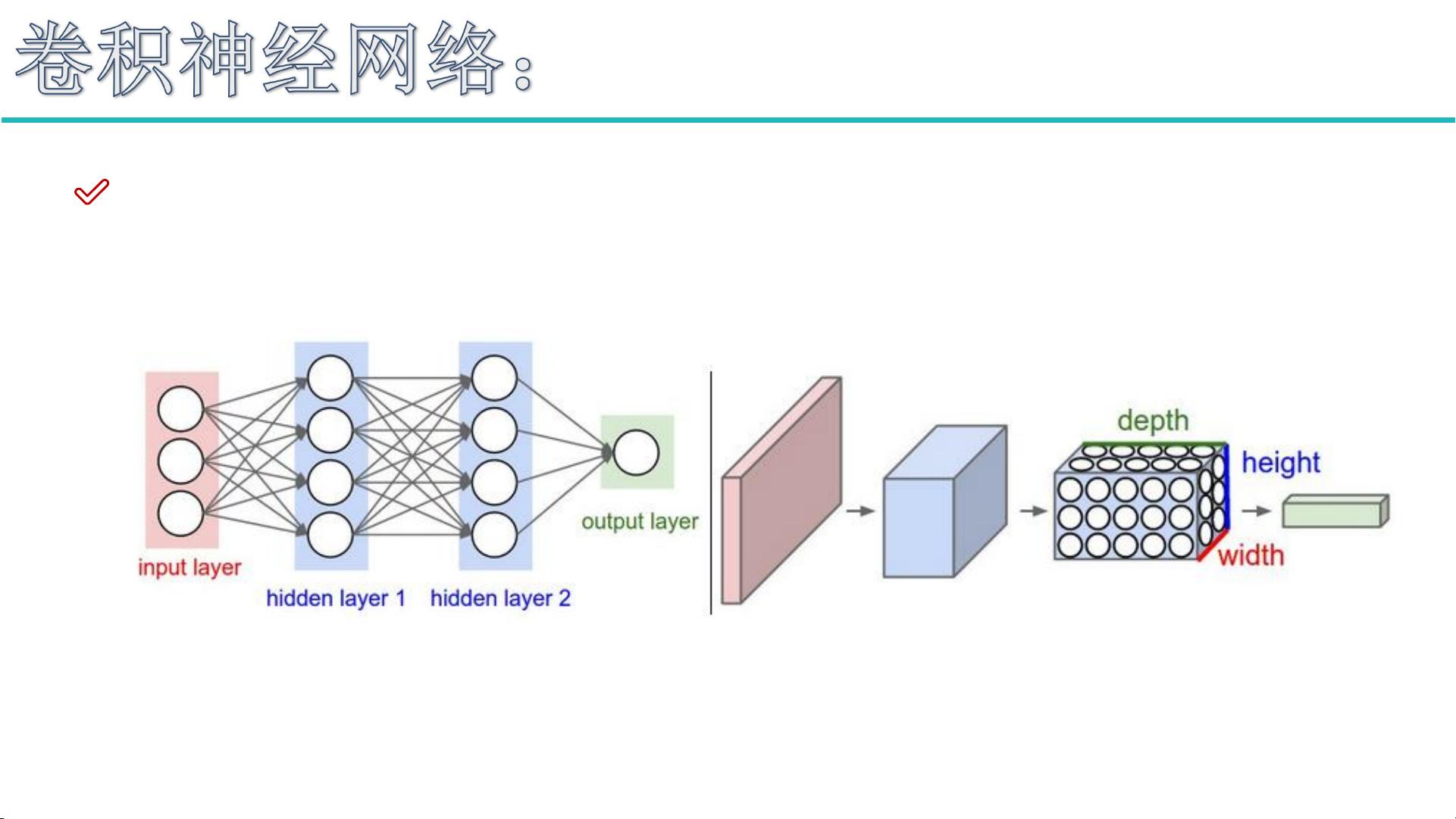

CNN的整体架构通常由以下几个部分组成:

1. 输入层:接收输入数据,如图像,通常是RGB三通道的彩色图像。

2. 卷积层:是CNN的核心,通过滑动的卷积核对输入数据进行扫描,提取特征。卷积核的大小、数量以及是否使用边界填充(padding)都会影响输出特征图的形状和网络的表达能力。

3. 池化层:用于降低数据的空间维度,减少计算量,同时保持关键信息。最常见的是最大池化,它保留每个区域的最大值。

4. 全连接层:将特征图展平并连接到一系列神经元,用于最后的分类或回归任务。

卷积层的几个关键参数包括:

- 滑动窗口步长(Stride):决定了卷积核移动的距离,步长为1时,卷积核每次移动一个像素。

- 卷积核尺寸(Filter Size):决定了卷积核的大小,如5x5或3x3。

- 边界填充(Padding):在输入图像边缘添加0,以保持输出特征图的尺寸不变。

- 卷积核个数:决定输出特征图的个数,每个特征图对应一个卷积核。

卷积过程中的参数共享机制显著减少了模型的参数数量。例如,对于一个32x32x3的图像,使用10个5x5x3的卷积核进行卷积,步长为1,填充为2,输出规模为32x32x10。每个卷积核需要75个参数(5x5x3),10个卷积核总共需要750个卷积核参数,加上10个偏置项,总共有760个权重参数。

经典网络如AlexNet引入了更深的结构和ReLU激活函数,缓解了早期神经网络的过拟合问题。VGG网络则主张使用较小的3x3卷积核堆叠起来,以增加网络深度,同时保持参数数量相对较少,通过多层卷积提高特征提取的精度。ResNet(残差网络)进一步解决了深度网络中的梯度消失问题,通过引入残差块使信号可以直接“跳跃”过某些层,使得训练非常深的网络成为可能。

卷积神经网络通过其独特的设计,实现了在图像处理领域的高效特征学习和表示,不断推动了计算机视觉和人工智能技术的发展。

751 浏览量

536 浏览量

1244 浏览量

184 浏览量

追光者♂

- 粉丝: 2w+

- 资源: 527