Python工作流神器:Airflow入门与DAG设计

81 浏览量

更新于2024-08-28

收藏 600KB PDF 举报

Airflow:Python工作流管理利器

Apache Airflow是一个强大的开源工具,专为复杂的计算工作流和数据处理任务设计。针对长时间运行的cron脚本或大规模数据批处理,Airflow提供了灵活、高效的解决方案。作为一款基于Python构建的工具,Airflow的工作流设计核心是有向无环图(DAG),它允许开发者将任务分解为独立执行的部分,形成一个逻辑上相互关联的图形结构。DAG的结构不仅定义了工作流程的执行顺序,还能支持多分支和错误处理,确保即使出现故障也能通过任务重试或暂停/恢复来保持流程的弹性。

Airflow中的关键概念包括:

1. DAGs (Directed Acyclic Graphs):DAGs是由一系列任务组成的集合,每个任务作为一个Operator实现,它们之间通过依赖关系连接起来。

2. Operators:每个任务在Airflow中表现为一个Operator,负责执行特定的功能,如数据处理、查询或调用API。

3. DagRun:当DAG启动时,会在Airflow数据库中创建一个新的DagRun记录,表示一次完整的任务执行周期。

4. Task Instances:任务实例是在DagRun上下文中的具体执行单元,它们根据DAG的调度规则被创建并运行。

5. 幂等性:Airflow中的任务必须设计为幂等的,即多次执行不会带来副作用,这对于重复执行的任务尤为重要。

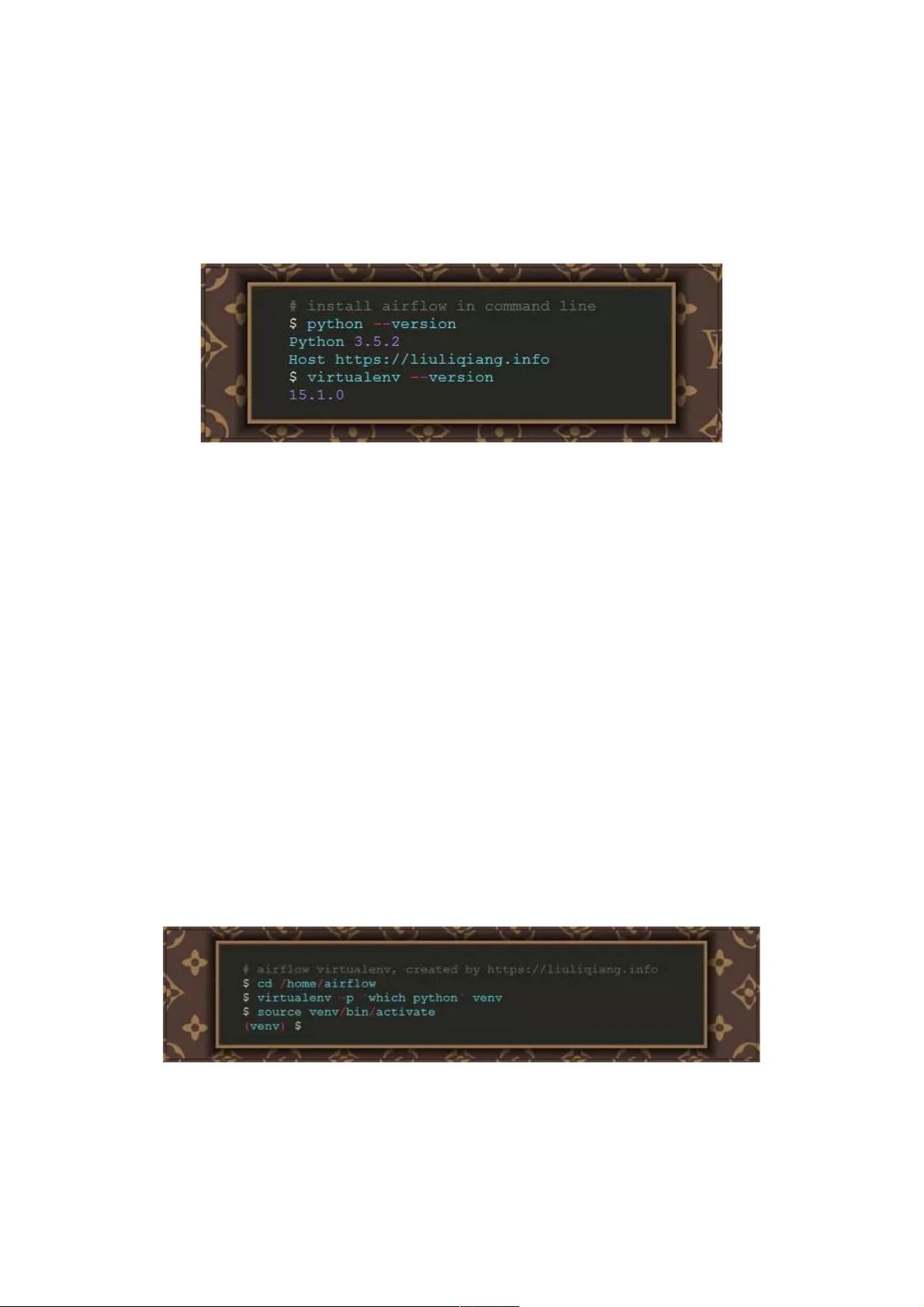

在使用Airflow时,环境准备至关重要。由于Airflow基于Python,推荐使用Python 3(至少3.5版本),因为它提供了更好的性能和更丰富的库支持。开发环境可以通过virtualenv进行管理,保持隔离。对于安装,建议创建专用的Airflow用户和目录,如`/home/airflow`,以便于管理。

在安装Airflow时,确保遵循官方文档提供的指南,可能涉及到安装Python包、配置环境变量、设置Web服务器和调度器等步骤。对于初次使用者,了解基本的配置和初始化过程也是入门的重要环节。

Airflow凭借其强大的灵活性和易用性,成为Python开发者在处理数据处理和自动化任务时的首选工具。通过理解DAG的概念和关键术语,以及正确设置和管理环境,开发者能够充分利用Airflow来优化和扩展他们的工作流程。

2022-03-27 上传

2021-03-26 上传

2019-01-07 上传

点击了解资源详情

2022-03-02 上传

2022-03-02 上传

2022-03-02 上传

2021-04-26 上传

2022-01-11 上传

weixin_38745003

- 粉丝: 10

- 资源: 947

最新资源

- 全国江河水系图层shp文件包下载

- 点云二值化测试数据集的详细解读

- JDiskCat:跨平台开源磁盘目录工具

- 加密FS模块:实现动态文件加密的Node.js包

- 宠物小精灵记忆配对游戏:强化你的命名记忆

- React入门教程:创建React应用与脚本使用指南

- Linux和Unix文件标记解决方案:贝岭的matlab代码

- Unity射击游戏UI套件:支持C#与多种屏幕布局

- MapboxGL Draw自定义模式:高效切割多边形方法

- C语言课程设计:计算机程序编辑语言的应用与优势

- 吴恩达课程手写实现Python优化器和网络模型

- PFT_2019项目:ft_printf测试器的新版测试规范

- MySQL数据库备份Shell脚本使用指南

- Ohbug扩展实现屏幕录像功能

- Ember CLI 插件:ember-cli-i18n-lazy-lookup 实现高效国际化

- Wireshark网络调试工具:中文支持的网口发包与分析