深度学习面试必备:神经网络基础与激活函数解析

需积分: 0 105 浏览量

更新于2024-08-05

2

收藏 1.3MB PDF 举报

"这篇博客是关于深度学习和机器学习面试问题的整理,涵盖了神经网络基础、梯度消失和梯度爆炸、以及常见的激活函数等核心知识点。"

深度学习是当前人工智能领域的重要分支,主要依赖于神经网络模型进行复杂的模式识别和预测任务。在面试或笔试中,对深度学习的理解通常包括其基本构成和算法原理。以下是深度学习的一些关键知识点:

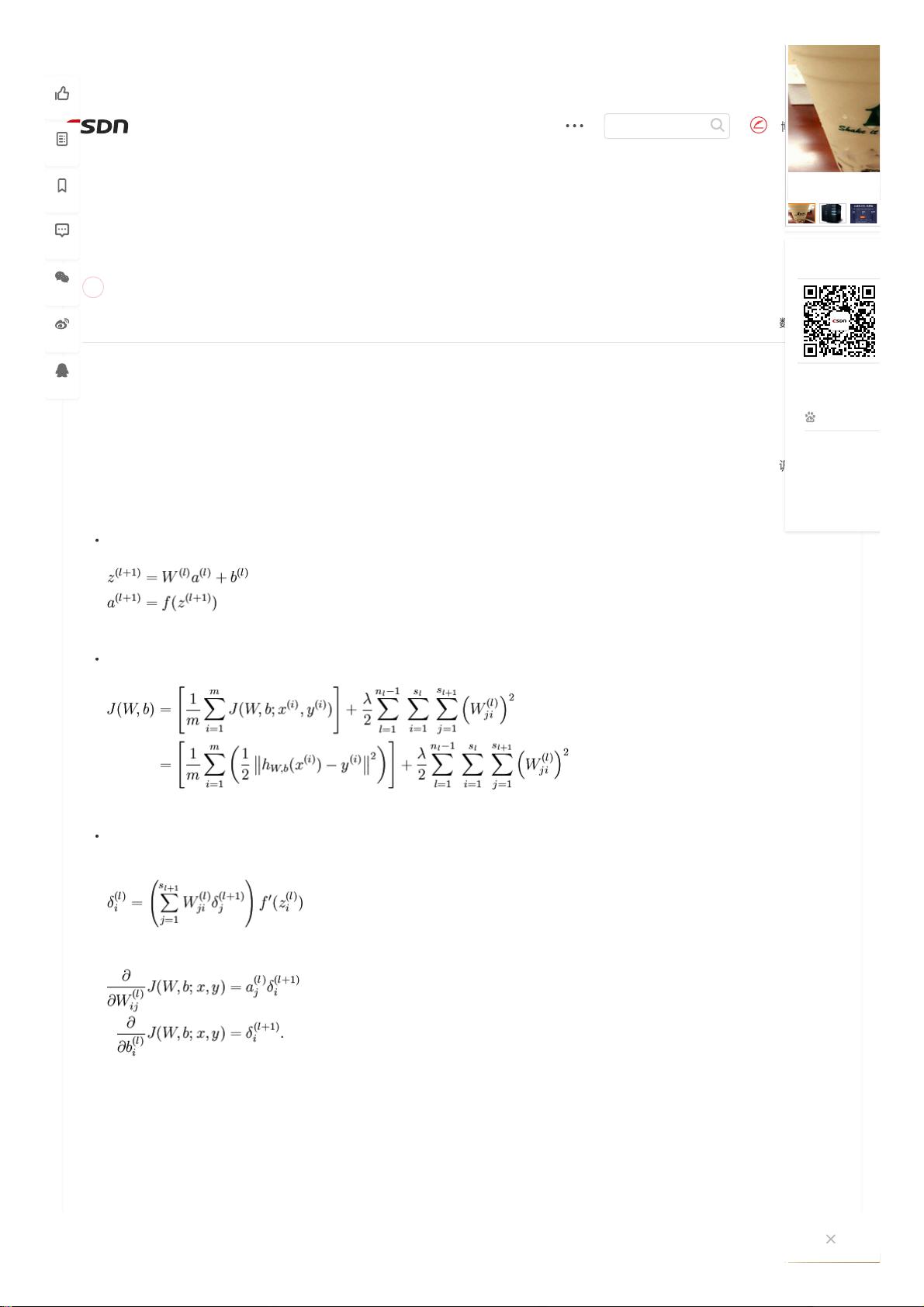

1. **神经网络基础**:

- **Backpropagation(反向传播)**:反向传播是训练神经网络的核心算法,它利用链式法则计算损失函数对网络中每个参数的梯度,从而更新参数。在初始化参数时,应避免所有参数均为0,以防止对称失效,即所有神经元产生相同的输出。

2. **梯度消失与梯度爆炸**:

- **梯度消失**:主要发生在使用sigmoid或tanh这类在饱和区导数接近0的激活函数时,反向传播过程中梯度逐层衰减,导致网络的前面层几乎无法更新,影响学习效果。

- **梯度爆炸**:相反,如果激活函数导数较大且权重初始值过大,可能导致梯度的快速增长,同样不利于网络训练。这种情况相对较罕见,但仍然需要关注。

3. **激活函数**:

- **Sigmoid**:其输出范围在(0,1)之间,存在梯度消失问题,且不是中心对称,容易导致训练中的梯度消失问题。

- **ReLU (Rectified Linear Unit)**:解决了梯度消失问题,但在负区间为0,可能导致“死亡ReLU”现象,即某些神经元永远不会被激活。

- **Leaky ReLU**:为了解决ReLU的问题,它在负区间有一个小的斜率,允许少量负向信号传递。

- **ELU (Exponential Linear Units)**:进一步改善了ReLU,通过指数形式在负区间平滑了输出,有助于改善梯度消失并加快收敛速度。

- **ReLU6**:在ReLU的基础上限制了输出范围在[0,6],常用于计算机视觉任务,如MobileNetV2等模型。

- **Softmax**:常用于多分类任务,将神经元的激活值转换为概率分布。

此外,描述中提及的数据增强和池化技术也是深度学习中的重要概念。**数据增强**通过旋转、翻转、裁剪等方式增加训练数据的多样性,帮助模型泛化能力提升。**池化操作**则用于减少数据的维度,降低计算复杂度,同时保持特征的局部信息。

对于卷积神经网络(CNN),1x1和3x3的卷积核以及2x2的最大池化是常见的设计。1x1卷积可以用来减少通道数,降低模型复杂度;3x3卷积可以捕获局部特征;2x2最大池化则可以减小特征图的尺寸,提高计算效率。

最后,三个卷积层加一个最大池化,再加上三个全连接层,这种网络结构通常用于图像识别任务,如AlexNet或VGGNet。这些全连接层负责从卷积层提取的特征中学习全局模式,最终实现分类或回归。

在机器学习面试中,对这些基础知识的深入理解是必不可少的,面试者还需要掌握优化算法(如梯度下降、Adam)、损失函数、正则化策略等方面的知识,以展示全面的理论和技术能力。

2022-08-03 上传

2018-03-07 上传

2022-08-03 上传

2024-02-05 上传

2022-10-29 上传

2021-01-17 上传

229 浏览量

李多田

- 粉丝: 485

- 资源: 333

最新资源

- 开源通讯录备份系统项目,易于复刻与扩展

- 探索NX二次开发:UF_DRF_ask_id_symbol_geometry函数详解

- Vuex使用教程:详细资料包解析与实践

- 汉印A300蓝牙打印机安卓App开发教程与资源

- kkFileView 4.4.0-beta版:Windows下的解压缩文件预览器

- ChatGPT对战Bard:一场AI的深度测评与比较

- 稳定版MySQL连接Java的驱动包MySQL Connector/J 5.1.38发布

- Zabbix监控系统离线安装包下载指南

- JavaScript Promise代码解析与应用

- 基于JAVA和SQL的离散数学题库管理系统开发与应用

- 竞赛项目申报系统:SpringBoot与Vue.js结合毕业设计

- JAVA+SQL打造离散数学题库管理系统:源代码与文档全览

- C#代码实现装箱与转换的详细解析

- 利用ChatGPT深入了解行业的快速方法论

- C语言链表操作实战解析与代码示例

- 大学生选修选课系统设计与实现:源码及数据库架构