SparkonPADDLE:百度的异构分布式深度学习系统

77 浏览量

更新于2024-08-27

收藏 350KB PDF 举报

百度基于Spark构建了一个异构分布式深度学习平台,名为SparkonPADDLE,该平台将Spark与深度学习平台PADDLE相结合,解决了PADDLE与其他业务逻辑间的数据传输问题,并利用GPU和FPGA的异构计算能力提升了处理效率。此外,平台采用YARN对异构资源进行分配,支持多租户(Multi-Tenancy),优化了资源利用率。

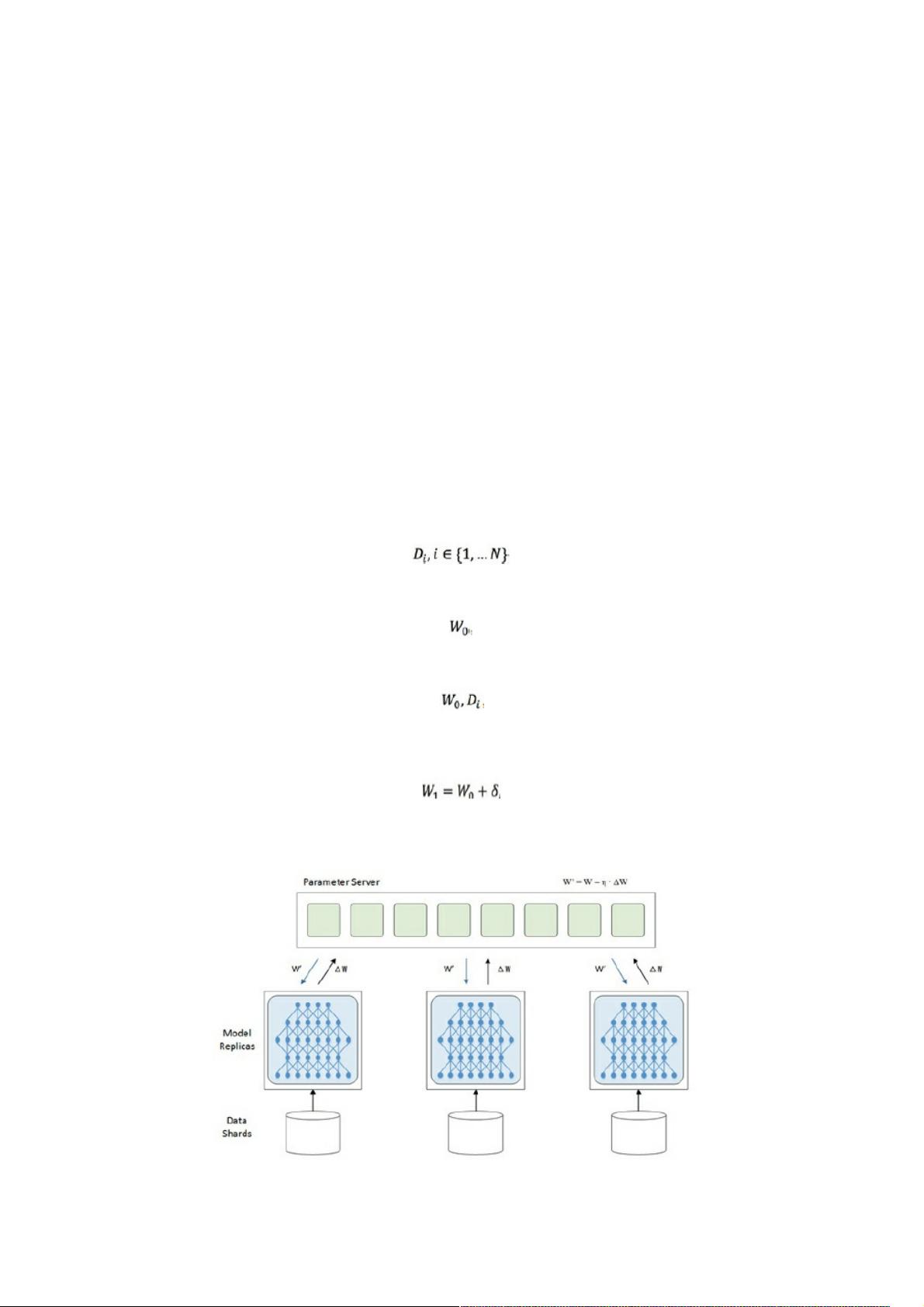

深度学习平台PADDLE由百度深度学习实验室开发,设计重点在于优化训练算法,支持多GPU/CPU并行训练,尤其适合处理大规模的稀疏特征数据。PADDLE的并行训练策略包括数据并行和模型并行,其中数据并行是常见的分布式训练方法,通过拆分大数据集并在多个机器上同时训练,确保模型的同步和收敛性,通常采用参数服务器架构来实现。

SparkonPADDLE的创新之处在于它将PADDLE集成到Spark生态系统中,使得深度学习成为Spark的一个功能模块,从而便于与其他业务逻辑协同工作。在应对大规模数据需求时,平台增加了对GPU和FPGA的异构计算支持,以显著提高数据处理速度。通过YARN进行资源管理,可以有效地分配和调度GPU、FPGA等异构资源,实现更高效的任务执行。

在深度学习中,GPU因其并行计算能力而被广泛用于加速计算密集型任务,如神经网络的前向传播和反向传播。FPGA(现场可编程门阵列)则提供了定制化计算的能力,可以根据特定算法进行优化,进一步提升计算效率。在SparkonPADDLE中,这两种硬件资源的结合使得平台能够处理更大规模的数据集,同时保持高效率,这对于在语音识别、图像处理、自然语言理解和自动驾驶等领域的深度学习应用至关重要。

SparkonPADDLE是百度应对深度学习大规模分布式训练挑战的解决方案,它融合了Spark的灵活性和PADDLE的高性能训练能力,通过异构计算和资源管理优化,提升了深度学习在百度内部各业务线的应用效率和普及程度。这一平台的建立,不仅解决了现有深度学习平台与业务逻辑间的协作问题,也为其他企业提供了借鉴,展示了如何构建一个高效、灵活且适应性强的深度学习环境。

2021-08-08 上传

2020-02-06 上传

2021-09-19 上传

2024-04-20 上传

2023-10-11 上传

2023-06-02 上传

2023-02-08 上传

2023-09-16 上传

2024-04-03 上传

weixin_38734200

- 粉丝: 6

- 资源: 914

最新资源

- BottleJS快速入门:演示JavaScript依赖注入优势

- vConsole插件使用教程:输出与复制日志文件

- Node.js v12.7.0版本发布 - 适合高性能Web服务器与网络应用

- Android中实现图片的双指和双击缩放功能

- Anum Pinki英语至乌尔都语开源词典:23000词汇会话

- 三菱电机SLIMDIP智能功率模块在变频洗衣机的应用分析

- 用JavaScript实现的剪刀石头布游戏指南

- Node.js v12.22.1版发布 - 跨平台JavaScript环境新选择

- Infix修复发布:探索新的中缀处理方式

- 罕见疾病酶替代疗法药物非临床研究指导原则报告

- Node.js v10.20.0 版本发布,性能卓越的服务器端JavaScript

- hap-java-client:Java实现的HAP客户端库解析

- Shreyas Satish的GitHub博客自动化静态站点技术解析

- vtomole个人博客网站建设与维护经验分享

- MEAN.JS全栈解决方案:打造MongoDB、Express、AngularJS和Node.js应用

- 东南大学网络空间安全学院复试代码解析