清华机器学习课程:第15章奇异值分解,入门与详解

版权申诉

197 浏览量

更新于2024-07-04

收藏 3.67MB PPTX 举报

本资源是一份清华大学出品的机器学习技术课程,专注于统计学习方法的第二版,其中详细讲解了第15章——奇异值分解(Singular Value Decomposition, SVD)。SVD是线性代数中的一个重要概念,它对任意矩阵(包括非方阵)进行分解,揭示了矩阵的内在结构和特征。以下是该章节的关键知识点:

1. 奇异值分解的定义与定理:

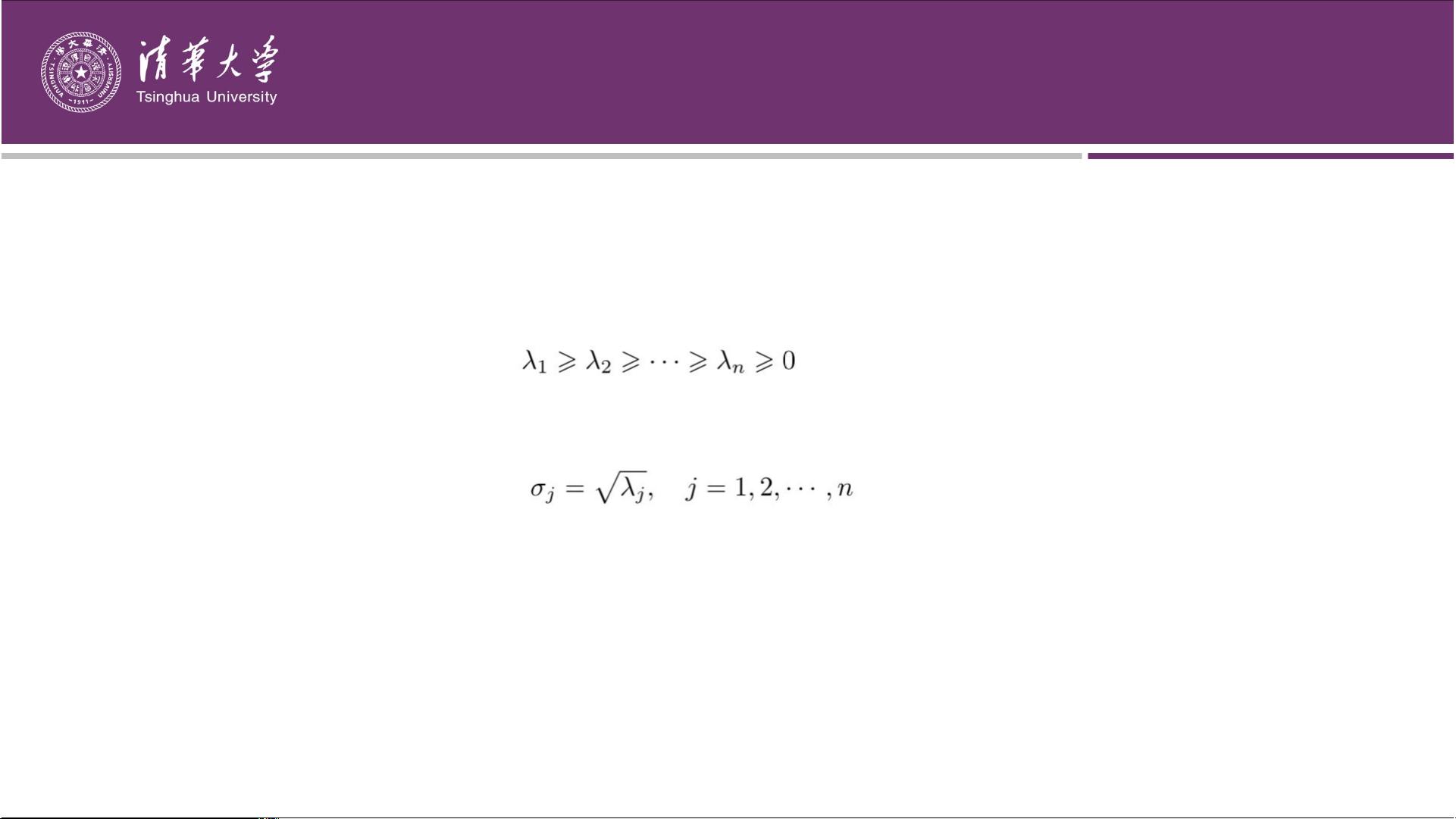

- 对于矩阵A,SVD将其表示为UΣV^T,其中U是m阶正交矩阵,V是n阶正交矩阵,Σ是对角矩阵,其元素是非负的奇异值,按降序排列。

- 不要求A必须是方阵,SVD可以视为对称矩阵对角化的一种扩展。

2. 实例解析:

- 提供了一个5x4矩阵的SVD例子,展示了如何通过三个矩阵的乘积来表示,并指出奇异值分解不唯一,不同选择的正交矩阵U可以得到不同的分解。

3. 奇异值分解的基本定理:

- 定理保证了任何mxn实矩阵都有SVD。

- A的奇异值分解形式为A=UΣV^T,其中Σ的对角元素是A的奇异值,U和V是正交矩阵。

- 证明过程中,首先通过ATA的对角化找到正交矩阵V,然后选取相应的特征值(即奇异值)和特征向量构建Σ。

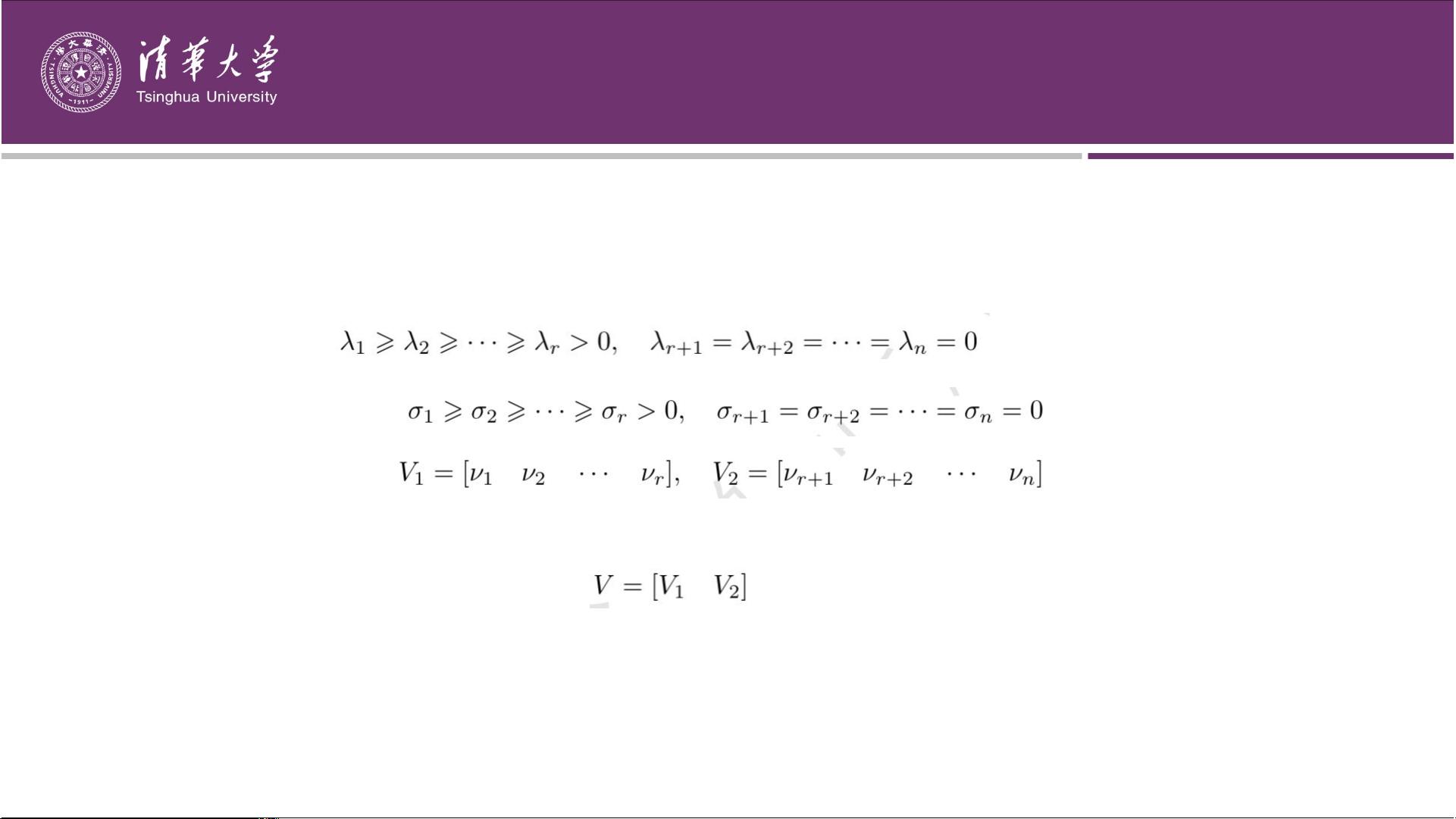

4. 秩和奇异值的关系:

- 如果矩阵A的秩为r,那么矩阵ATA的秩也是r,且正特征值的数量对应于矩阵的秩。

5. SVD的构造过程:

- 当矩阵A的秩为r时,选取ATA的正特征值对应的特征向量构成V的前r行,形成r阶对角矩阵Σ。

- Σ的对角元素是奇异值,而剩余的特征向量对应于零特征值,形成V的其余部分。

6. SVD的应用和性质:

- SVD广泛应用于数据压缩、信号处理、图像处理等领域,因其能够减少数据的维度,同时保留关键信息。

- 在机器学习中,SVD可以用于降维、特征提取以及解决某些优化问题。

通过这份详细的SVD讲解,学习者可以深入理解这一基础但强大的工具在机器学习中的应用,无论是作为入门知识还是复习巩固,都将有助于提升对复杂数据分析的理解和能力。

2022-04-30 上传

2022-05-03 上传

2022-05-03 上传

2022-05-03 上传

2022-05-03 上传

2022-05-03 上传

2022-05-03 上传

2022-05-03 上传

2022-05-03 上传

passionSnail

- 粉丝: 456

- 资源: 7220

最新资源

- 黑板风格计算机毕业答辩PPT模板下载

- CodeSandbox实现ListView快速创建指南

- Node.js脚本实现WXR文件到Postgres数据库帖子导入

- 清新简约创意三角毕业论文答辩PPT模板

- DISCORD-JS-CRUD:提升 Discord 机器人开发体验

- Node.js v4.3.2版本Linux ARM64平台运行时环境发布

- SQLight:C++11编写的轻量级MySQL客户端

- 计算机专业毕业论文答辩PPT模板

- Wireshark网络抓包工具的使用与数据包解析

- Wild Match Map: JavaScript中实现通配符映射与事件绑定

- 毕业答辩利器:蝶恋花毕业设计PPT模板

- Node.js深度解析:高性能Web服务器与实时应用构建

- 掌握深度图技术:游戏开发中的绚丽应用案例

- Dart语言的HTTP扩展包功能详解

- MoonMaker: 投资组合加固神器,助力$GME投资者登月

- 计算机毕业设计答辩PPT模板下载