淘宝TFS架构升级:数据可靠性与负载均衡的关键策略

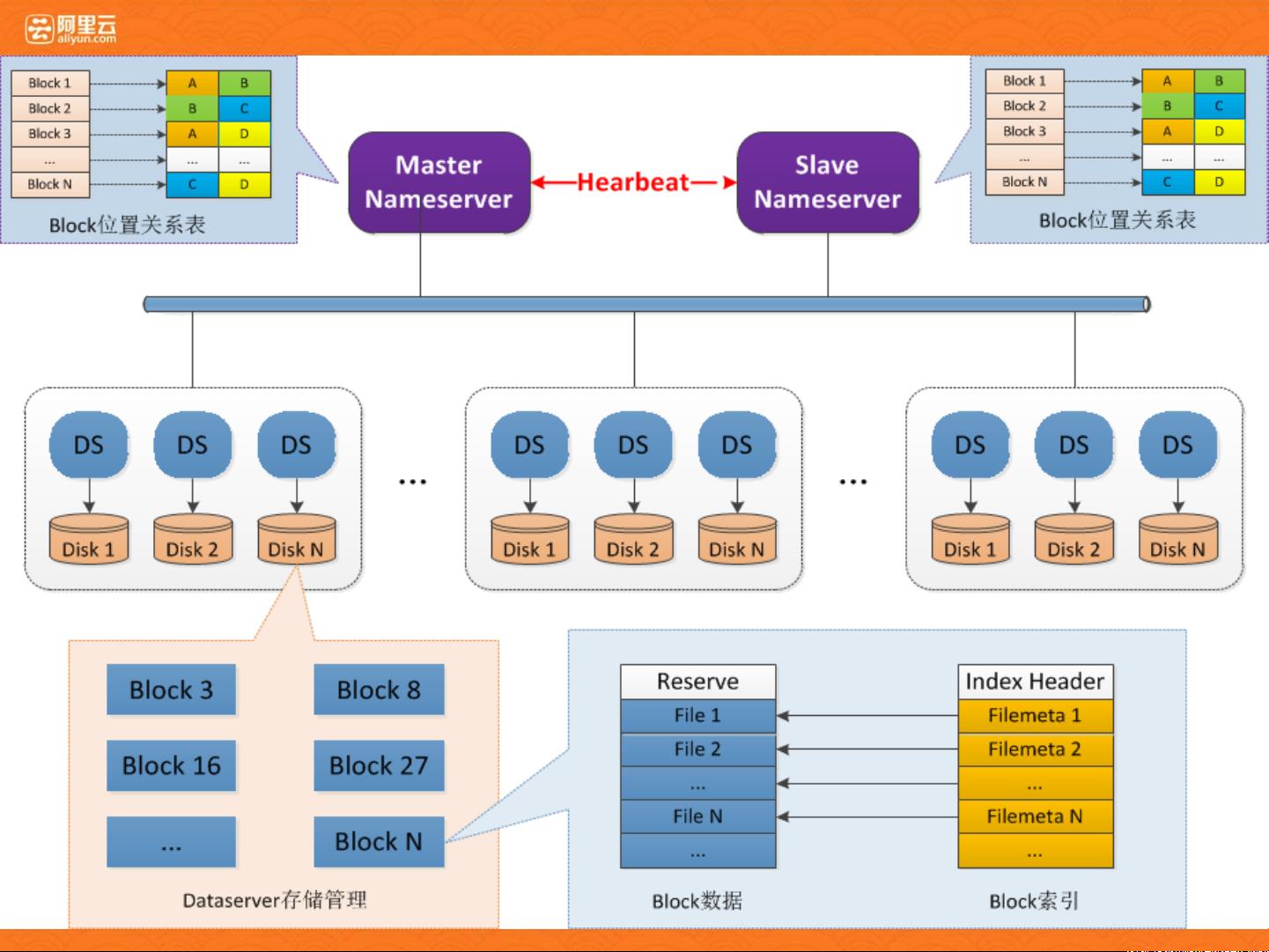

淘宝TFS架构是阿里巴巴集团内部用于海量数据存储和处理的关键组件,经历了长期的演进和发展。该架构最初是为了满足淘宝平台的高可用性和数据可靠性需求而设计的。TFS的核心组件包括Master(主服务器)、NS(命名空间服务)、Client(客户端)、Primary和Secondary副本等,它们共同协作来提供文件的高效读写、副本安全、负载均衡、删除空间回收、缓存机制以及容灾备份功能。

在写入阶段,TFS确保所有副本的数据一致性,只有当所有副本都成功写入后,客户端才会收到文件名,其中包含了文件类型、集群号、block ID和file ID等信息。为了保障数据安全,即使在单个节点故障时,TFS也能通过自动复制和副本恢复策略保证数据不丢失。此外,TFS通过负载均衡机制,当集群扩容时,可以自动迁移数据到新的存储节点,以保持性能的稳定。

删除文件时,TFS采用“删除标记”策略,当块内文件删除量达到阈值时,触发Compact过程来回收空间。客户端在访问文件时,首先会在本地缓存和Tair缓存中查找,如果未找到则回源至NS查询。同时,TFS有文件排重机制,防止存储重复内容的文件,但这一特性限制了部分场景下的文件更新。

对于大文件存储,TFS将大文件切割成多个小文件存储,并将这些小文件的元信息整合到一个小文件中,提高了存储效率。用户还可以根据需要自定义文件名,增加灵活性。

在容灾方面,TFS支持主集群与备集群之间的数据同步,用户可以配置多个主集群以实现多点写入,通过周期性对比主备数据一致性,确保数据的一致性。集群管理涉及到应用资源配置表和集群资源配置表,以及接口服务化的Nginx,它实现了负载均衡和客户端与服务端的通信。

在部署上,TFS的架构设计考虑到了高性能的访问和灵活的权限管理,如不同应用通过appkey和cluster进行区分,每个集群有多个存储节点,如host01到host04,节点之间通过VIP和权限控制(如rw或read-only)进行访问。

淘宝TFS架构的演进反映了其在不断适应业务增长和技术发展的同时,对数据可靠性、性能优化、扩展性和容灾能力的持续强化,为淘宝平台提供了强大的数据支撑。

2023-05-15 上传

2023-06-03 上传

2023-06-03 上传

2024-04-29 上传

2023-06-06 上传

2023-06-09 上传

gaoshui87

- 粉丝: 13

- 资源: 4

最新资源

- C语言快速排序算法的实现与应用

- KityFormula 编辑器压缩包功能解析

- 离线搭建Kubernetes 1.17.0集群教程与资源包分享

- Java毕业设计教学平台完整教程与源码

- 综合数据集汇总:浏览记录与市场研究分析

- STM32智能家居控制系统:创新设计与无线通讯

- 深入浅出C++20标准:四大新特性解析

- Real-ESRGAN: 开源项目提升图像超分辨率技术

- 植物大战僵尸杂交版v2.0.88:新元素新挑战

- 掌握数据分析核心模型,预测未来不是梦

- Android平台蓝牙HC-06/08模块数据交互技巧

- Python源码分享:计算100至200之间的所有素数

- 免费视频修复利器:Digital Video Repair

- Chrome浏览器新版本Adblock Plus插件发布

- GifSplitter:Linux下GIF转BMP的核心工具

- Vue.js开发教程:全面学习资源指南