Elasticsearch数据安全:如何确保数据不丢失的机制解析

需积分: 0 61 浏览量

更新于2024-08-05

收藏 253KB PDF 举报

"本文主要探讨了Elasticsearch如何确保数据在异常情况下的完整性,特别是通过transaction log(translog)机制来防止数据丢失。"

在Elasticsearch中,数据的持久化是一个关键问题,特别是在面对系统崩溃或意外断电时。为了解决这个问题,Elasticsearch引入了transaction log(交易日志)机制,类似于Hadoop的editslog和HBase的WALlog,用于记录每一个数据操作。以下是translog的工作流程和Elasticsearch如何保证数据不丢失的详细过程:

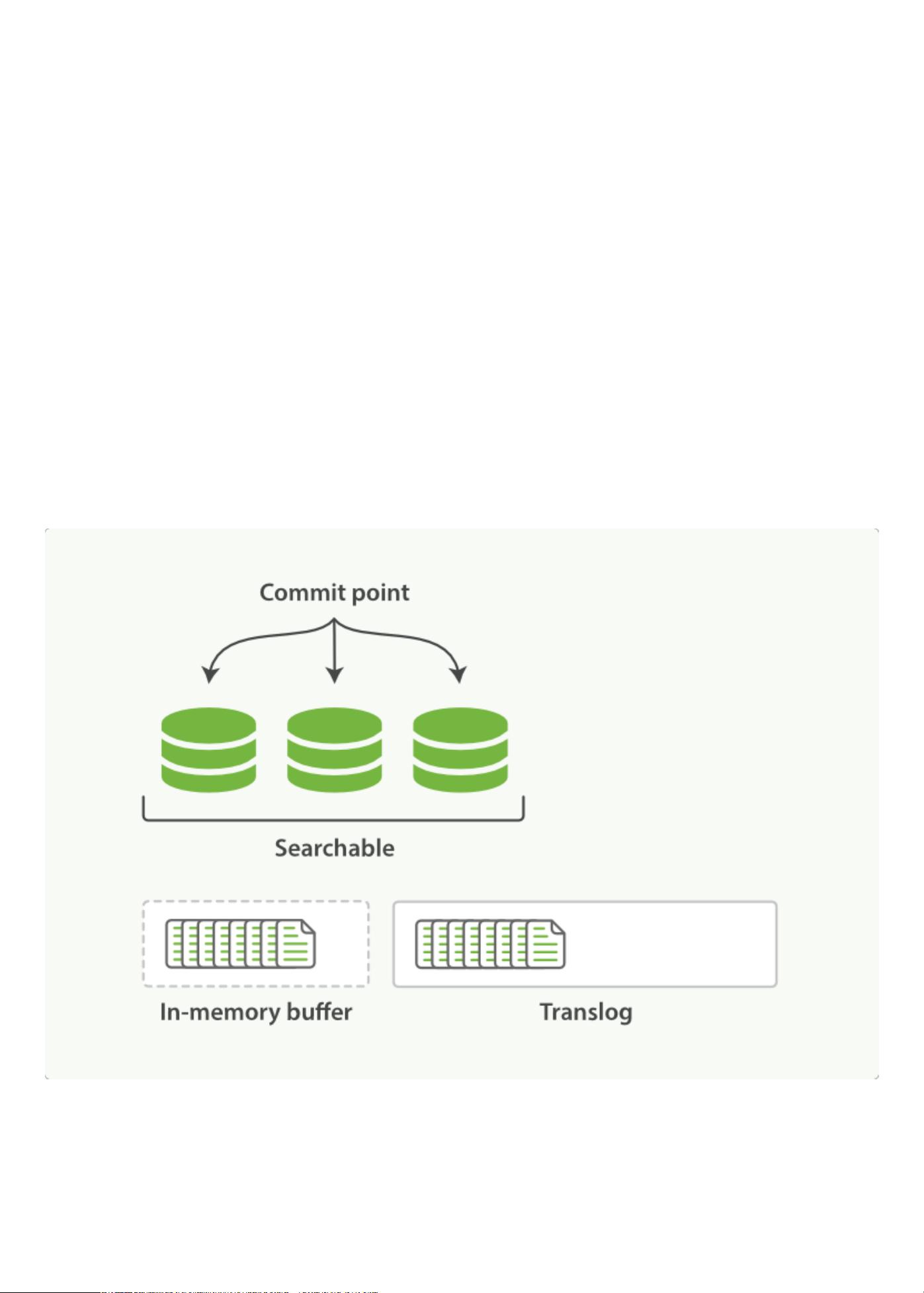

1. **数据索引**:当一个文档被索引时,它首先会被放入内存buffer,并同时在translog中记录。这样,即使数据尚未被刷新到磁盘,也已经在translog中有备份。

2. **refresh操作**:每个shard每隔一秒进行一次refresh,将内存buffer中的数据写入新的segment。然而,refresh后,内存buffer会被清空,但translog中的记录仍然保留。

3. **数据增长与translog累积**:随着更多文档被添加,内存buffer不断被刷新和清空,translog记录不断增加。此时,数据可以被搜索,但未被持久化到磁盘。

4. **flush操作**:当达到默认的30分钟或者translog达到一定大小时,会触发flush操作。这是一个完整的提交过程,包括以下步骤:

- **生成新segment**:内存buffer中的所有文档被写入一个新的segment。

- **refresh到cache**:新segment被刷新到系统缓存,此时数据对搜索可见,但内存buffer被清空。

- **commitpoint**:commitpoint(即当前的segment列表)被写入磁盘,标记数据已持久化。

- **flush cache**:通过fsync操作,filesystem cache被强制刷到磁盘,确保数据安全。

- **创建新的translog**:旧的translog关闭,新的translog开始记录后续的操作。

通过这个机制,Elasticsearch能够在系统崩溃后,根据translog中的记录重新执行未持久化的操作,从而恢复数据。即使在长时间未刷新到磁盘的情况下,也能保证在故障发生后,通过translog回放数据,减少可能的数据丢失。

Elasticsearch通过高效的refresh和flush策略,结合transaction log,实现了对数据的实时性和持久性的平衡。在提高搜索性能的同时,确保了在异常情况下的数据安全性。

171 浏览量

2024-01-03 上传

2024-07-18 上传

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

玛卡库克

- 粉丝: 35

- 资源: 309

最新资源

- Angular实现MarcHayek简历展示应用教程

- Crossbow Spot最新更新 - 获取Chrome扩展新闻

- 量子管道网络优化与Python实现

- Debian系统中APT缓存维护工具的使用方法与实践

- Python模块AccessControl的Windows64位安装文件介绍

- 掌握最新*** Fisher资讯,使用Google Chrome扩展

- Ember应用程序开发流程与环境配置指南

- EZPCOpenSDK_v5.1.2_build***版本更新详情

- Postcode-Finder:利用JavaScript和Google Geocode API实现

- AWS商业交易监控器:航线行为分析与营销策略制定

- AccessControl-4.0b6压缩包详细使用教程

- Python编程实践与技巧汇总

- 使用Sikuli和Python打造颜色求解器项目

- .Net基础视频教程:掌握GDI绘图技术

- 深入理解数据结构与JavaScript实践项目

- 双子座在线裁判系统:提高编程竞赛效率