回归与最优化详解:线性与Logistic回归,梯度下降与牛顿法

需积分: 28 182 浏览量

更新于2024-07-15

1

收藏 2.15MB PPT 举报

本资源主要涵盖了回归分析中的两种关键方法——线性回归和逻辑回归,以及最优化问题的解决策略,包括梯度下降、牛顿法和拟牛顿法。在讲解过程中,强调了参数学习算法与非参数学习算法的区别,并针对首次接触这些概念的学员,特别关注了未在初次介绍中深入探讨的部分。

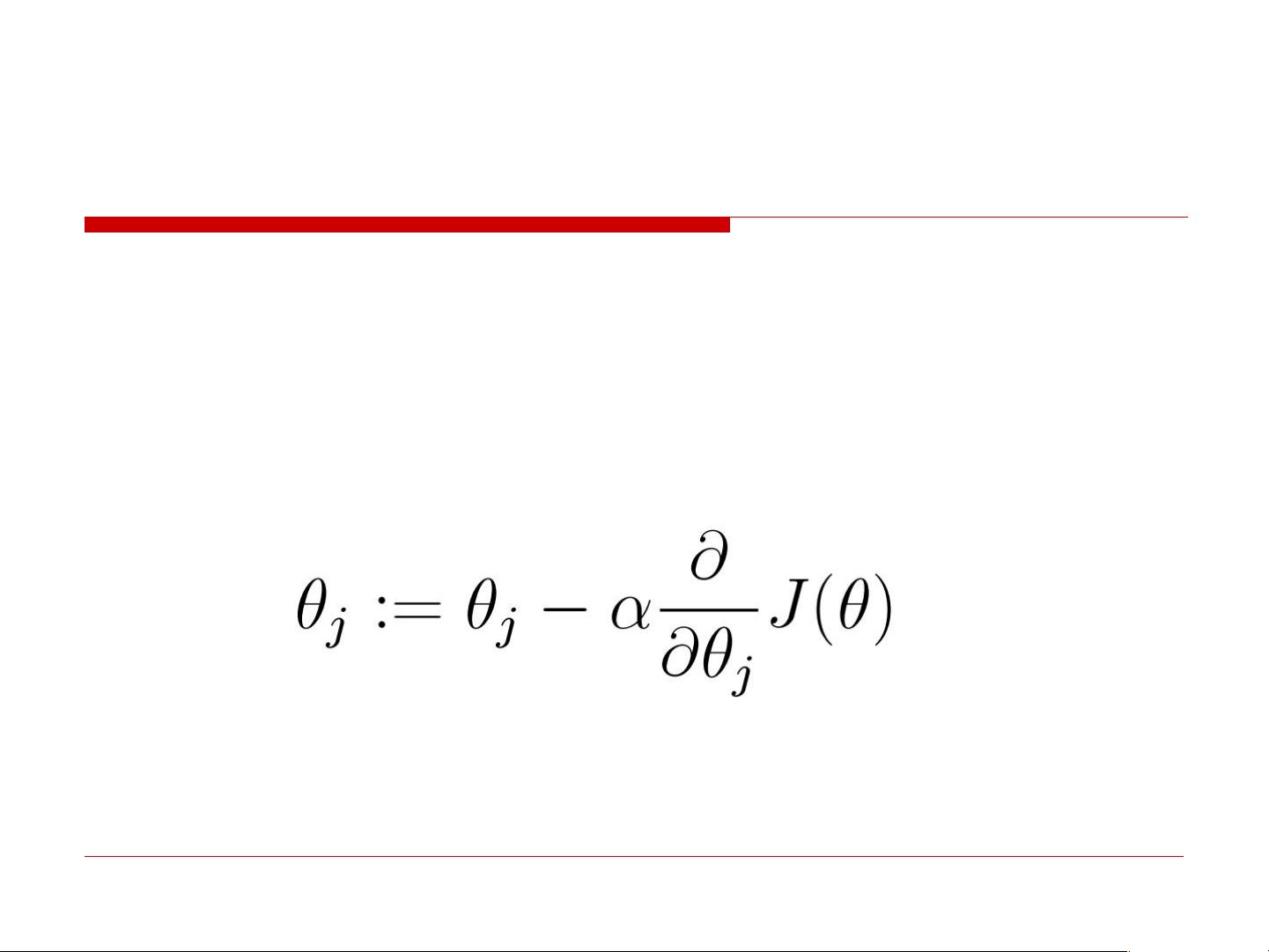

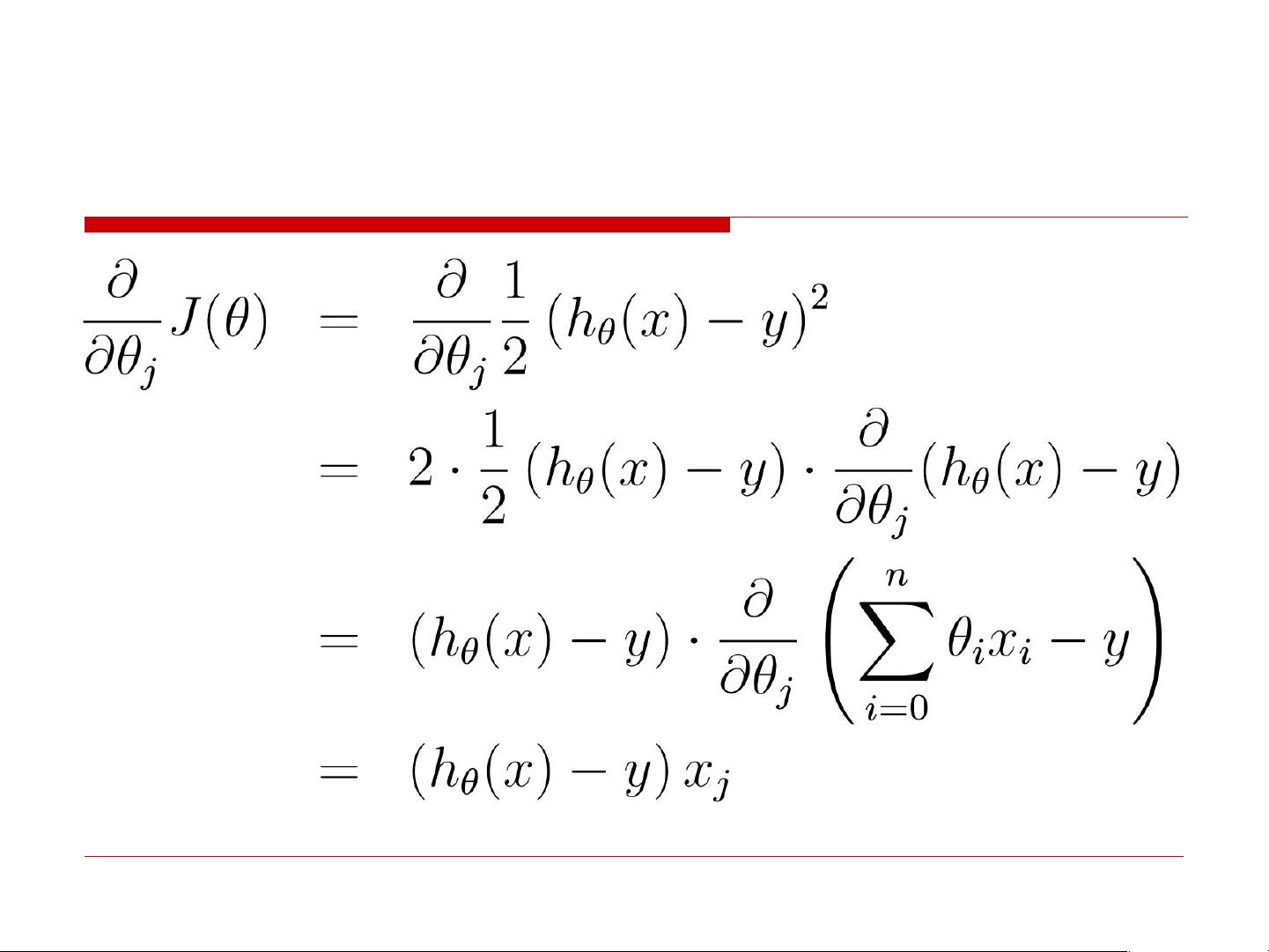

首先,线性回归部分介绍了简单的线性模型 y = ax + b,以及扩展到多个变量的情况。最小二乘法被提出作为目标函数,它是基于假设噪声服从高斯分布下的最大似然估计。接着,梯度下降算法作为优化工具被详细解释,包括其初始化、迭代过程和学习率的选择。对于不可逆的XTX矩阵,通过数值解的方式解决线性回归的参数求解问题。

线性回归的理解被扩展到非线性数据的处理,如局部加权线性回归(LWR),通过设置权重来适应非均匀的数据分布。权值的选择通常与带宽τ相关,这个参数决定了训练样本对预测的影响随距离的衰减速度。

然后,资源转向了逻辑回归,这是一种常用的分类方法,利用逻辑函数对输入进行非线性转换。讲解了逻辑函数的形式及其导数,以及在参数估计阶段如何基于对数似然函数进行迭代更新。逻辑回归的特点在于,尽管数据本身可能不是线性的,但通过参数学习实现分类决策。

在整个章节中,还穿插了最优化问题的求解方法,如批量梯度下降和随机梯度下降,以及在特定情况下使用解析式求解参数的方法。通过对比,参数学习算法(如线性回归)和非参数学习算法(如逻辑回归)在处理数据的不同侧重点得以明确。

这份资料深入浅出地介绍了回归与最优化的基本概念和实用技术,适合学习者系统理解和掌握机器学习中的这些核心内容。

134 浏览量

395 浏览量

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

lABSTUDY

- 粉丝: 0

- 资源: 4

最新资源

- jdk-11.0.6_windows-x64_bin.exe

- 接近客户的技巧——电话接近客户的技巧

- apsiyon-test-study

- i-sport:本学期的微信小程序期末设计,一种为喜爱运动健身人士所设计的APP

- goit-js-hw-07

- taskboard-ui

- Impellent.Developer.Tools:我自己的开发者工具的集合

- umodel_win32.zip

- 新人衔接教育30天销售实务培训班主任手册

- FORTE11.rar

- elex:对网关列表执行选举速度检查,以找到最快的网址

- win10打印机安装软件,一键配置ip打印

- pta_sim:PTA模拟代码存储库

- archive.cheesits456.dev:我网站的旧版本

- hello-world

- 客户服务与经营