Python爬虫:数据抓取、处理与数据库存储详解

需积分: 0 15 浏览量

更新于2024-09-06

收藏 179KB DOCX 举报

本教程是一份关于使用Python爬虫从证券接口抓取股票数据并将其存储到数据库的详细指南。教程分为三个主要步骤:编写爬虫下载数据、处理数据以及使用Python连接数据库存储数据。

1. 编写爬虫,下载数据

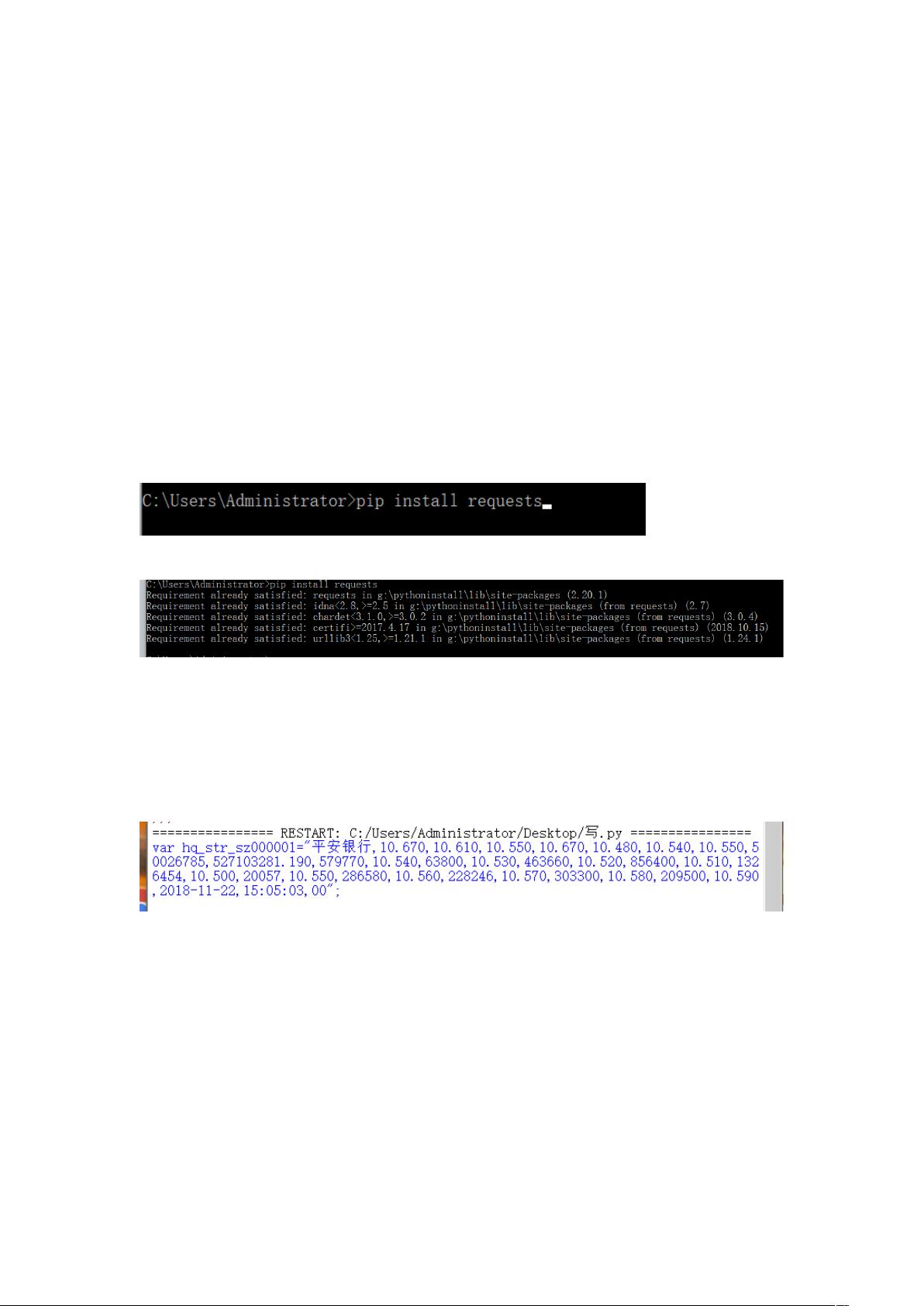

在这个阶段,首先需要导入Python的requests库,它是一个用于发送HTTP请求的工具。通过`pip install requests`命令安装并确保其可用。然后,编写一个简单的爬虫脚本,如下所示:

```python

import requests

url = 'http://hq.sinajs.cn/list=sz000001,sh000001'

response = requests.get(url)

stock_data = response.text

```

通过`requests.get(url)`,我们向指定的证券接口URL发送GET请求,获取返回的文本数据,即包含股票信息的JSON格式字符串。

2. 处理数据

原始数据是一个很长的字符串,需要解析成结构化的数据。这里使用的是字符串分割方法,将数据按照分号(;)切分成数组。然后对数组中的每个子字符串进行进一步处理,例如使用正则表达式(re库)提取出关键数据。马晓康同学的方法是遍历数组,找到双引号包围的数据块,再使用正则表达式进行分割:

```python

import re

pattern = re.compile(r'\"(.+?)\"') # 正则表达式模式

parsed_data = pattern.findall(stock_data)

# 或者个人的处理方式(未给出具体代码)

```

3. Python连接数据库并存储数据

处理后的数据可以存储到各种类型的数据库中,如MySQL、SQLite或PostgreSQL等。这里假设使用SQLite,首先需要安装sqlite3库(如果尚未安装):

```bash

pip install sqlite3

```

然后创建或连接到数据库,将数据插入表中:

```python

import sqlite3

# 连接到SQLite数据库

conn = sqlite3.connect('stock_data.db')

cursor = conn.cursor()

# 创建表(如果不存在)

cursor.execute('''CREATE TABLE IF NOT EXISTS stocks

(symbol text, price real, other_info text)''')

# 插入数据

for stock in parsed_data:

symbol, price, _ = stock # 假设price在第二个位置,第三个位置以后是其他信息

cursor.execute("INSERT INTO stocks VALUES (?, ?, ?)", (symbol, price, None)) # 如果有其他信息,替换为实际值

# 提交事务并关闭连接

conn.commit()

conn.close()

```

总结来说,这个教程介绍了如何使用Python爬虫技术从证券接口抓取股票数据,包括数据下载、处理(如正则表达式解析)以及存储到SQLite数据库的过程。根据个人需求,可以根据实际场景调整数据处理和数据库操作部分的细节。

2024-09-02 上传

2021-10-08 上传

2022-11-04 上传

2022-10-22 上传

2022-10-27 上传

2022-04-26 上传

2022-11-12 上传

2024-08-10 上传

qq_43229225

- 粉丝: 2

- 资源: 1

最新资源

- MATLAB实现小波阈值去噪:Visushrink硬软算法对比

- 易语言实现画板图像缩放功能教程

- 大模型推荐系统: 优化算法与模型压缩技术

- Stancy: 静态文件驱动的简单RESTful API与前端框架集成

- 掌握Java全文搜索:深入Apache Lucene开源系统

- 19计应19田超的Python7-1试题整理

- 易语言实现多线程网络时间同步源码解析

- 人工智能大模型学习与实践指南

- 掌握Markdown:从基础到高级技巧解析

- JS-PizzaStore: JS应用程序模拟披萨递送服务

- CAMV开源XML编辑器:编辑、验证、设计及架构工具集

- 医学免疫学情景化自动生成考题系统

- 易语言实现多语言界面编程教程

- MATLAB实现16种回归算法在数据挖掘中的应用

- ***内容构建指南:深入HTML与LaTeX

- Python实现维基百科“历史上的今天”数据抓取教程