HBase大数据查询实践:优化读写性能

PDF格式 | 496KB |

更新于2024-08-29

| 47 浏览量 | 举报

"大数据查询——HBase读写设计与实践"

在大数据处理领域,随着数据量的不断增长,传统的数据库系统往往难以应对高并发的写入和读取需求。本项目针对这一挑战,从Oracle数据库迁移至HBase,以解决check和opinion两张历史数据表的在线查询问题。HBase作为一种分布式、列族式的NoSQL数据库,非常适合存储大规模半结构化数据,并能提供高效的实时查询。

需求分析方面,check表的累计数据量超过5000万行,总计11GB,而opinion表的数据量更是达到了3亿行,约100GB。每天新增数据约50万行,且只做插入操作,不涉及更新。查询需求主要包括:基于check_id获取check表的多条记录列表,以及基于bussiness_no和buss_type查询opinion表并返回记录列表。查询响应时间要求在2秒内,日查询频率约为100笔。

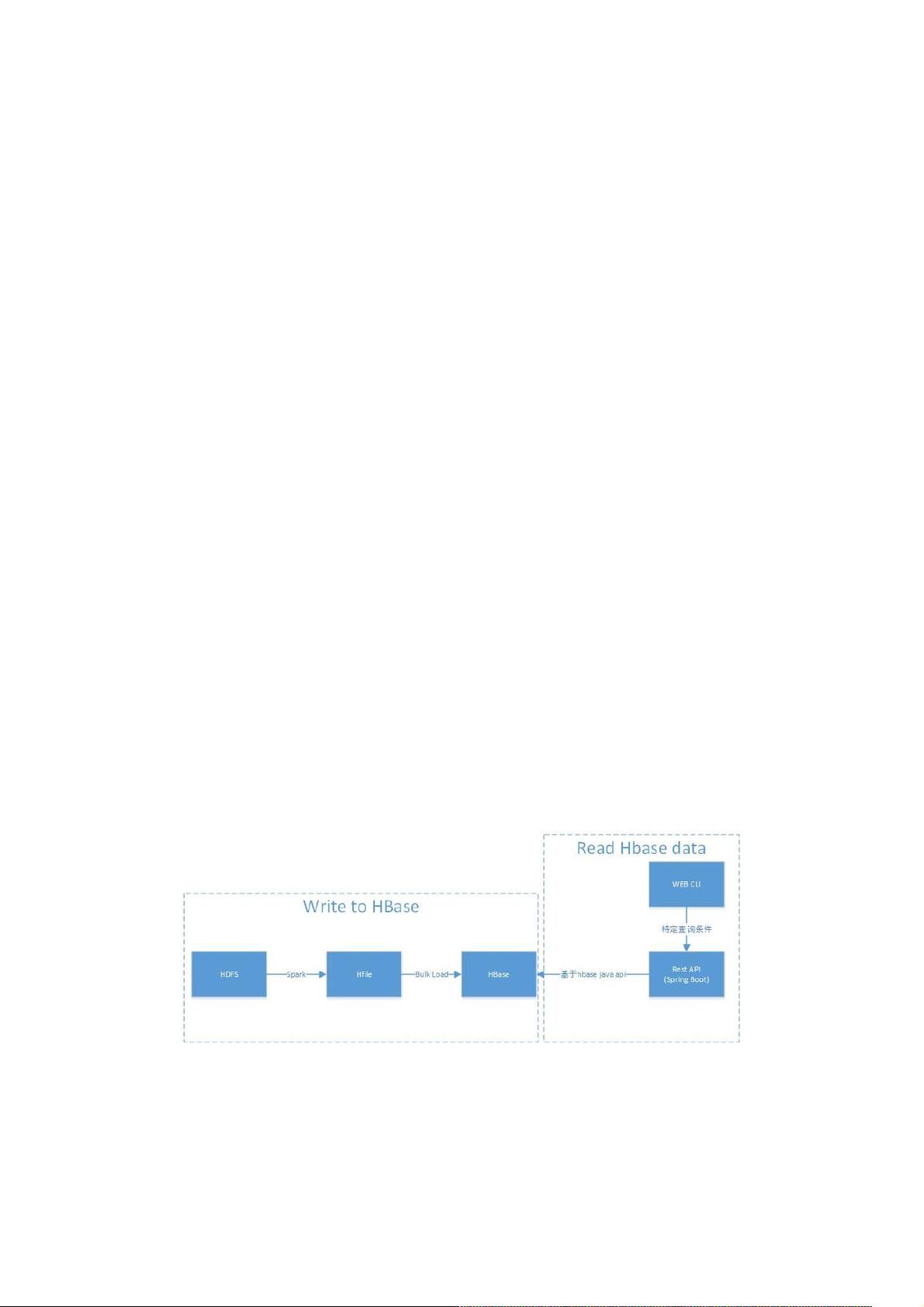

在技术选型上,HBase因其大数据存储能力和实时查询性能成为首选。在设计读取策略时,主要依赖于HBase的RowKey设计以及get和scan等API。RowKey的设计至关重要,因为它直接影响查询效率。对于写入策略,文章重点介绍了采用Spark+BulkLoad的方式,这种方式避免了写WAL(Write-Ahead Log)和数据flush及split,提高了写入效率。

BulkLoad的过程包括通过MapReduce或Spark生成HFile,然后将这些文件复制到HBase的HDFS目录下,最后通知RegionServer加载数据。Spark的并行处理能力使其在生成HFile时能有效提高效率,尤其适用于批量写入大数据量的场景。相比于直接使用Java API或MapReduce作业写入,BulkLoad显著降低了对RegionServer的压力,提升了系统的整体性能。

在实践中,优化RowKey设计可以进一步提升查询效率。例如,将最常用于查询的字段作为RowKey的一部分,可以减少数据扫描的范围。同时,合理的Region分裂策略也能保证负载均衡,防止热点现象出现。

本项目通过将历史数据存储从Oracle迁移到HBase,结合Spark的BulkLoad策略,成功解决了大数据量下的在线查询问题,实现了高性能、低延迟的系统改造。这为类似业务场景提供了有价值的参考,展示了大数据环境下如何有效利用NoSQL数据库进行数据处理和查询。

相关推荐

weixin_38642636

- 粉丝: 12

- 资源: 931