NVIDIA DGX-2服务器与NVSwitch:构建超大规模计算的新里程碑

需积分: 50 127 浏览量

更新于2024-07-18

收藏 1.39MB PDF 举报

"hotchip 2018 2.01"

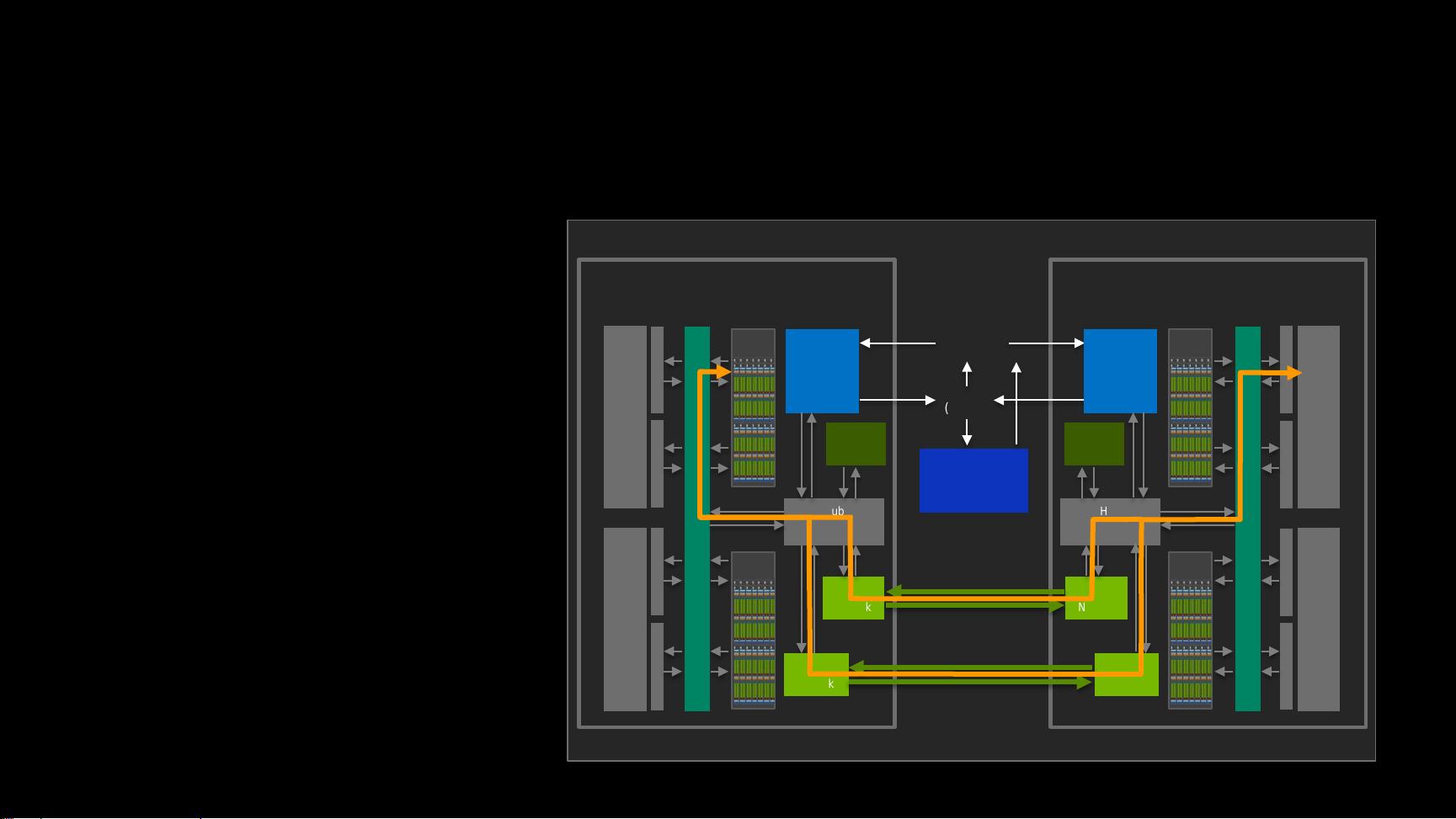

在2018年的Hot Chips技术研讨会上,NVIDIA公司介绍了他们的NVSwitch和DGX-2服务器,这是一个重大突破,展示了他们在高性能计算和数据中心领域的创新。NVSwitch是一款全新的高速互连芯片,而DGX-2则是基于这款芯片构建的先进计算服务器。

NVSwitch是NVIDIA推出的第二代NVLink技术,它提供了前所未有的带宽性能。每个端口速度高达25GBps,总双向带宽达到900GBps,总吞吐量为450GBps。这一创新设计构成了一个全带宽的胖树拓扑结构,使得12个NVSwitch网络能够实现2.4TBps的分割带宽。这种高带宽的特性使得在多GPU之间的数据传输变得极为高效,为大规模并行计算和深度学习应用提供了基础。

DGX-2服务器是基于这些技术构建的16个Tesla V100 32GB GPU的单服务器系统。这些GPU在浮点运算能力上表现出色,FP64运算能力达到125TFLOPS,FP32为250TFLOPS,而对于深度学习计算,Tensor核心可提供2000TFLOPS的运算能力。每个GPU拥有512GB的HBM2显存,服务器总内存容量达到1.5TB DDR4,存储容量为30TB NVMe,这为大规模数据处理提供了强大的硬件支持。

服务器设计还包括两颗24核的Intel Xeon CPU,为系统提供了强大的计算和调度能力。在信号完整性的设计上,NVIDIA也做了细致的工作,确保了在高频率、大带宽下的稳定运行。

DGX-2服务器的架构设计允许所有GPU共享全局内存,无需重复器,这意味着数据可以在GPU之间直接高速交换,减少了延迟,提高了整体计算效率。这种“一个巨大的GPU”概念通过NVSwitch实现了多GPU间的无缝协同工作,就如同它们是一个单一的、高性能的计算单元。

演讲提纲还涵盖了NVLink技术的回顾,NVSwitch的速度和性能,以及DGX-2服务器的设计、性能和封装。通过这些技术和系统的实现,NVIDIA成功地展示了如何在单个服务器中实现惊人的计算性能,这对于科学计算、机器学习和人工智能研究具有重大意义。

Hot Chip 2018中的NVSwitch和DGX-2服务器是NVIDIA对高带宽、低延迟计算解决方案的革新,推动了数据中心和AI计算的边界,为未来的技术发展奠定了坚实的基础。

312 浏览量

2023-04-29 上传

2018-08-30 上传

147 浏览量

217 浏览量

538 浏览量

cclacc

- 粉丝: 1

最新资源

- finquick:利用Web应用实现gnucash财务数据实时访问与同步

- 探索网络化技术的未来发展与应用

- Wireshark网络数据包分析与处理技巧全解

- GitHub文件编辑监控:通过Webhook及时获取通知

- 安卓图像处理:实现头像圆角剪裁与照片获取教程

- 点菜管理系统课程设计:数据库应用与程序开发

- MediBang Paint Pro v5.3 32位版本:专业漫画绘制与云同步

- 2019年数学建模竞赛题及翻译分享

- 合同内其它业务收入管理规定全面解析

- AITalker: 探索人工智能聊天助手的开源世界

- Minecraft Spigot插件配置:fkboard动态Web界面

- NumberDrive项目中的表达式解析器NumberDriveParser

- Biu-link:NodeJS实现的文本文件URL缩短器

- 探索Texas LED字体的设计与应用

- QuizizzHelper:简化在线Quizizz操作的JavaScript工具

- 安卓平台头像制作与圆角剪裁功能实现教程