深度学习课程CS231N:2019版李飞飞卷积神经网络讲义

需积分: 10 152 浏览量

更新于2024-07-15

收藏 5.91MB PDF 举报

"CS231N是斯坦福大学的一门深度学习课程,专注于卷积神经网络,由李飞飞、Justin Johnson和Serena Yeung等人讲授。这门课程提供了2019年的最新版课件,适合对深度学习,特别是图像识别感兴趣的学员。课程内容包括了Recurrent Neural Networks(循环神经网络)以及多种卷积神经网络架构,如GoogLeNet、AlexNet、ResNet和SENet等。此外,课程还涉及中期考试安排、项目提案反馈、项目里程碑截止日期以及作业发布与截止日期。"

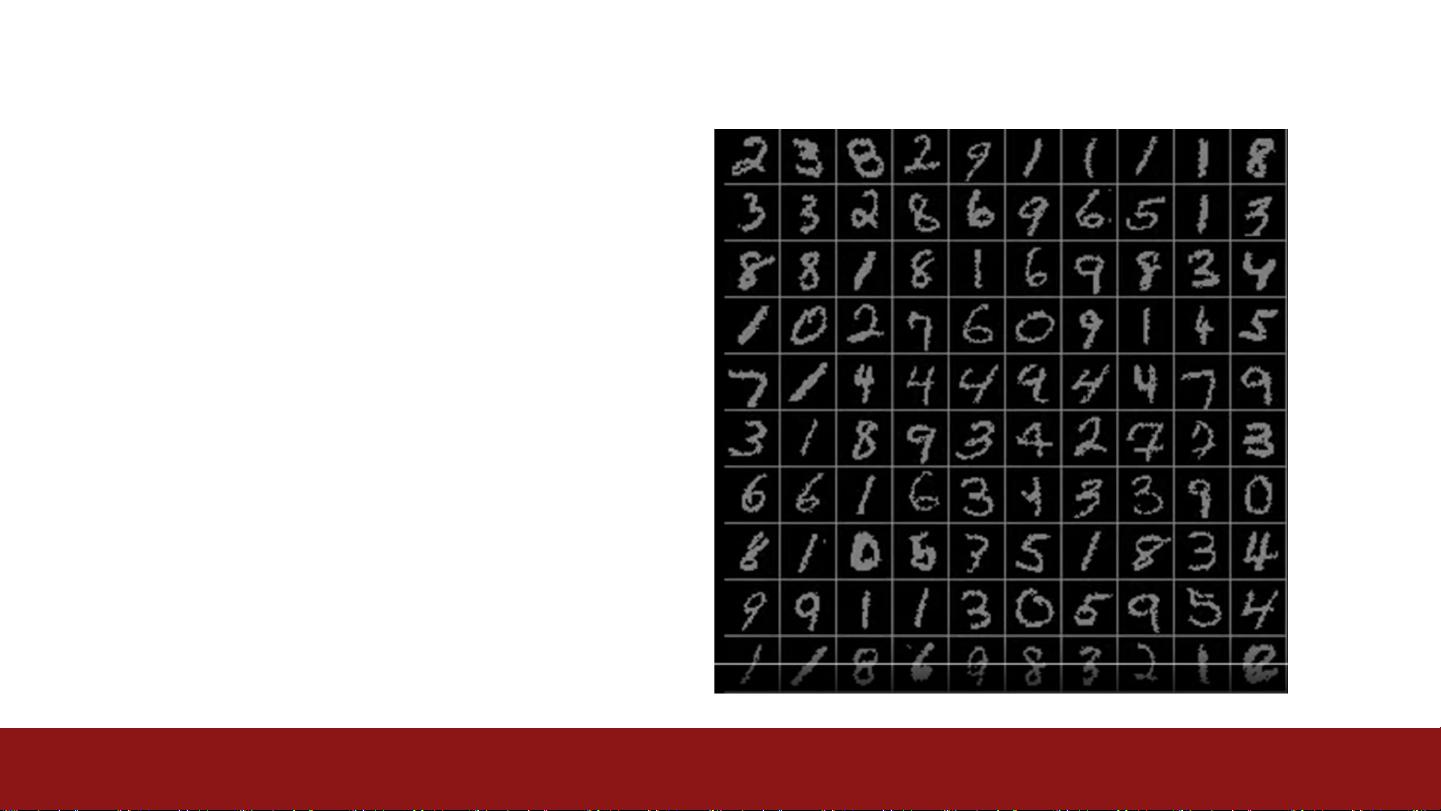

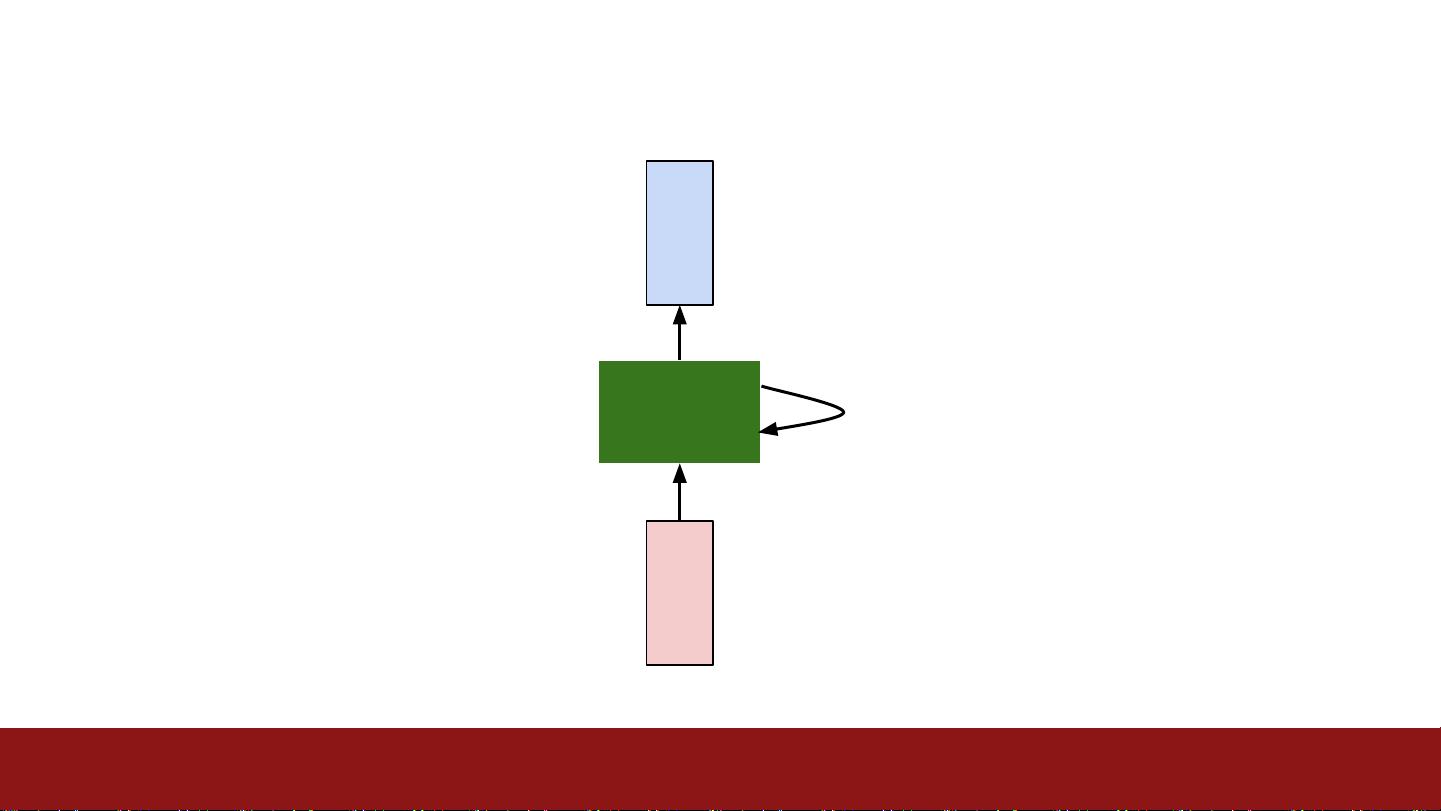

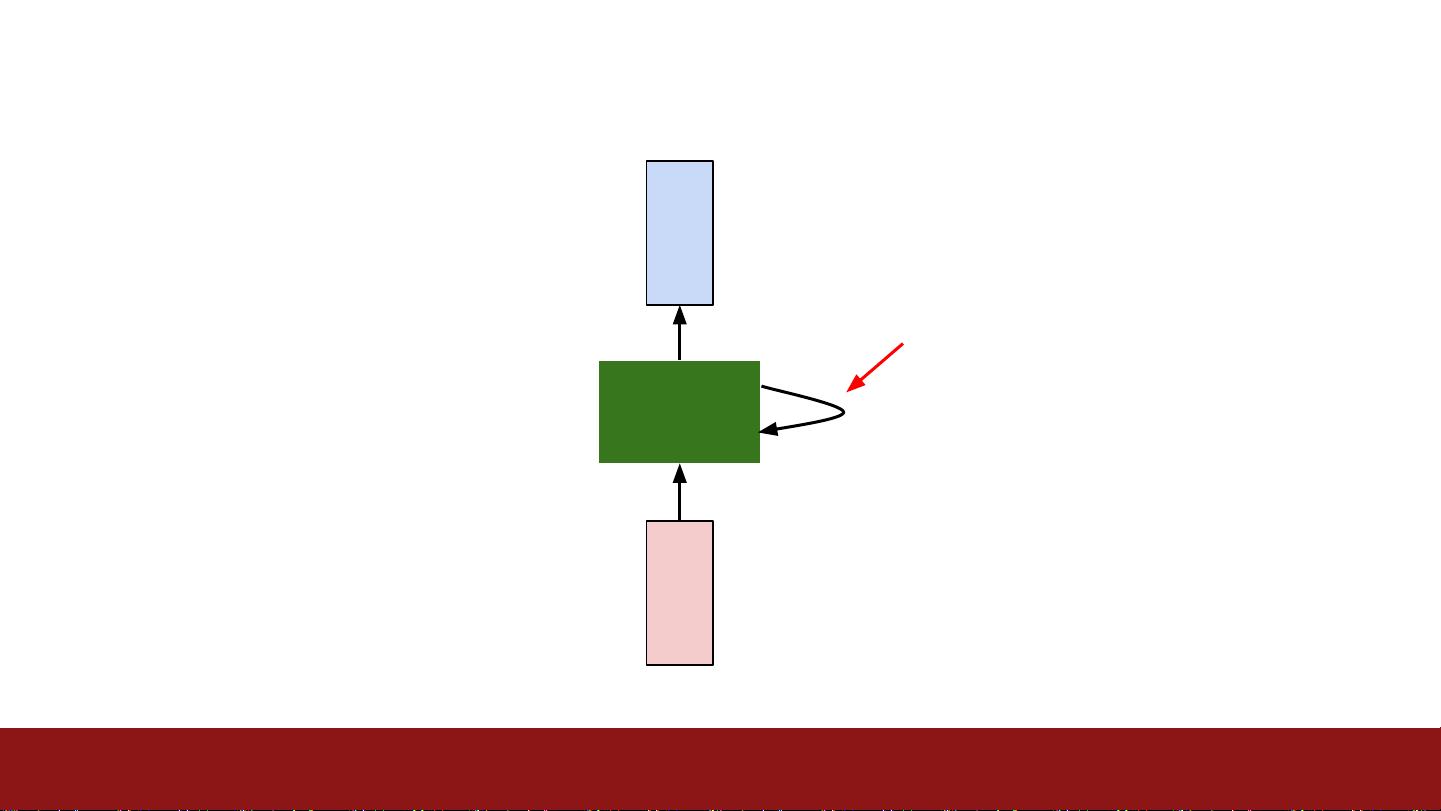

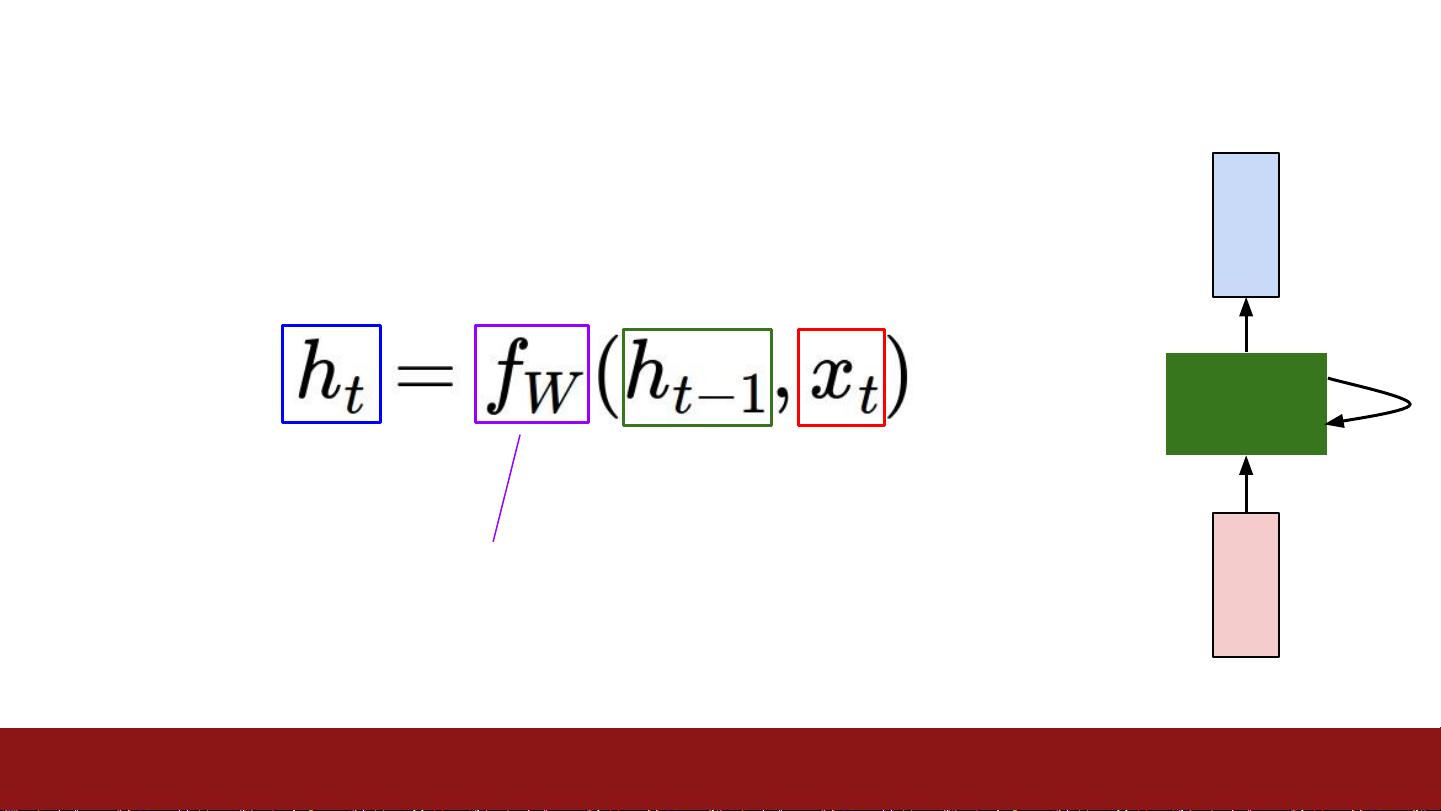

在这次的课件中,主要讲解了Recurrent Neural Networks(RNN),这是一种在处理序列数据,如自然语言、时间序列预测等问题时非常有效的神经网络模型。RNN的特点在于其内部的状态(或记忆)能够捕捉到输入序列的历史信息,使得模型能够考虑上下文关系。然而,标准的RNN在处理长序列时可能会遇到梯度消失或梯度爆炸的问题,这限制了它们的能力。

为了克服这些问题,出现了Long Short-Term Memory (LSTM) 和 Gated Recurrent Unit (GRU) 等变体。这些门控RNN结构通过添加控制信息流的门机制,有效地解决了长距离依赖问题。LSTM有输入门、遗忘门和输出门,允许选择性地记住或忘记信息,而GRU结合了这两种功能,简化了LSTM的结构,但仍然能有效地捕获长期依赖。

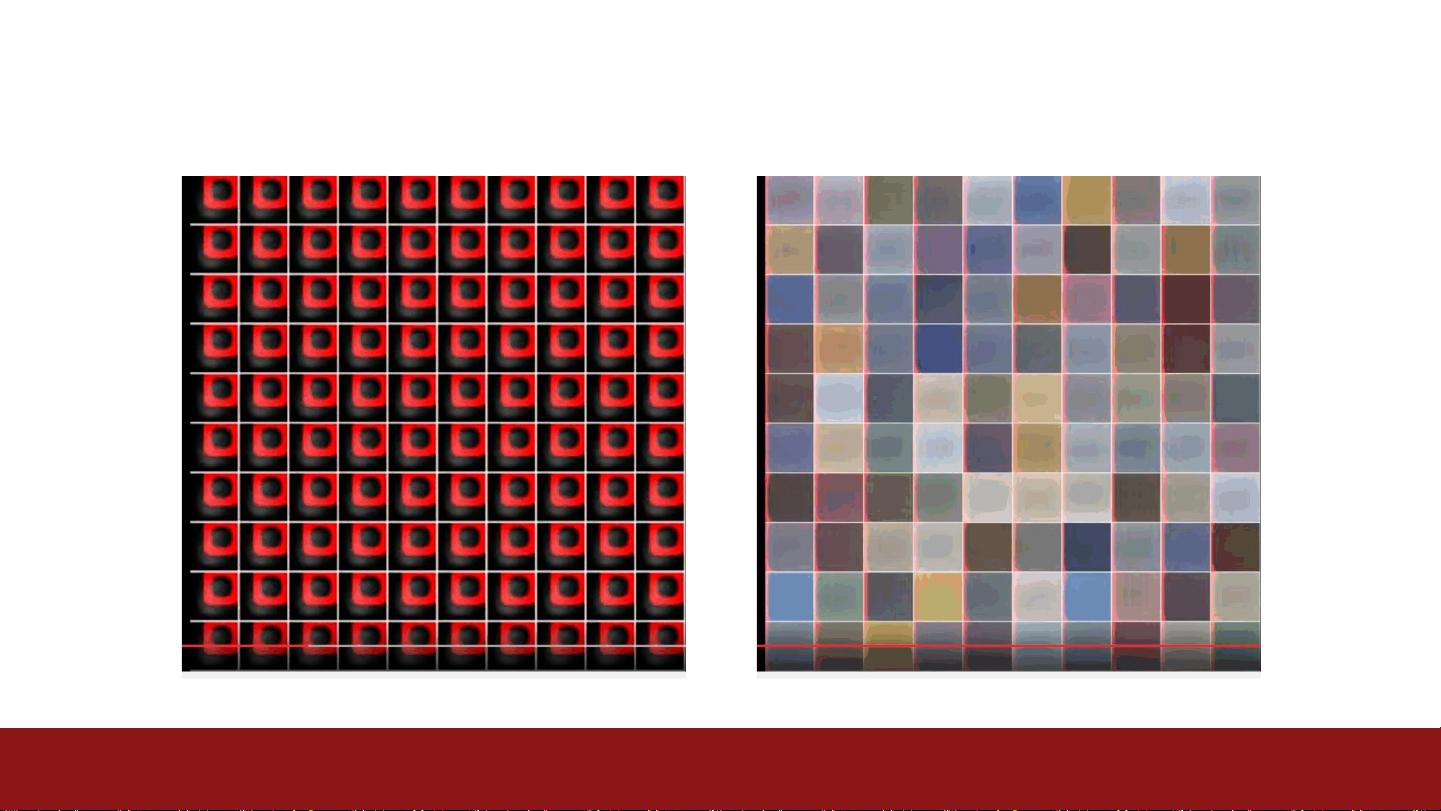

在之前的课件中,提到了几种著名的卷积神经网络(CNN)架构,如:

1. AlexNet:这是由Alex Krizhevsky等人在2012年的ImageNet竞赛中首次提出的,它标志着深度学习在计算机视觉领域的突破,包含多个卷积层、池化层和全连接层。

2. GoogLeNet(Inception Network):设计了更复杂的结构,使用了 inception 模块,允许在网络的不同深度并行处理不同大小的特征,提高了计算效率和性能。

3. ResNet:由Kaiming He等人提出,引入了残差块,通过“跳过连接”解决了深度网络中的梯度消失问题,使得构建更深的网络成为可能。

4. SENet(Squeeze-and-Excitation Networks):增加了注意力机制,能够自适应地调整不同通道的重要性,提高特征学习的效率和模型的准确性。

课程还提醒学生注意即将进行的中期考试,强调了不要去错误的考场,并提供了复习和练习的机会。此外,项目提案的反馈已经发布,项目里程碑需在5月15日之前完成,建议还未开始实施的学生尽快行动。作业A3将在5月8日发布,截止日期为5月22日。这些信息对于跟随课程进度和保持良好的学习习惯至关重要。

2020-10-27 上传

2020-10-27 上传

2020-10-27 上传

2020-10-27 上传

2020-10-27 上传

2020-10-27 上传

2020-10-27 上传

2020-10-27 上传

justkidding°

- 粉丝: 165

- 资源: 18

最新资源

- Raspberry Pi OpenCL驱动程序安装与QEMU仿真指南

- Apache RocketMQ Go客户端:全面支持与消息处理功能

- WStage平台:无线传感器网络阶段数据交互技术

- 基于Java SpringBoot和微信小程序的ssm智能仓储系统开发

- CorrectMe项目:自动更正与建议API的开发与应用

- IdeaBiz请求处理程序JAVA:自动化API调用与令牌管理

- 墨西哥面包店研讨会:介绍关键业绩指标(KPI)与评估标准

- 2014年Android音乐播放器源码学习分享

- CleverRecyclerView扩展库:滑动效果与特性增强

- 利用Python和SURF特征识别斑点猫图像

- Wurpr开源PHP MySQL包装器:安全易用且高效

- Scratch少儿编程:Kanon妹系闹钟音效素材包

- 食品分享社交应用的开发教程与功能介绍

- Cookies by lfj.io: 浏览数据智能管理与同步工具

- 掌握SSH框架与SpringMVC Hibernate集成教程

- C语言实现FFT算法及互相关性能优化指南