StableDiffusion算法详解:AI绘画背后的创新技术

需积分: 5 109 浏览量

更新于2024-06-19

1

收藏 8.37MB DOCX 举报

StableDiffusion是一种先进的AI绘画算法,它源自CompVis和Runway团队在2021年12月提出的潜在扩散模型(LDM/LatentDiffusionModel)。这种技术是建立在2015年扩散模型(DM/DiffusionModel)的基础之上,尤其注重稳定性与效率,使得生成的图像质量更高且控制更为精确。它的核心原理包括以下几个关键步骤:

1. 图像编码:首先,图像编码器将原始图像从像素空间(PixelSpace)转换到潜在空间(LatentSpace),这个过程通过神经网络压缩图像数据,提取出更深层次的特征,这些特征代表了图像的本质信息。

2. 扩散过程:在潜在空间中,算法会引入噪声,然后进行扩散过程,这是一个逐渐减少噪声的过程,目的是让模型逐渐揭示出原始图像的信息。

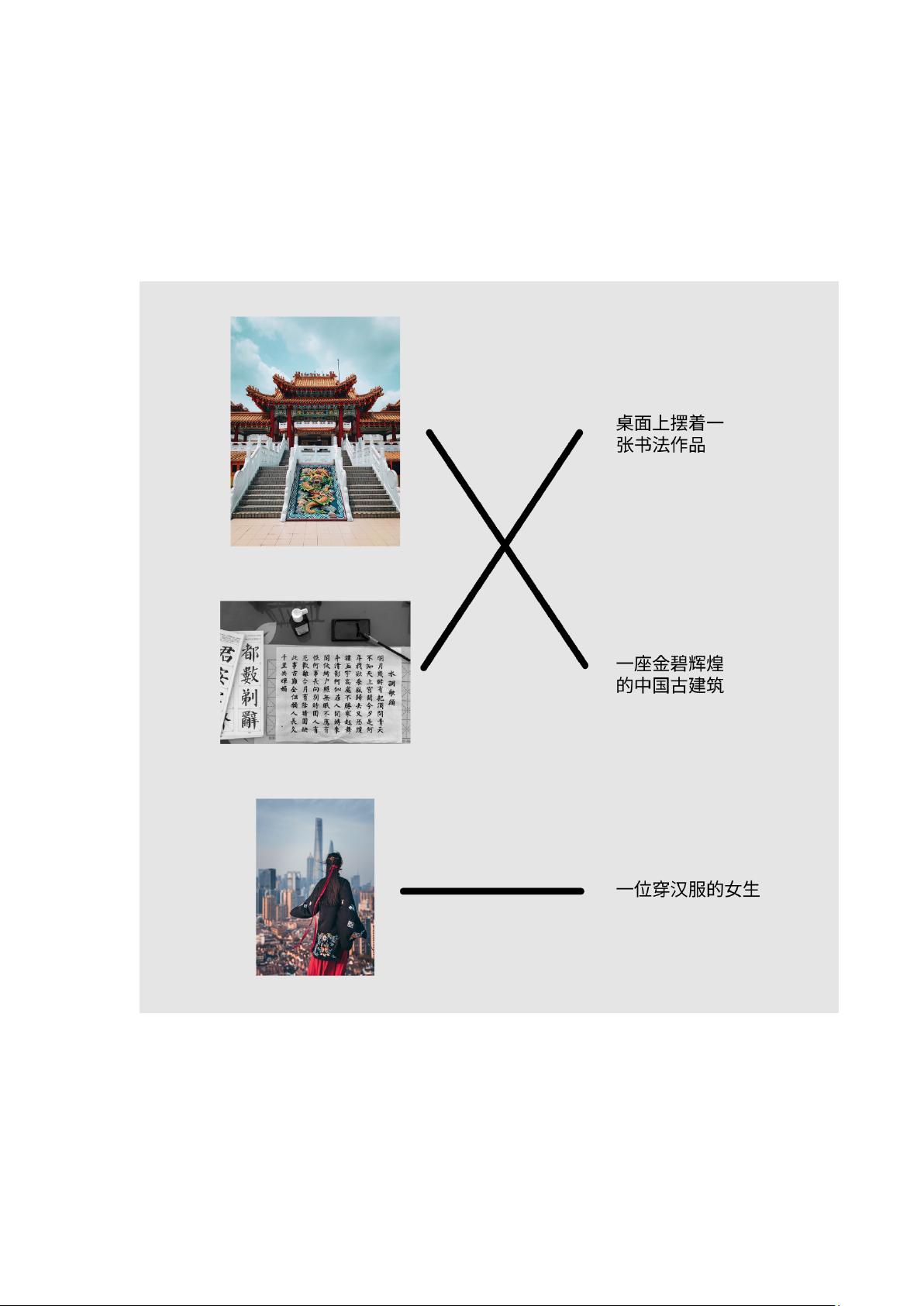

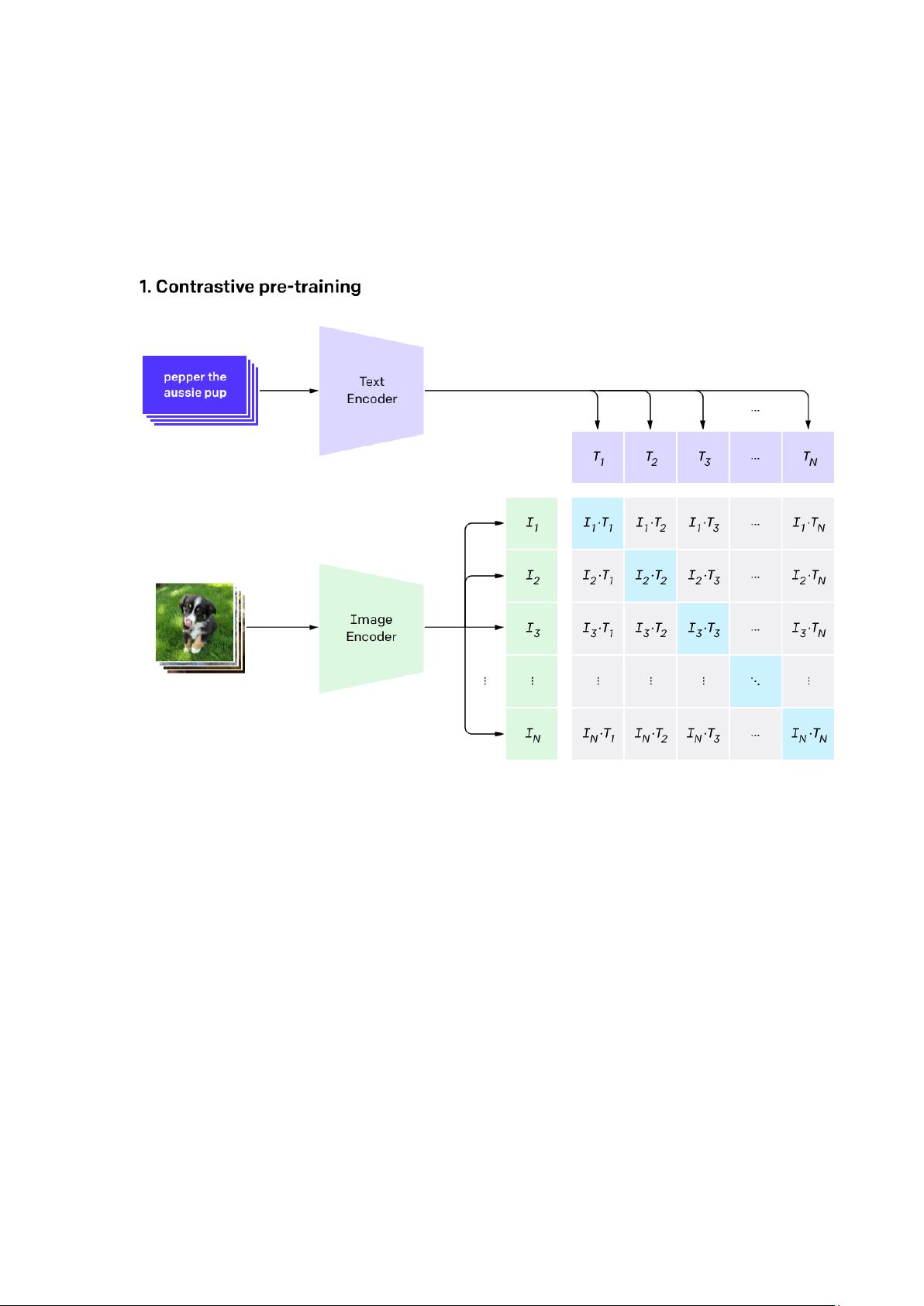

3. 条件输入:利用CLIP( Contrastive Language-Image Pretraining)文本编码器,用户可以提供文本描述作为条件,这将被转化为潜在空间中的去噪过程的指导。例如,如果用户输入“一只猫在花园里”,这个文本将被编码成一个向量,与潜在空间中的图像信息相结合。

4. 去噪与生成:基于这些条件,模型进行去噪操作,逐步恢复图像细节,生成最终的图像。这个过程是可调整的,可以灵活地接受文本、图像或其他形式的输入条件,从而实现多样化的生成效果。

StableDiffusion的优势在于它避免了传统AI绘画中可能出现的不稳定性问题,使得生成结果更加连贯且可控。由于算法设计强调易于理解和使用,即使对于非专业人士,如人工智能行业的学生、程序员、产品经理和从业者,也能通过这篇科普文章了解到基本的工作原理,无需过多的数学公式和复杂概念。虽然之前的文章已经概述了AI绘画的基本原理,但本文提供了更深入的StableDiffusion技术细节,有助于读者更好地掌握这一技术在实际应用中的操作和理解。因此,无论是为了学习、研究还是项目实践,StableDiffusion都是一个值得深入探索和掌握的重要领域。

2023-11-19 上传

2023-07-22 上传

2024-08-09 上传

2024-07-15 上传

2024-07-30 上传

2024-03-17 上传

2024-07-16 上传

2024-07-13 上传

TechLeadKrisChang

- 粉丝: 4w+

- 资源: 246

最新资源

- Chrome ESLint扩展:实时运行ESLint于网页脚本

- 基于 Webhook 的 redux 预处理器实现教程

- 探索国际CMS内容管理系统v1.1的新功能与应用

- 在Heroku上快速部署Directus平台的指南

- Folks Who Code官网:打造安全友好的开源环境

- React测试专用:上下文提供者组件实现指南

- RabbitMQ利用eLevelDB后端实现高效消息索引

- JavaScript双向对象引用的极简实现教程

- Bazel 0.18.1版本发布,Windows平台构建工具优化

- electron-notification-desktop:电子应用桌面通知解决方案

- 天津理工操作系统实验报告:进程与存储器管理

- 掌握webpack动态热模块替换的实现技巧

- 恶意软件ep_kaput: Etherpad插件系统破坏者

- Java实现Opus音频解码器jopus库的应用与介绍

- QString库:C语言中的高效动态字符串处理

- 微信小程序图像识别与AI功能实现源码