Java从零开始构建网络爬虫指南

需积分: 11 60 浏览量

更新于2024-07-28

收藏 2.49MB PDF 举报

"该资源是一本关于网络爬虫的教程,特别针对Java语言编写,旨在指导读者从零开始构建自己的网络爬虫。本书首先介绍了网络爬虫的基本概念和作用,指出尽管已有大型搜索引擎抓取了大量信息,但个性化和特定需求的数据抓取仍有其价值。在第1章中,作者详细讲解了网络爬虫的工作原理,包括如何抓取网页,理解URL(统一资源定位符)以及处理HTTP状态码的重要性。通过学习,读者将能够运用Java语言实现抓取网页的功能,并了解如何查看和解析网页源代码。"

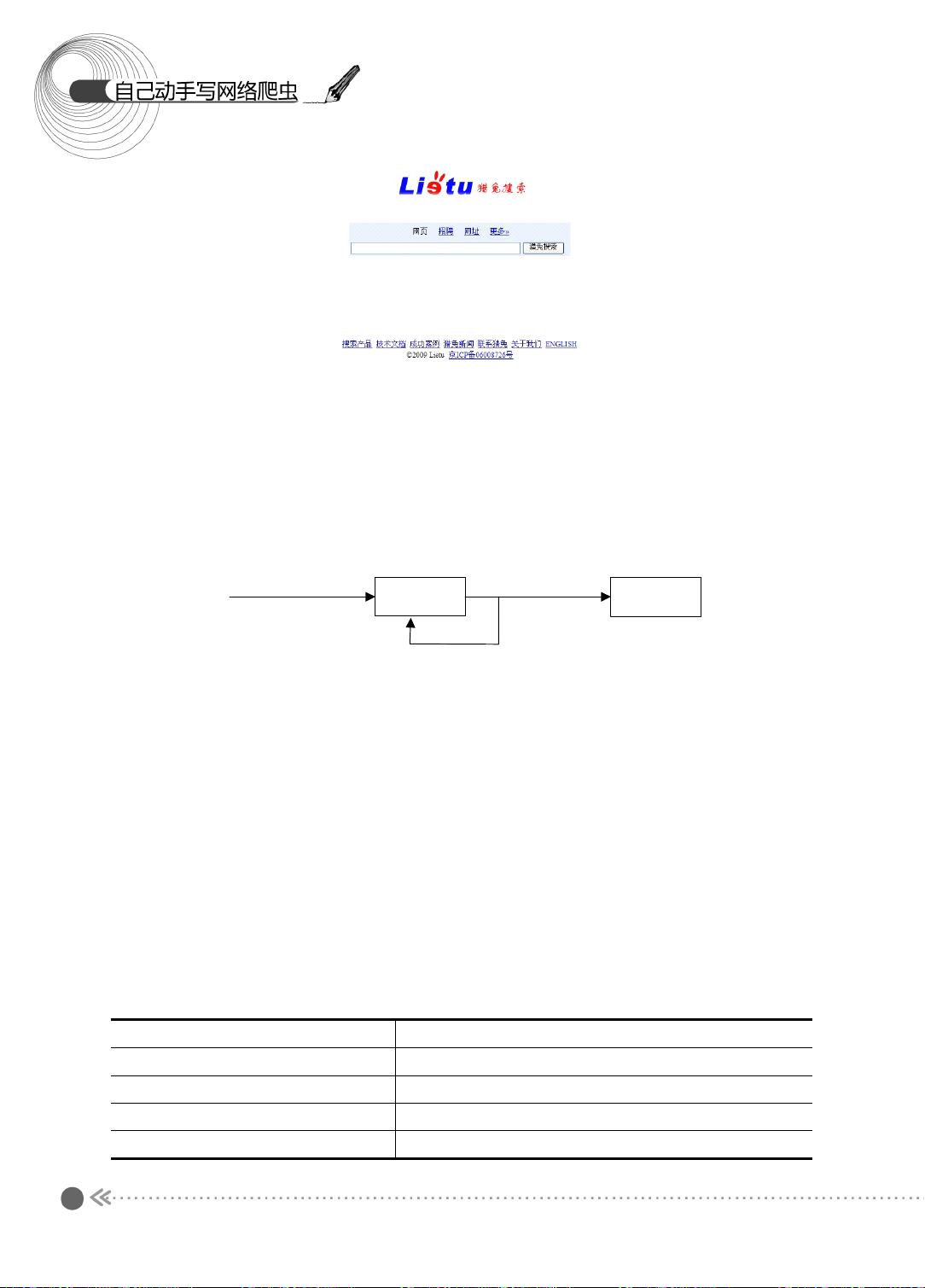

在深入学习网络爬虫的过程中,首先要理解的是URL,它是Uniform Resource Locator的缩写,用于唯一标识互联网上的资源。在浏览器中输入的URL,如http://www.lietu.com,包含了几部分信息:协议(这里是HTTP),域名(www.lietu.com),以及可能的路径和查询参数。而URI(Universal Resource Identifier)更为广泛,不仅包括URL,还涵盖了其他类型的资源标识方式。

网络爬虫的基础操作是模拟浏览器向服务器发送请求,获取响应的网页内容。这一过程中,掌握HTTP状态码的理解至关重要,因为它能告诉爬虫请求是否成功。例如,200状态码表示请求成功,而404则表示资源未找到。通过处理不同的HTTP状态码,爬虫可以适当地处理错误或重试请求。

Java是一种常用的编程语言,用于实现网络爬虫。在示例中,读者将学习如何使用Java来构造HTTP请求,获取网页内容,并解析这些内容以提取所需信息。这通常涉及到使用HTTP库,如Apache HttpClient,以及HTML解析库,如Jsoup,来解析HTML文档,提取数据。

在后续章节中,可能会涵盖更多高级主题,如反爬虫策略的应对、数据存储、并发爬取以及爬虫架构的设计。这些知识对于创建一个高效且健壮的网络爬虫系统至关重要。通过逐步学习和实践,读者不仅可以掌握网络爬虫的基本技术,还能了解到如何处理实际应用中遇到的各种挑战。

201 浏览量

188 浏览量

244 浏览量

2025-01-05 上传

2025-01-05 上传

2025-01-05 上传

2025-01-05 上传

FinallKill

- 粉丝: 0

- 资源: 10