深度学习详解:卷积神经网络原理与应用

卷积神经网络(CNN)是深度学习领域中的一种重要模型,特别适用于图像识别和处理任务。其核心在于卷积层和池化层的设计,这些层能够有效地提取图像特征,并减少计算复杂性。

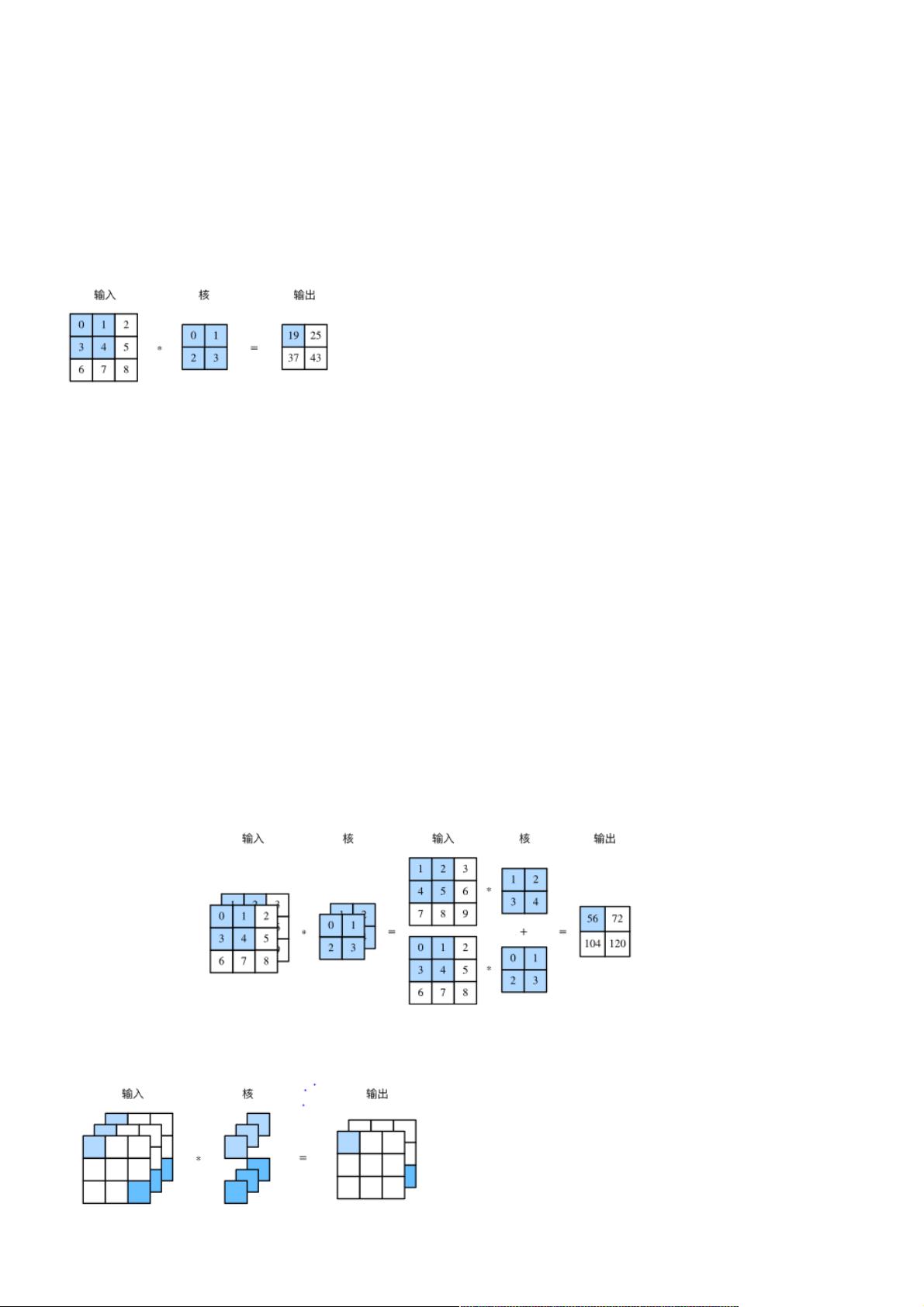

1. **卷积层**:卷积层是CNN的基础,通过应用多个卷积核(滤波器)对输入图像进行二维互相关运算,生成特征图。卷积运算实质上是对输入数据的局部区域进行加权求和,这些权重即为卷积核的参数。卷积层可以捕捉输入数据的空间结构,例如边缘、纹理等低级特征。此外,通过学习不同的卷积核,CNN可以自动发现更复杂的特征。

2. **填充(padding)**:在输入数据边缘添加零值,目的是保持输出特征图的尺寸与输入相似,或者控制输出的大小。填充有助于保持特征图的空间分辨率,避免信息丢失。

3. **步幅(stride)**:卷积核在输入数据上移动的步长,调整步幅可以改变输出特征图的大小。较大的步幅可以减少计算量,但可能导致特征捕捉的粒度变大;较小的步幅则能保留更多的细节信息。

4. **池化层**:用于减小特征图的尺寸,降低模型复杂性,同时保持重要的特征。常见的池化操作有最大池化(Max Pooling)和平均池化(Average Pooling),前者保留每个区域的最大值,后者取平均值。池化层有助于实现平移不变性,即对图像微小的位移不敏感。

5. **LeNet**:LeNet是最早成功的卷积神经网络之一,由Yann LeCun等人提出,主要用于手写数字识别。它包含卷积层、池化层和全连接层,展示了卷积神经网络在图像识别上的潜力。

6. **AlexNet**:由Alex Krizhevsky等人在2012年提出,首次在ImageNet大规模分类比赛中取得显著优势。AlexNet引入了ReLU激活函数,减少了梯度消失问题,同时采用了GPU并行计算,大大加速了训练速度。

7. **VGG**:由牛津大学视觉几何组提出的VGGNet,因其深度深、卷积核小(3x3)而著名。VGG验证了增加网络深度可以提高模型性能,但也导致了大量的参数,需要大量数据和计算资源。

8. **NiN**(Network in Network):由林嘉洋等人提出的架构,引入了微网络(Mini-Net)的概念,用多层感知机(MLP)替换传统的卷积层,增强了特征学习能力。

9. **GoogLeNet(Inception Network)**:谷歌团队设计的网络,以其Inception模块著称,该模块通过并行不同大小的卷积核和池化操作,同时捕获不同尺度的特征,有效减少了计算量,提高了模型效率。

这些模型的不断进步推动了深度学习在图像识别、物体检测、语义分割等多个领域的广泛应用。卷积神经网络不仅限于图像处理,也成功应用于语音识别、自然语言处理等领域,成为了现代深度学习技术的基石。

989 浏览量

点击了解资源详情

点击了解资源详情

275 浏览量

605 浏览量

1800 浏览量

104 浏览量

697 浏览量

207 浏览量

weixin_38660918

- 粉丝: 9

- 资源: 926

最新资源

- rsa-src.zip

- 煤矿采煤机自动化与智能化技术研究.rar

- Highlight to Google Calendar-crx插件

- 博通网卡管理软件(Management Applications) v17.0.5.1 官方版

- peep-object:检查对象的所有组件

- NetThief81_8582.7z

- 大亨游戏

- Enegy-Generation-Company-SunSolar-ForntEnd-

- Rapid BSR-crx插件

- autocert:Python Web应用程序的自动TLS证书发行和续签

- 网上书店模板(有demo设计文档和界面源码,界面很帅哟,)

- TinyLinqJs:Linq-to-Objects 的 JavaScript 实现,以便将其与标准 JavaScript 数组一起使用

- arya.adslab

- Zet-crx插件

- 人脸检测编程实验工具.rar

- 腾达W522U无线USB网卡驱动