Hadoop源代码深度解析:关键组件与依赖揭秘

需积分: 41 44 浏览量

更新于2024-07-24

收藏 5.99MB PDF 举报

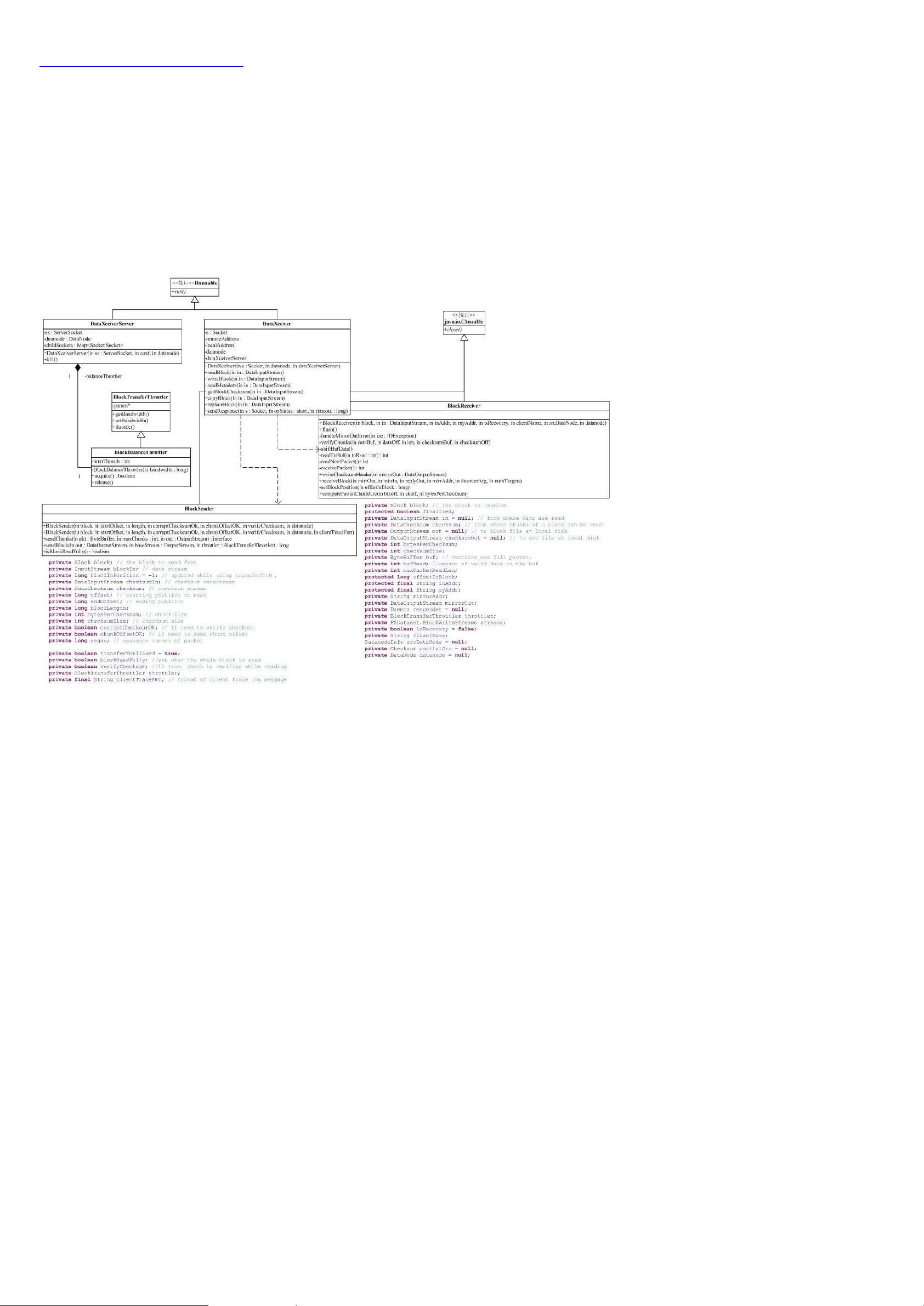

Hadoop源代码分析是一系列深入研究Apache Hadoop框架的教程,旨在帮助读者理解这个广泛应用的分布式计算平台。Hadoop起源于Google的几个核心项目,包括Google Cluster、Chubby、GFS、BigTable和MapReduce,它们分别对应着Hadoop中的ZooKeeper、HDFS、HBase和MapReduce组件。Hadoop的成功在于其分布式文件系统HDFS,它是其他组件如MapReduce的基础,使得数据可以在大规模集群上高效地进行处理。

Hadoop的架构包含复杂的包间依赖关系,这源于其设计的灵活性,它允许开发人员编写代码,以透明地使用各种存储选项,包括本地文件系统、分布式文件系统以及像Amazon S3这样的云存储服务。这种设计使得HDFS的实现与其他模块如配置管理紧密相连,形成了一个蜘蛛网式的依赖结构。

分析的重点集中在Hadoop的核心部分,即图中蓝色区域,主要包括以下几个方面:

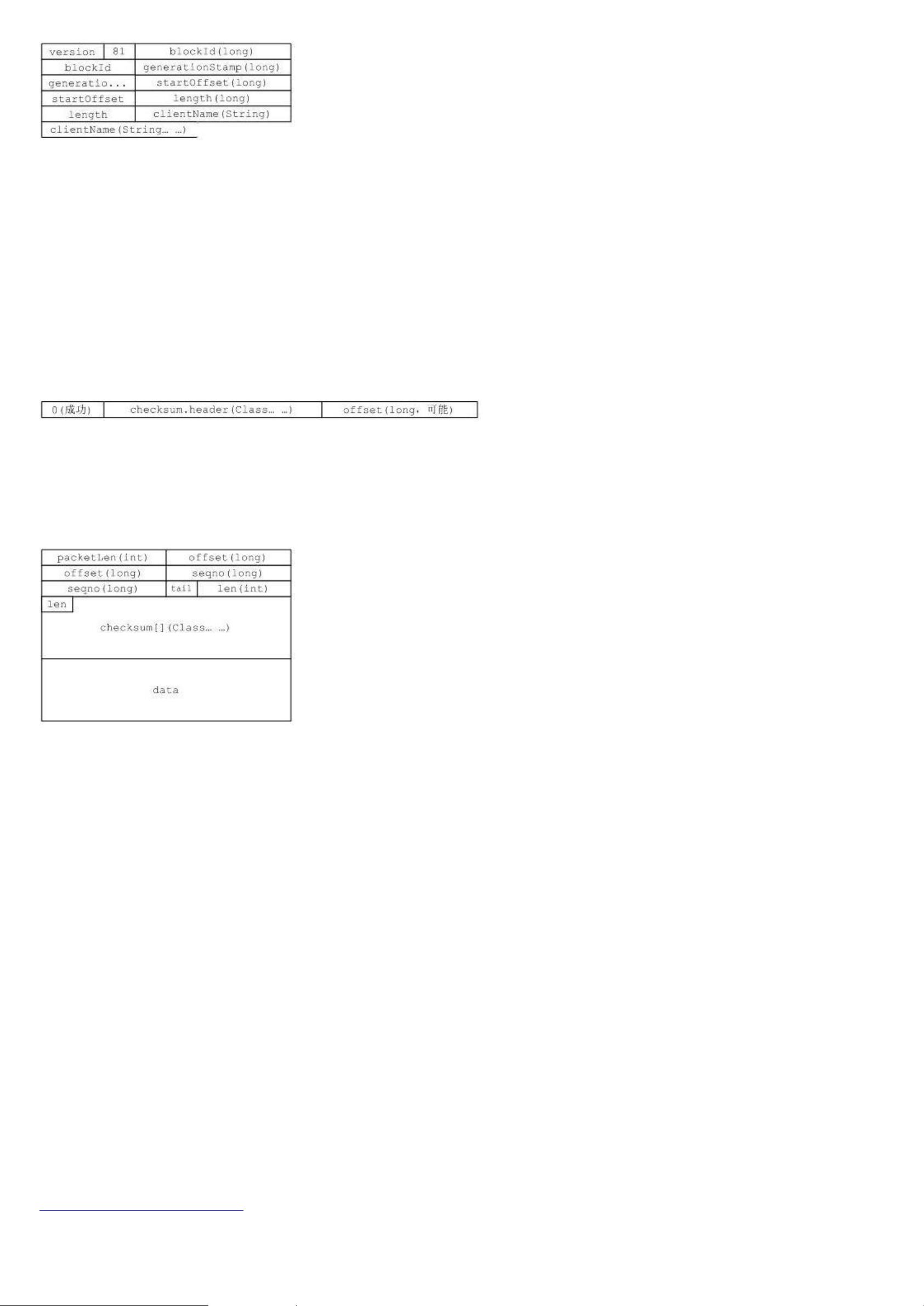

1. **HDFS (Hadoop Distributed File System)**: 分布式文件系统,提供了高可用性和容错性的存储,允许大量数据在集群中分布式存储。HDFS的设计是Hadoop的核心组件,它负责数据块的存储、复制和分发。

2. **MapReduce**: 这是Hadoop用于并行处理大数据集的编程模型,将复杂的计算任务分解成一系列小任务(Map)和后续的汇总操作(Reduce),非常适合处理批量、非实时的数据处理。

3. **ZooKeeper**: 虽然源自Chubby,但在Hadoop中作为协调服务,用于管理分布式环境中的元数据和配置,确保数据一致性。

4. **HBase**: 基于BigTable的分布式列式数据库,它与HDFS一起提供了一个强大的数据存储和查询能力,适合于处理海量数据的实时查询。

5. **工具包** (Tool): 包含一些实用的命令行工具,如DistCp用于数据复制,archive工具用于归档等,这些工具支持Hadoop生态系统的日常管理和维护。

通过对Hadoop源代码的分析,开发者可以深入了解分布式计算的工作原理,学习如何设计和优化大规模数据处理应用,以及如何利用Hadoop生态系统提供的工具进行项目管理和数据处理。通过逐个模块的深入剖析,不仅能够提升技术水平,还能够为解决实际问题提供坚实的理论基础。

2022-03-12 上传

2013-01-13 上传

2014-12-01 上传

2014-07-20 上传

2012-04-17 上传

lizzy05

- 粉丝: 77

- 资源: 21

最新资源

- IEEE 14总线系统Simulink模型开发指南与案例研究

- STLinkV2.J16.S4固件更新与应用指南

- Java并发处理的实用示例分析

- Linux下简化部署与日志查看的Shell脚本工具

- Maven增量编译技术详解及应用示例

- MyEclipse 2021.5.24a最新版本发布

- Indore探索前端代码库使用指南与开发环境搭建

- 电子技术基础数字部分PPT课件第六版康华光

- MySQL 8.0.25版本可视化安装包详细介绍

- 易语言实现主流搜索引擎快速集成

- 使用asyncio-sse包装器实现服务器事件推送简易指南

- Java高级开发工程师面试要点总结

- R语言项目ClearningData-Proj1的数据处理

- VFP成本费用计算系统源码及论文全面解析

- Qt5与C++打造书籍管理系统教程

- React 应用入门:开发、测试及生产部署教程