"深入探讨神经网络优化:学习率策略、激活函数、损失函数、拟合问题与优化器选择"

需积分: 0 179 浏览量

更新于2024-01-03

收藏 2.33MB PDF 举报

TensorFlow是一个广泛应用于人工智能领域的深度学习框架,具有强大的神经网络优化功能。在使用TensorFlow进行神经网络优化时,我们需要考虑多个方面,包括神经网络复杂度、学习率策略、激活函数、损失函数、欠拟合与过拟合等。另外,TensorFlow还提供了多种优化器,可以根据具体情况选择合适的优化器来提升模型性能。

在神经网络中,复杂度是评估模型资源消耗的重要指标,包括时间复杂度和空间复杂度。时间复杂度指的是模型训练和推理所需要的时间,而空间复杂度指的是模型所需要的内存空间。因此,需要根据实际情况选择合适的模型复杂度。

学习率策略是指在训练过程中调整学习率的方法,常见的策略包括指数衰减和分段常数衰减。指数衰减是通过指数函数来降低学习率,可以在训练初期得到较大的学习率,有利于快速收敛;而分段常数衰减是在训练的不同阶段使用不同的学习率,可以更好地适应不同的训练阶段。

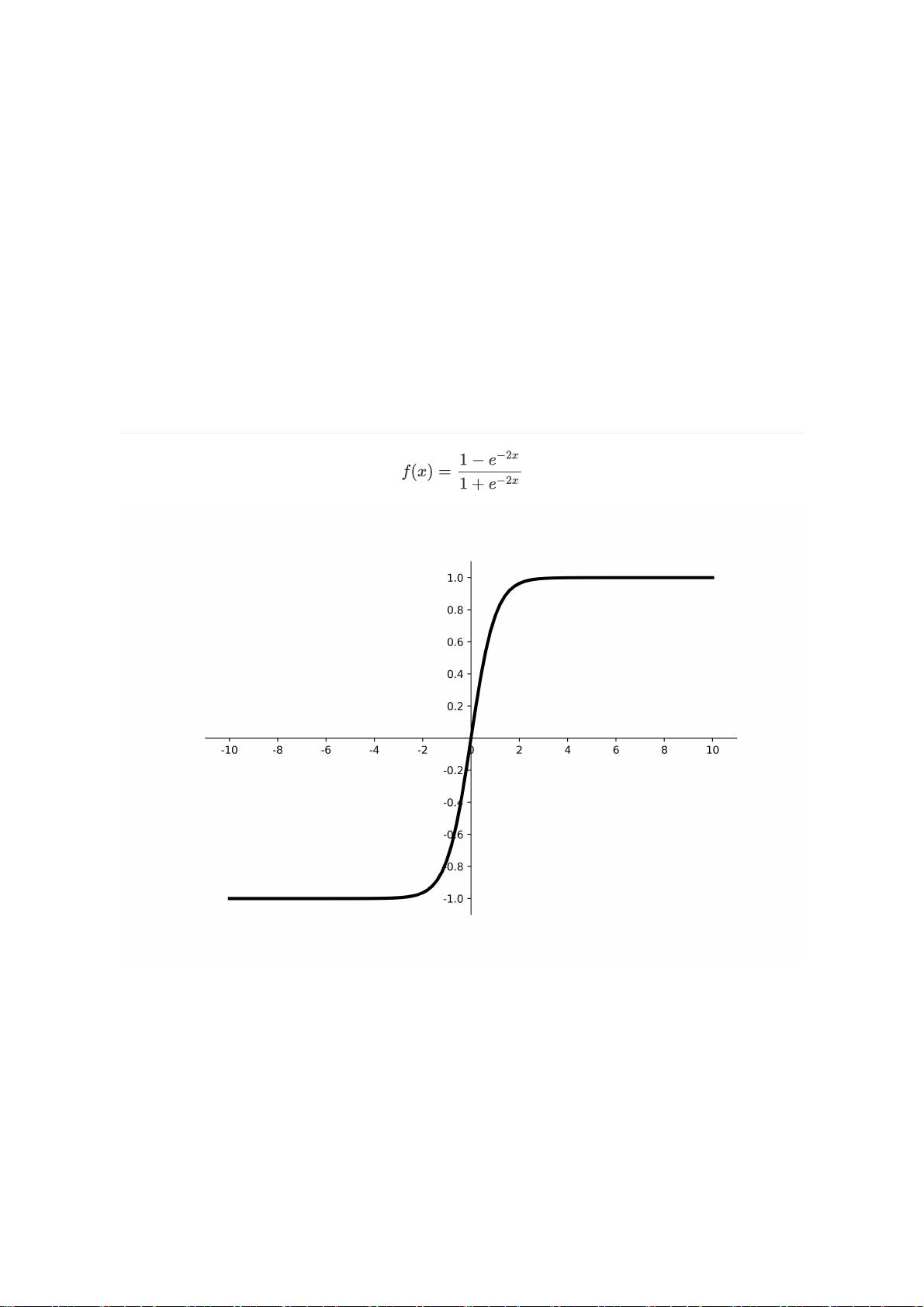

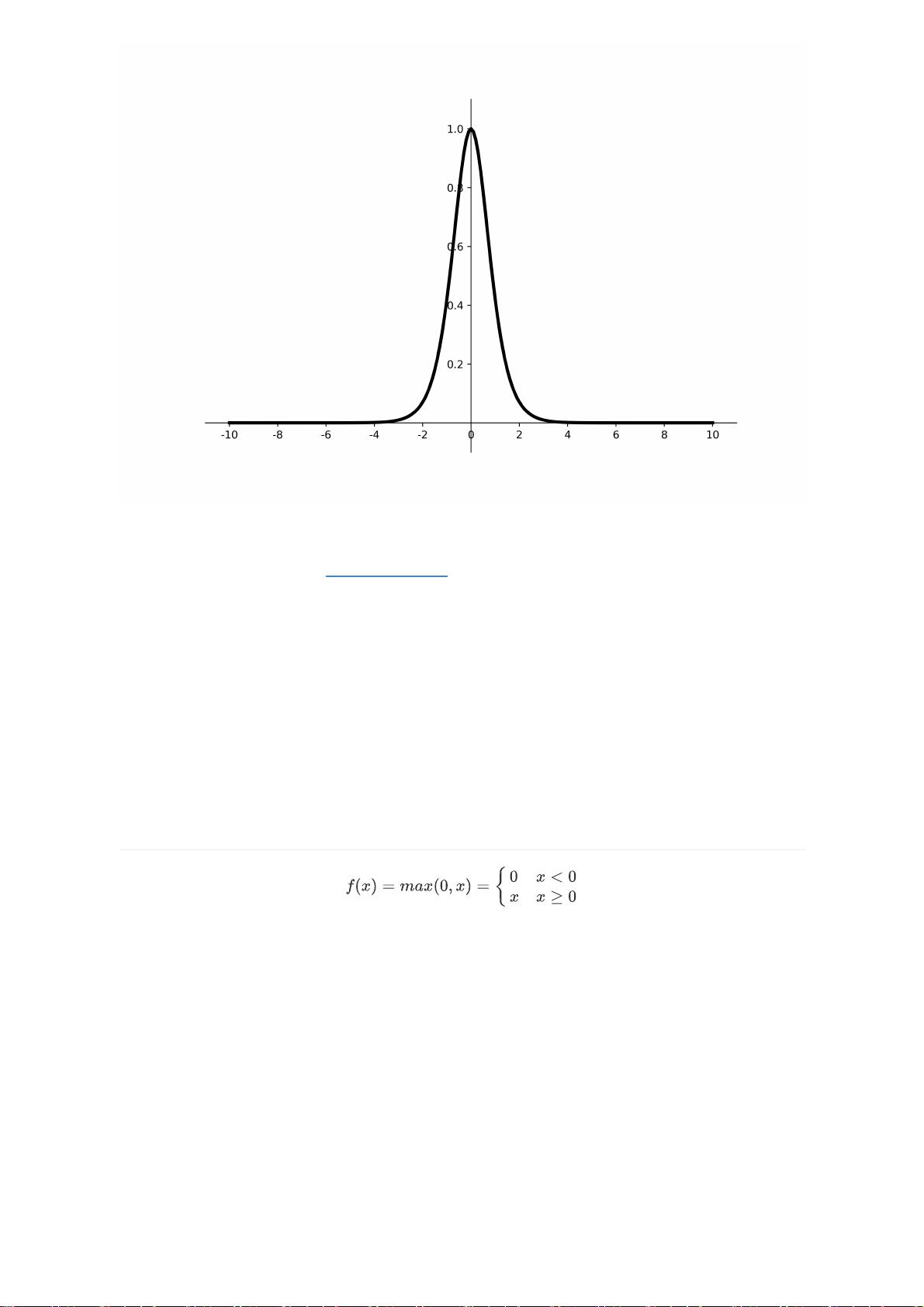

激活函数是神经网络中常用的非线性函数,它能够引入非线性特性并增强模型的表达能力。常见的激活函数包括sigmoid、tanh、ReLU、Leaky ReLU和softmax等,每种激活函数都有其独特的性质和适用场景。

损失函数是用来衡量模型输出与真实值之间的差异的函数,常见的损失函数包括均方误差损失函数和交叉熵损失函数。均方误差损失函数适用于回归任务,而交叉熵损失函数适用于分类任务。此外,TensorFlow还支持自定义损失函数,可以根据具体需求定义自己的损失函数。

欠拟合和过拟合是神经网络优化中常遇到的问题。欠拟合指模型无法很好地拟合训练数据,而过拟合指模型过于复杂,对训练数据过拟合。为了解决这些问题,可以采用数据增强、正则化以及早停等方法来减少过拟合,同时也可以增加模型复杂度来减少欠拟合。

优化器是用来更新模型参数以最小化损失函数的算法。TensorFlow提供了多种优化器,包括SGD、AdaGrad、RMSProp、AdaDelta和Adam等。这些优化器在更新参数时都考虑了梯度信息,并且根据具体算法进行参数更新。根据实际情况,可以选择合适的优化器来提升模型性能。

在选择优化器时,需要考虑多个因素,包括模型复杂度、学习率策略、激活函数和损失函数等。此外,还可以使用一些常用的tricks来优化算法,如权重初始化、批归一化和学习率衰减等。

总结起来,TensorFlow提供了强大的神经网络优化功能,包括神经网络复杂度评估、学习率策略、激活函数、损失函数、欠拟合与过拟合以及多种优化器的选择等。通过灵活使用这些功能,我们可以提升模型性能,实现更好的人工智能应用。

2020-09-20 上传

2022-03-23 上传

点击了解资源详情

点击了解资源详情

点击了解资源详情

2021-01-27 上传

2018-07-18 上传

liutangplease

- 粉丝: 1212

- 资源: 44

最新资源

- MATLAB实现小波阈值去噪:Visushrink硬软算法对比

- 易语言实现画板图像缩放功能教程

- 大模型推荐系统: 优化算法与模型压缩技术

- Stancy: 静态文件驱动的简单RESTful API与前端框架集成

- 掌握Java全文搜索:深入Apache Lucene开源系统

- 19计应19田超的Python7-1试题整理

- 易语言实现多线程网络时间同步源码解析

- 人工智能大模型学习与实践指南

- 掌握Markdown:从基础到高级技巧解析

- JS-PizzaStore: JS应用程序模拟披萨递送服务

- CAMV开源XML编辑器:编辑、验证、设计及架构工具集

- 医学免疫学情景化自动生成考题系统

- 易语言实现多语言界面编程教程

- MATLAB实现16种回归算法在数据挖掘中的应用

- ***内容构建指南:深入HTML与LaTeX

- Python实现维基百科“历史上的今天”数据抓取教程