Spark任务设计:构建数仓维度表与流量分析

需积分: 0 19 浏览量

更新于2024-08-04

收藏 290KB DOCX 举报

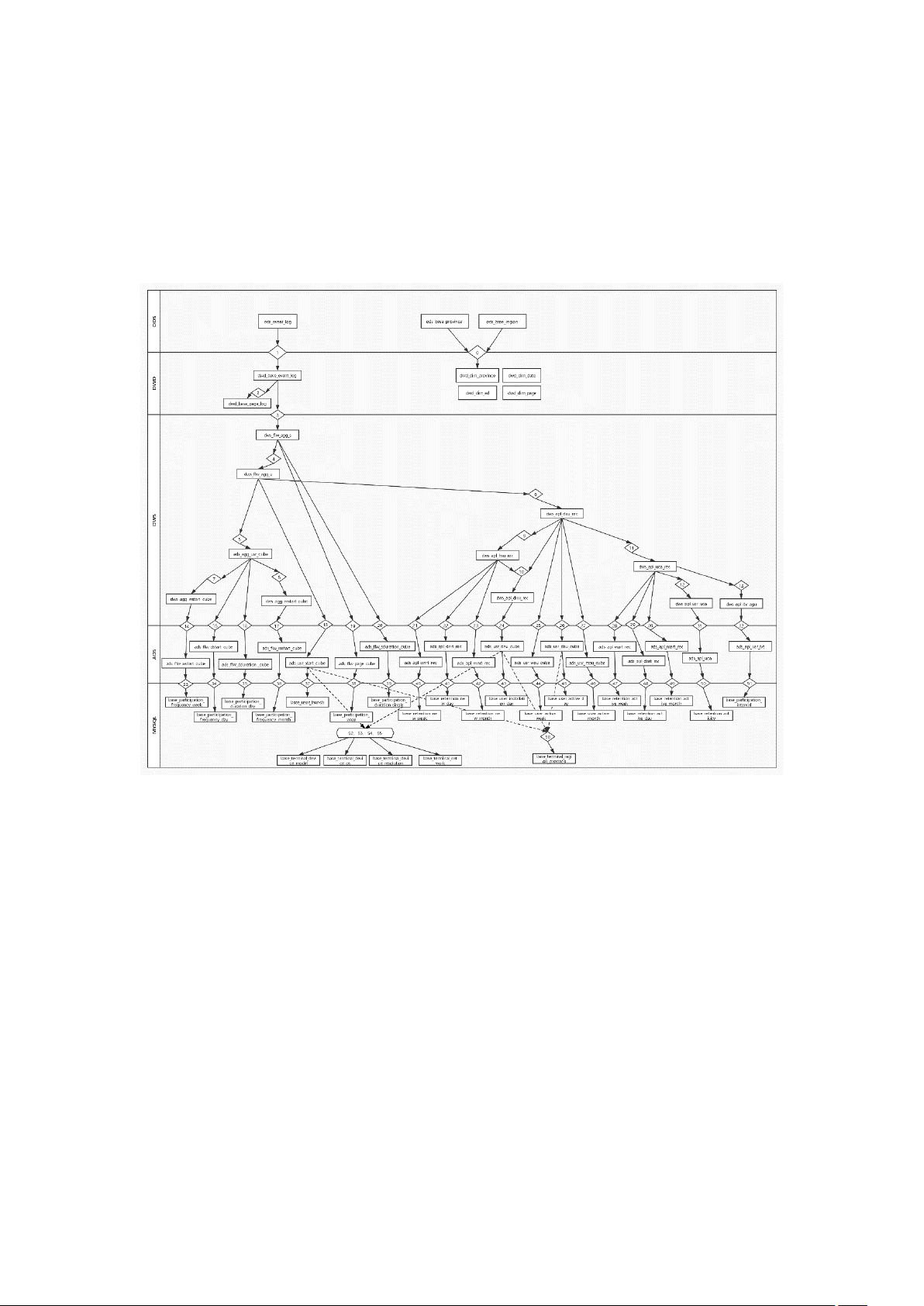

Spark任务设计1主要涉及大数据处理流程中的多个关键环节,针对一个典型的数据仓库应用场景进行详细设计。以下是各个步骤及其关联的知识点:

1. **数仓结构设计**:

- 从ODS层(操作数据层)开始,首先构建省份和地域维度表,通过JOIN操作整合生成DWD层(详细维度数据)的身份维度表,这是基础数据清洗和整合过程。

2. **数据清洗与解析**:

- 解析ODS层的原始日志文件,利用JSON解析技术生成DWD层的基本日志事件表,这一步骤涉及到ETL(提取、转换、加载)过程中的数据抽取与格式转换。

3. **事件筛选与分析**:

- 筛选并解析基本日志事件表,形成专门的页面日志表,这包括对业务事件的识别和深层次分析。

4. **流量会话分析**:

- 通过sessionid对基本日志事件表进行聚合和离散化处理,得到DWS层(数据仓库服务)的流量会话聚合表,涉及窗口函数和流式处理。

5. **用户行为汇总**:

- 对流量会话聚合表进行用户ID和不同维度的聚合,生成流量用户聚合表,这涉及分组聚合操作。

6. **用户活跃度计算**:

- 从流量用户聚合表中提取中间结果,如日活记录表、周启动数和月启动数,用于后续活跃度评估。

7. **维度报表生成**:

- 按照启动数、使用时长等指标对数据进行多维聚合,生成周启动数流量多维报表、日启动数流量多维报表等,体现了Spark SQL或DataFrame API在复杂查询上的应用。

8. **用户行为分析**:

- 计算留存率、访问间隔分布等用户行为特征,如活跃度和访问频率,这些都属于用户行为分析的关键指标。

9. **新增用户追踪**:

- 利用留存天数计算,通过与历史访问记录的对比,分析新用户的获取和留存情况,涉及窗口函数和数据过滤。

10. **多维度报表生成**:

- 最后,根据需求生成日新数多维报表、周活数多维报表等,这些是业务决策的重要数据来源。

在整个过程中,Spark任务设计充分展示了数据仓库设计的生命周期,从数据源的接入、清洗、转换,到数据的存储、分析和报告生成,都是围绕着业务需求进行的。Spark的分布式计算能力和数据处理性能使得这些任务可以高效完成,且易于扩展和优化。

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

2018-02-08 上传

2018-02-08 上传

2018-02-08 上传

2022-08-03 上传

2016-12-26 上传

shashashalalala

- 粉丝: 28

- 资源: 285

最新资源

- 火炬连体网络在MNIST的2D嵌入实现示例

- Angular插件增强Application Insights JavaScript SDK功能

- 实时三维重建:InfiniTAM的ros驱动应用

- Spring与Mybatis整合的配置与实践

- Vozy前端技术测试深入体验与模板参考

- React应用实现语音转文字功能介绍

- PHPMailer-6.6.4: PHP邮件收发类库的详细介绍

- Felineboard:为猫主人设计的交互式仪表板

- PGRFileManager:功能强大的开源Ajax文件管理器

- Pytest-Html定制测试报告与源代码封装教程

- Angular开发与部署指南:从创建到测试

- BASIC-BINARY-IPC系统:进程间通信的非阻塞接口

- LTK3D: Common Lisp中的基础3D图形实现

- Timer-Counter-Lister:官方源代码及更新发布

- Galaxia REST API:面向地球问题的解决方案

- Node.js模块:随机动物实例教程与源码解析