数据挖掘作业:决策树与朴素贝叶斯分类实践

版权申诉

"该资源是一份关于决策树分类和朴素贝叶斯分类的练习题及其解答,主要涉及数据挖掘中的算法应用。提供的数据集来自一个雇员数据库,包含泛化的属性如部门(department)、职位级别(status)、年龄范围(age)和薪水区间(salary)。数据集还给出了不同属性值的计数(count),用于统计分析。"

在这个问题中,我们首先关注的是决策树算法的改进。决策树是一种监督学习方法,通常用于分类任务。在基本的决策树算法中,每个节点根据一个特征的分割来分裂数据,目的是最大化信息增益或基尼不纯度等指标。然而,原始的决策树算法可能无法处理这里给出的广义数据元组,因为它们代表了连续范围的值,而不是离散的类别。

为了考虑每个广义数据元组的count,我们可以采用以下方法:

1. **加权信息增益**:在计算信息增益时,可以考虑每个数据元组的count,即将每个子集的信息熵乘以其对应的计数,然后按比例分配给父节点。这样,频繁出现的数据元组将对信息增益产生更大的影响。

2. **区间划分**:对于连续属性如年龄和薪水,可以采用不同的划分策略,比如等宽或等频划分,将连续区间转换为离散类别,每个类别的大小可以基于count进行调整。

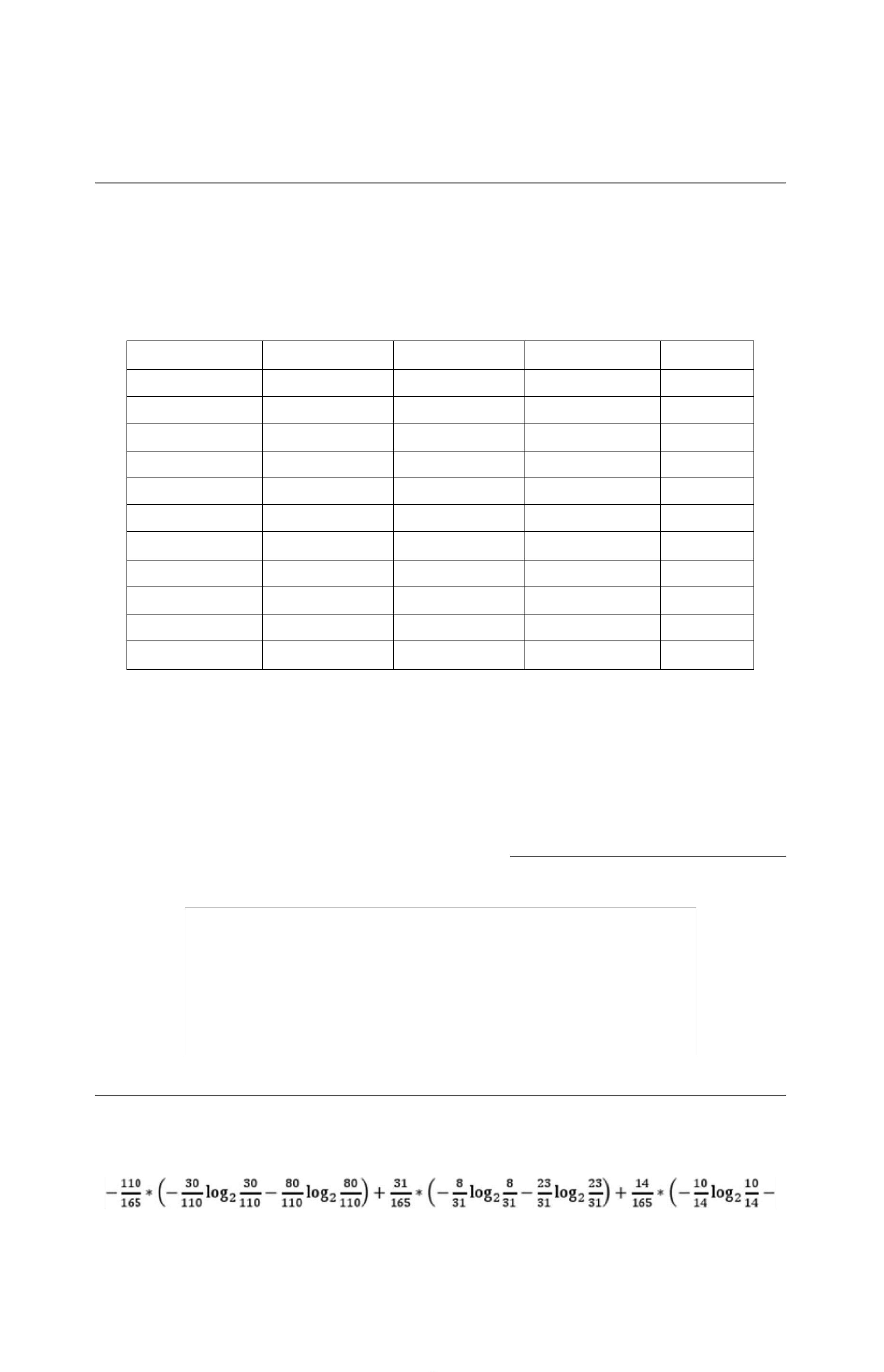

接着,我们看到了各个类别和属性的统计信息:

- 职位级别(status)分为两个类别:Senior和Junior,它们的计数分别是52和113。

- 部门(department)分为四个类别:Sales、Systems、Marketing和Secretary,它们的计数分别为110、31、14和10。

- 年龄分为六个区间,而薪水分为六个区间,每个区间的计数也已给出。

通过计算信息熵,我们可以评估各个属性的不确定性。例如,`Info(D)`是整个数据集的熵,`Info(department)`是部门属性的条件熵,信息增益`Gain(department)`表示通过部门属性划分数据能减少的不确定度。

信息熵是衡量数据集纯度的一个指标,其计算公式为`-∑(p_i * log2(p_i))`,其中`p_i`是第i个类别的频率。条件熵则是考虑到某个属性后数据的熵,计算时需要考虑该属性每个值的频率以及这些值下子集的熵。

在给出的示例中,我们计算了`Info(D)`和`Info(department)`,并用它们之间的差值得到了`Gain(department)`,这是选择部门作为分割特征的信息增益。较高的信息增益意味着该属性对于分类更有帮助。

最后,我们注意到问题中提到了一个计算公式,这可能是用来比较不同特征的信息增益。这个公式涉及到了对不同类别计数的处理,进一步说明了在决策树构建过程中,如何利用count信息来优化特征选择。

这份练习题旨在考察如何在决策树中处理连续属性和频次信息,并且如何利用这些信息来构建更有效的分类模型。此外,还可能涉及到如何结合朴素贝叶斯分类器,它假设属性之间相互独立,并基于每个属性的概率来进行预测。在实际应用中,这两种方法都十分常见,尤其是在数据挖掘和机器学习领域。

2010-03-30 上传

2023-04-02 上传

2023-06-08 上传

2023-05-28 上传

2023-06-03 上传

2023-06-12 上传

2023-03-30 上传

赵鲁宾

- 粉丝: 0

- 资源: 2908

最新资源

- scoop-bucket

- QuickFork:QuickFork允许您从git repo创建符号链接

- Urban Abodes Craigslist Posting-crx插件

- obdgpslogger-0.15.zip_GPS编程_Unix_Linux_

- afs42d-开源

- 人工智能学习课程练习.zip

- 参考资料-409.混凝土拌合用水质量检查报告.zip

- matlab心线代码-electrostatic-simulation-tools:我有效使用SIMION进行电子和离子光谱仪设计的工具(VM

- sysdigcloud-kubernetes:Kubernetes上的Sysdig Cloud

- 你好,世界

- opencv_test.rar_视频捕捉/采集_Visual_C++_

- familyline-server-test:测试服务器,提供有关Familyline网络协议的想法

- torch_sparse-0.6.10-cp39-cp39-win_amd64whl.zip

- matlab人脸检测框脸代码-ait-research-study-finished:我的研究的最终版本

- 人工智能经典算法Python实现.zip

- benjamingeets