后Hadoop时代:大数据技术的转型与数据服务

20 浏览量

更新于2024-08-28

收藏 1000KB PDF 举报

"后Hadoop时代的大数据技术思考:数据即服务"

在当前的数据时代,随着技术的不断发展,Hadoop作为大数据处理的核心组件,其地位正经历着转变。IBM的BigInsights for Hadoop基础计划的退役标志着一个时代的结束,这引发了关于后Hadoop时代大数据技术的新一轮思考。Gartner的报告进一步强调了70%以上的Hadoop部署未能实现预期的业务价值,这表明Hadoop可能并未完全兑现其承诺。

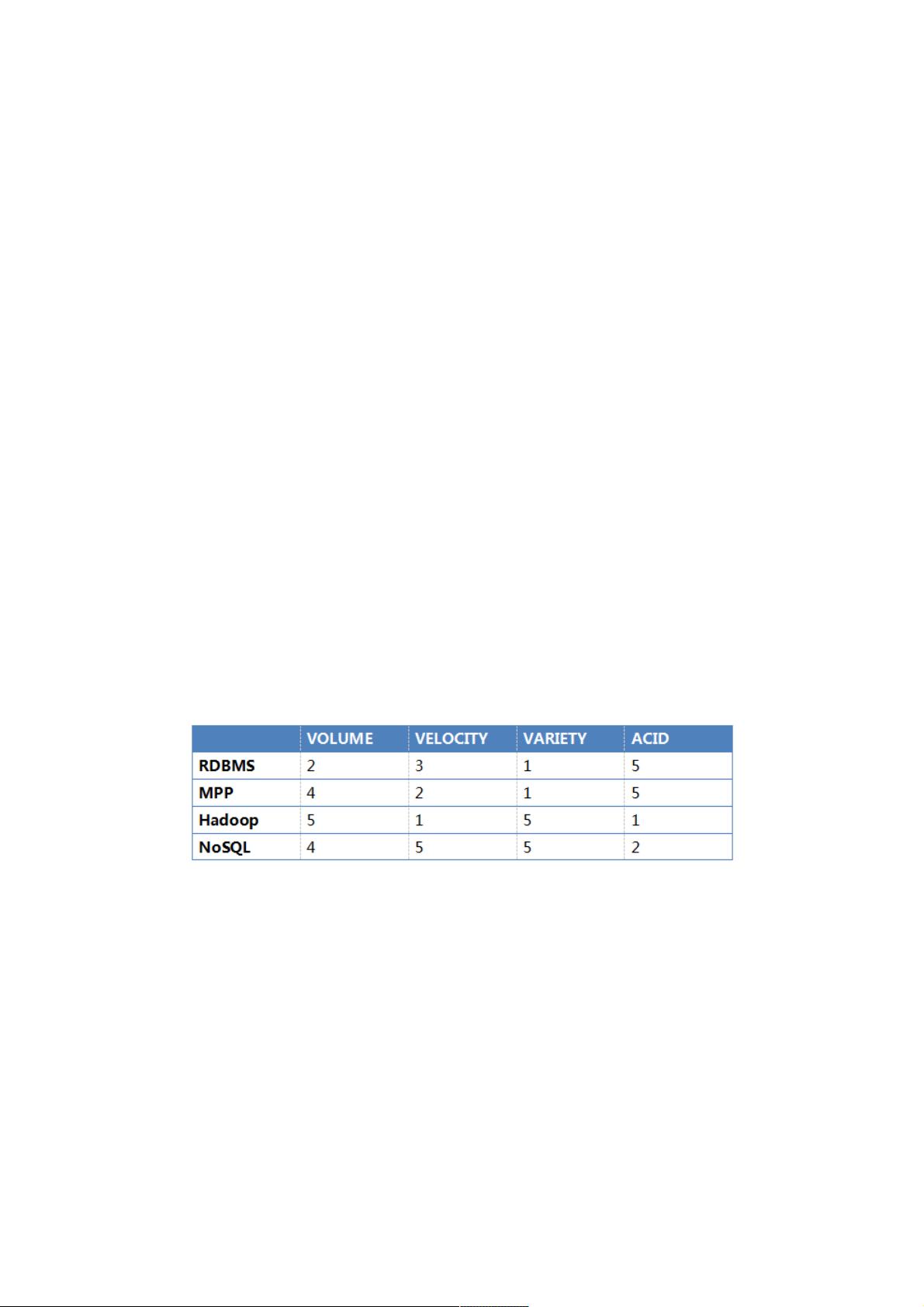

Hadoop最初因其分布式计算框架和低成本存储的优势而受到追捧,尤其适合于处理非结构化和半结构化数据。然而,它在实时处理、事务处理和数据管理方面存在局限性,导致其在面对复杂业务需求时显得力不从心。以下是几种常见的大数据处理技术的比较:

1. **关系型数据库管理系统(RDBMS)**:传统的RDBMS如Oracle、MySQL等,擅长处理结构化数据,提供ACID事务支持,保证数据的一致性和完整性。在Volume(数据量)和Velocity(数据访问速度)上可能受限,但在Variety(数据多样性)方面得分较低,因为它们主要设计用于处理特定结构的数据。

2. **大规模并行处理(MPP)数据库**:如Teradata、Greenplum等,这类系统通过分布式架构处理大量数据,适合于数据分析任务,对Volume有很好的支持,但Velocity和Variety处理能力有限,通常不适用于实时分析或非结构化数据。

3. **Hadoop**:Hadoop通过HDFS和MapReduce提供了大数据存储和处理的能力,适合批处理任务,Volume得分高,但在Velocity和Variety上相对较弱,不擅长实时查询和处理多样性的数据。

4. **NoSQL数据库**:MongoDB、Cassandra等,针对非结构化和半结构化数据,提供高可用性和水平扩展性,Variety得分高,但通常在ACID事务支持和一致性方面有所妥协。

5. **NewSQL数据库**:如TiDB、CockroachDB,旨在结合传统RDBMS的事务处理能力和NoSQL的可扩展性,支持大规模并发和实时处理,但这类新技术仍需时间验证,目前成熟度和广泛接受度有待提高。

在后Hadoop时代,数据即服务(Data as a Service, DaaS)的理念逐渐兴起,强调数据应作为可随时获取、分析和利用的服务。这种趋势推动了更灵活、高效的数据处理框架的发展,如Spark、Flink等,它们在实时处理和交互式分析方面表现突出,同时,云服务提供商如AWS、Google Cloud和Azure提供的大数据解决方案也在不断优化,提供全面的数据服务。

未来,大数据技术将继续演进,可能的方向包括更强大的实时分析能力、对多样数据类型的更好支持,以及更智能的数据管理与治理。企业需要根据自身的业务需求,谨慎选择合适的技术栈,以实现数据的最大价值。同时,数据安全、隐私保护和法规遵从也将成为大数据技术发展的重要考量因素。

点击了解资源详情

点击了解资源详情

点击了解资源详情

651 浏览量

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

点击了解资源详情

weixin_38635979

- 粉丝: 4

- 资源: 914