深入理解Spark on Yarn Executor内存管理与常见问题解决

需积分: 0 30 浏览量

更新于2024-08-05

收藏 2.01MB PDF 举报

Spark on Yarn是Apache Spark在Hadoop YARN(Yet Another Resource Negotiator)平台上的运行架构,它将工作负载分布到多台计算节点(Worker Node)上的Executor进程中。Executor内存管理是确保Spark性能的关键环节,因为它直接影响任务执行效率和集群资源利用率。

1. **堆内和堆外内存规划**

在Spark中,Executor的内存被划分为两个部分:JVM堆内内存和Off-heap内存。JVM堆内内存(On-Heap)是由`--executor-memory`参数设置的,主要用于任务执行时的Java对象和数据存储。这些内存是JVM托管的,会受到垃圾回收(GC)的影响,可能导致性能损耗。另一方面,Off-heap内存(Off-Heap)是Spark引入的一种模式,通过`spark.yarn.executor.memoryOverhead`来配置,主要用来处理非Java对象,如字符串、NIO缓冲区等,这部分内存是独立于JVM Heap之外的,可以减少GC开销,提供更高的内存利用效率。

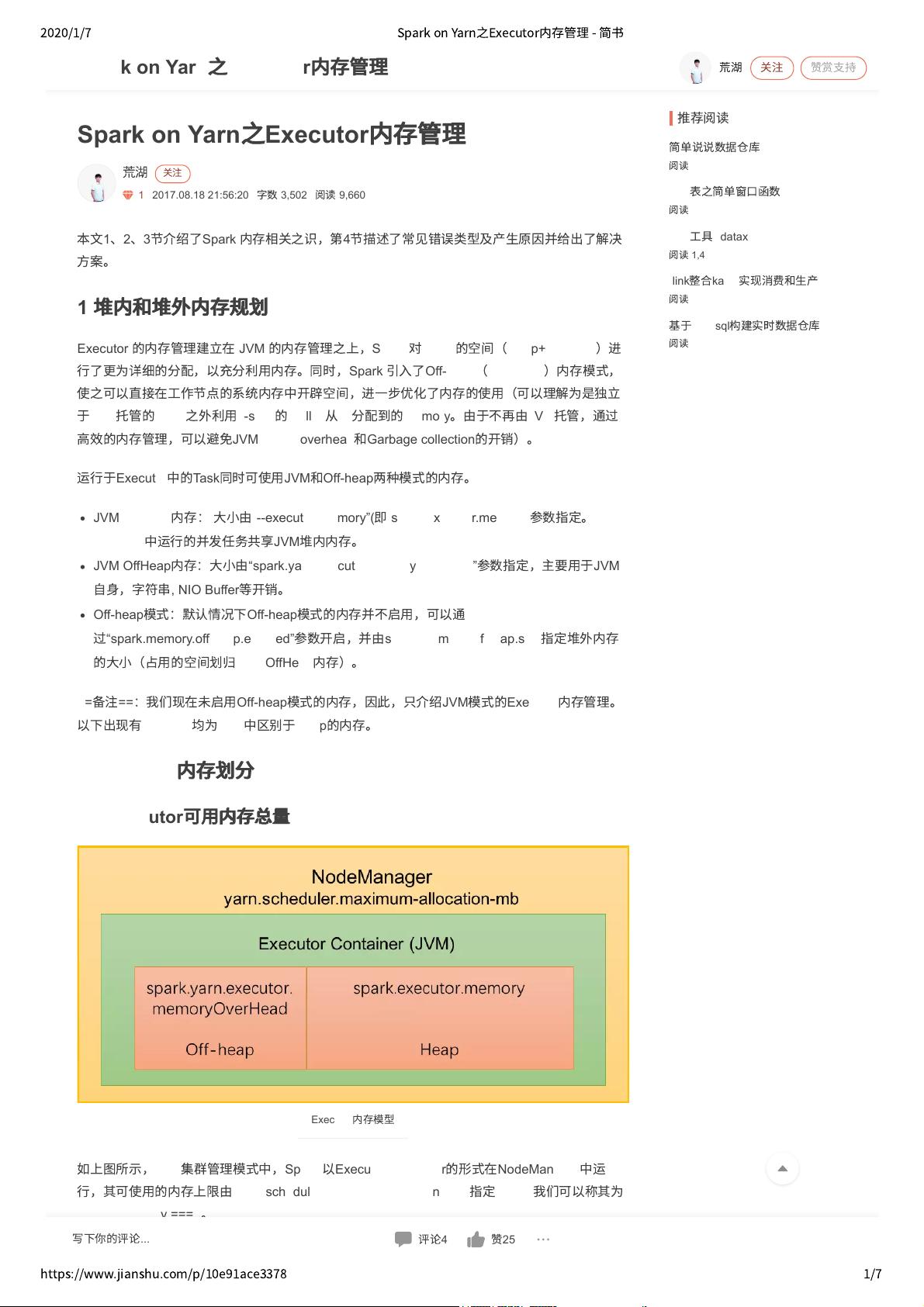

2. **内存划分与可用总量**

Executor的总内存由JVM堆内存和Off-heap内存组成。在YARN模式下,集群管理员需要考虑所有Executor的内存需求,因为每个Executor都有自己的资源份额。Spark内存模型明确地展示了Executor内存的分配结构,包括堆内内存的使用情况以及Off-heap内存的启用与否。

3. **Off-heap模式**

默认情况下,Off-heap内存是关闭的,但可以通过`spark.memory.offHeap.enabled`参数开启。当开启后,用户可以通过`spark.memory.offHeap.size`设置Off-heap内存大小。这个模式的优势在于能够减少Java对象的内存占用,提高内存操作速度,但可能需要根据应用的具体需求进行调整,以防止可能带来的额外复杂性。

4. **常见错误类型及解决方案**

该部分并未在提供的摘录中详细介绍,但通常涉及到内存溢出(Out-of-Memory Error)、资源竞争(如多个任务争夺同一部分内存)或性能瓶颈(由于内存管理不当导致的)。解决这类问题可能涉及调整内存参数、优化任务并行度、或者在必要时使用内存溢出监控工具来诊断和优化内存使用。

Spark on Yarn下的Executor内存管理涉及细致的配置和优化,以确保集群的稳定性和性能。理解这些概念对于有效地部署和管理大规模Spark应用程序至关重要。

2016-12-24 上传

2015-09-22 上传

2021-05-18 上传

2024-09-16 上传

2023-03-16 上传

2023-04-07 上传

2023-06-09 上传

2023-02-15 上传