KafkaConsumer详解:ConsumerGroup与HighLevelConsumer

114 浏览量

更新于2024-08-27

收藏 1.01MB PDF 举报

"Kafka设计解析(五)-KafkaConsumer设计解析"

KafkaConsumer是Apache Kafka的核心组件之一,它负责从Kafka主题中消费消息。本文深入解析了KafkaConsumer,特别是HighLevelConsumer的设计和其在Kafka生态系统中的角色。在Kafka中,消费者不再是一个独立的实体,而是作为ConsumerGroup的一部分进行工作。

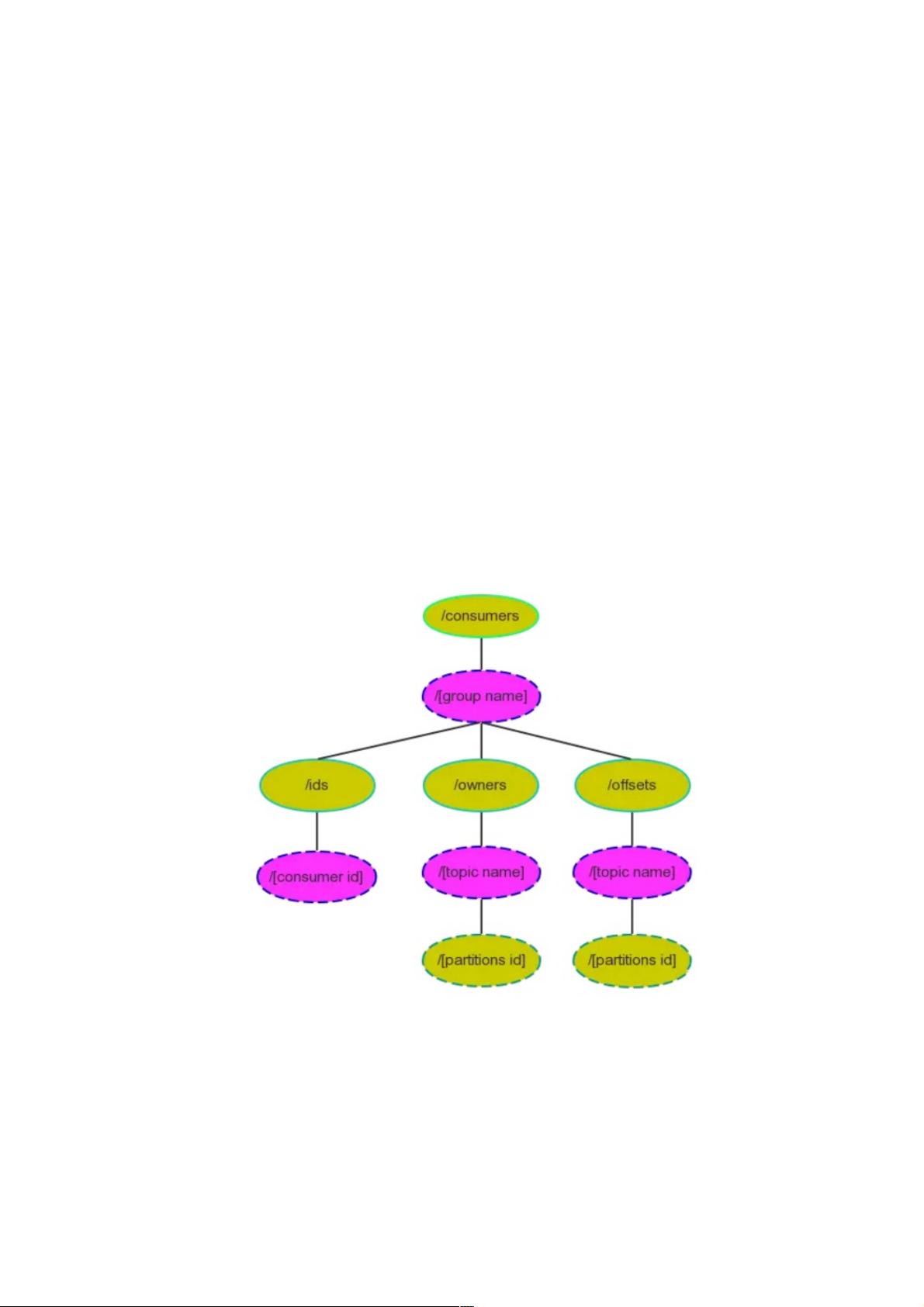

HighLevelConsumer是为了解决应用程序对消息消费的复杂需求而设计的。它提供了一种高层次的抽象,允许消费者专注于数据处理,而不必关注消息偏移量(offset)的管理。消息偏移量是消费者跟踪其在主题分区中消费位置的关键指标。HighLevelConsumer自动将这些offset存储在Zookeeper(0.8.2版之前)或者从0.8.2版开始支持的专用Kafka主题中,以确保消费状态的持久化。

ConsumerGroup是KafkaConsumer设计的另一个关键概念。每个HighLevelConsumer实例都属于一个特定的ConsumerGroup,即使没有显式指定,也会自动加入默认的组。当多个消费者属于同一个ConsumerGroup时,它们共同消费主题的分区,形成一种负载均衡的方式。每个分区只能由组内的一个消费者进行消费,这样确保了消息的独占消费,防止重复处理。

在ConsumerGroup中,如果一个消费者失败,其负责的分区将由组内的其他消费者接管,这就是ConsumerRebalance过程。当消费者加入、离开或因故障转移时,会触发重平衡,以保持整个组的均衡状态。然而,这可能导致SplitBrain或Herd问题,即在网络分区或消费者集群扩展收缩时,同一组内的消费者可能对offset管理产生冲突。为解决这些问题,未来版本的Kafka引入了ConsumerCoordinator,它协调ConsumerGroup的行为,确保一致性并避免冲突。

LowLevelConsumer则提供了更底层的API,允许开发者更细粒度地控制消息消费,但需要自行管理offset。它适用于需要更多定制功能的场景,比如自定义的负载均衡策略或者更复杂的消费逻辑。

Kafka的一个独特之处在于,它并不删除已经消费的消息,而是保持消息在 brokers 中持久化,以便于回溯或者重放。为了实现类似传统消息队列(MessageQueue)中消息仅被消费一次的语义,Kafka通过ConsumerGroup和offset管理来确保消息的唯一消费。这意味着每个消息在同一个ConsumerGroup中只会被一个消费者消费一次,即使消息被多次拉取,也不会重复处理。

在实际应用中,根据需求可以选择HighLevelConsumer的简单性和易用性,或者LowLevelConsumer的灵活性。Kafka的Consumer设计使得它能够适应各种分布式系统的需求,从简单的日志收集到复杂的实时数据流处理。理解Consumer的工作原理和特性对于构建高效、可靠的Kafka消费端应用至关重要。

160 浏览量

667 浏览量

620 浏览量

2025-03-13 上传

2024-12-21 上传

2025-01-23 上传

111 浏览量

235 浏览量

2024-12-03 上传

weixin_38688956

- 粉丝: 4

最新资源

- 富文本编辑器图片获取与缩略图设置方法

- 亿图画图工具:便捷流程图设计软件

- C#实现移动二次曲面拟合法在DEM内插中的应用

- Symfony2中VreshTwilioBundle:Twilio官方SDK的扩展包装器

- Delphi调用.NET DLL的Win32交互技术解析

- C#基类库大全:全面解读.NET类库与示例

- 《计算机应用基础》第2版PPT教学资料介绍

- VehicleHelpAPI正式公开:发布问题获取使用权限

- MATLAB车牌自动检测与识别系统

- DunglasTorControlBundle:Symfony环境下TorControl的集成实现

- ReactBaiduMap:打造React生态的地图组件解决方案

- 卡巴斯基KEY工具:无限期循环激活解决方案

- 简易绿色版家用FTP服务器:安装免、直接配置

- Java Mini Game Collection解析与实战

- 继电器项目源码及使用说明

- WinRAR皮肤合集:满足不同风格需求