揭秘ChatGPT背后的自注意力与强化学习技术

需积分: 0 146 浏览量

更新于2024-08-04

收藏 1.82MB DOCX 举报

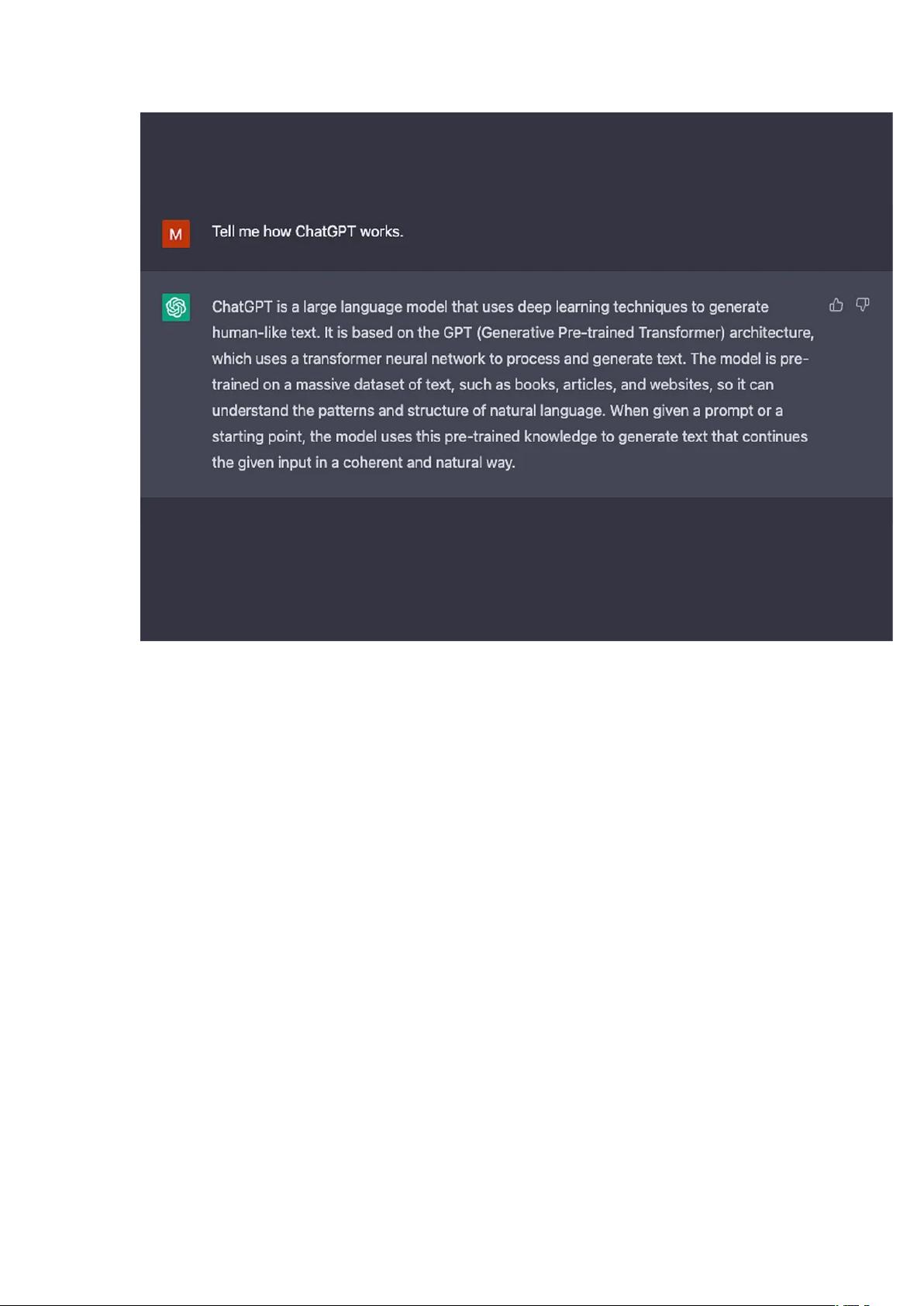

ChatGPT技术解析深入探讨了支撑这款强大AI聊天助手背后的机器学习原理。ChatGPT基于大语言模型(LLMs),这是一种利用深度学习技术处理和理解大量文本数据的模型。LLMs的核心训练任务包括next-token-prediction和masked-language-modeling,这两种方法允许模型预测序列中的下一个词或填充被遮盖的词汇。

基础的next-token-prediction任务通常采用长短期记忆网络(LSTM)来执行,LSTM通过分析上下文中的信息来生成最可能的词。然而,LSTM存在两个局限性:

1. 它无法给予某些词更高的权重,即使这些词在特定上下文中更合适。例如,在一个例子中,尽管“reading”可能通常与“hates”关联,但如果考虑到用户“Jacob”的具体情况,模型可能应给予“love”更高的权重,这在LSTM模型中难以实现。

2. LSTM处理输入数据的方式是顺序的,上下文窗口有限,导致模型在处理复杂语义和长距离依赖时能力受限。

为解决这些问题,Transformer模型在2017年由Google Brain团队引入。Transformers采用自注意力机制(self-attention mechanism),这是一个革命性的设计,它能同时处理所有输入元素,允许模型根据整个序列的全局信息来决定每个词的重要性。这意味着Transformer能够捕捉更复杂的词汇关系,并且不受固定上下文窗口的限制,从而提高了模型的语义理解和生成能力。

在训练过程中,ChatGPT结合了自注意力机制和强化学习。通过人类的反馈,模型不断调整其策略,优化生成的文本的准确性和连贯性。这种结合使得ChatGPT能够生成流畅、连贯的对话,适应各种主题,并在交互中展现出智能和学习能力。

总结来说,ChatGPT技术的关键在于其基于Transformer的大规模语言模型,通过自注意力机制处理上下文,以及通过强化学习机制持续学习和改进。这使得它超越了传统的序列建模技术,成为了一种高度灵活和适应性强的自然语言处理工具。

2023-10-08 上传

2023-12-13 上传

2023-11-20 上传

2023-04-29 上传

点击了解资源详情

点击了解资源详情

点击了解资源详情

凭空起惊雷

- 粉丝: 7993

- 资源: 1188

最新资源

- Raspberry Pi OpenCL驱动程序安装与QEMU仿真指南

- Apache RocketMQ Go客户端:全面支持与消息处理功能

- WStage平台:无线传感器网络阶段数据交互技术

- 基于Java SpringBoot和微信小程序的ssm智能仓储系统开发

- CorrectMe项目:自动更正与建议API的开发与应用

- IdeaBiz请求处理程序JAVA:自动化API调用与令牌管理

- 墨西哥面包店研讨会:介绍关键业绩指标(KPI)与评估标准

- 2014年Android音乐播放器源码学习分享

- CleverRecyclerView扩展库:滑动效果与特性增强

- 利用Python和SURF特征识别斑点猫图像

- Wurpr开源PHP MySQL包装器:安全易用且高效

- Scratch少儿编程:Kanon妹系闹钟音效素材包

- 食品分享社交应用的开发教程与功能介绍

- Cookies by lfj.io: 浏览数据智能管理与同步工具

- 掌握SSH框架与SpringMVC Hibernate集成教程

- C语言实现FFT算法及互相关性能优化指南