Hadoop分布式文件系统HDFS详解及Shell操作

下载需积分: 50 | PDF格式 | 12.93MB |

更新于2024-07-22

| 17 浏览量 | 举报

"hadoop的shell命令,包括HDFS的shell操作和java接口"

在Hadoop生态中,Shell命令是管理员和开发者与HDFS(Hadoop Distributed File System)交互的重要工具。HDFS作为分布式文件系统,它是Hadoop的核心组成部分,设计用于处理海量数据,尤其适合大规模数据的一次写入、多次读取的场景。由于传统的文件系统无法满足大数据存储的需求,HDFS应运而生,它将数据分布在多台节点上,提供了高可用性和容错性。

分布式文件系统与HDFS:

分布式文件系统允许通过网络在多台计算机之间共享文件和存储空间。HDFS是Apache Hadoop项目的一部分,其设计目标是实现高吞吐量的数据访问,并且具有良好的容错性。HDFS的一个关键特性是它的分块存储,将大文件分割成多个块,这些块可以在集群的不同节点上进行冗余存储,以提高数据的可用性和可靠性。

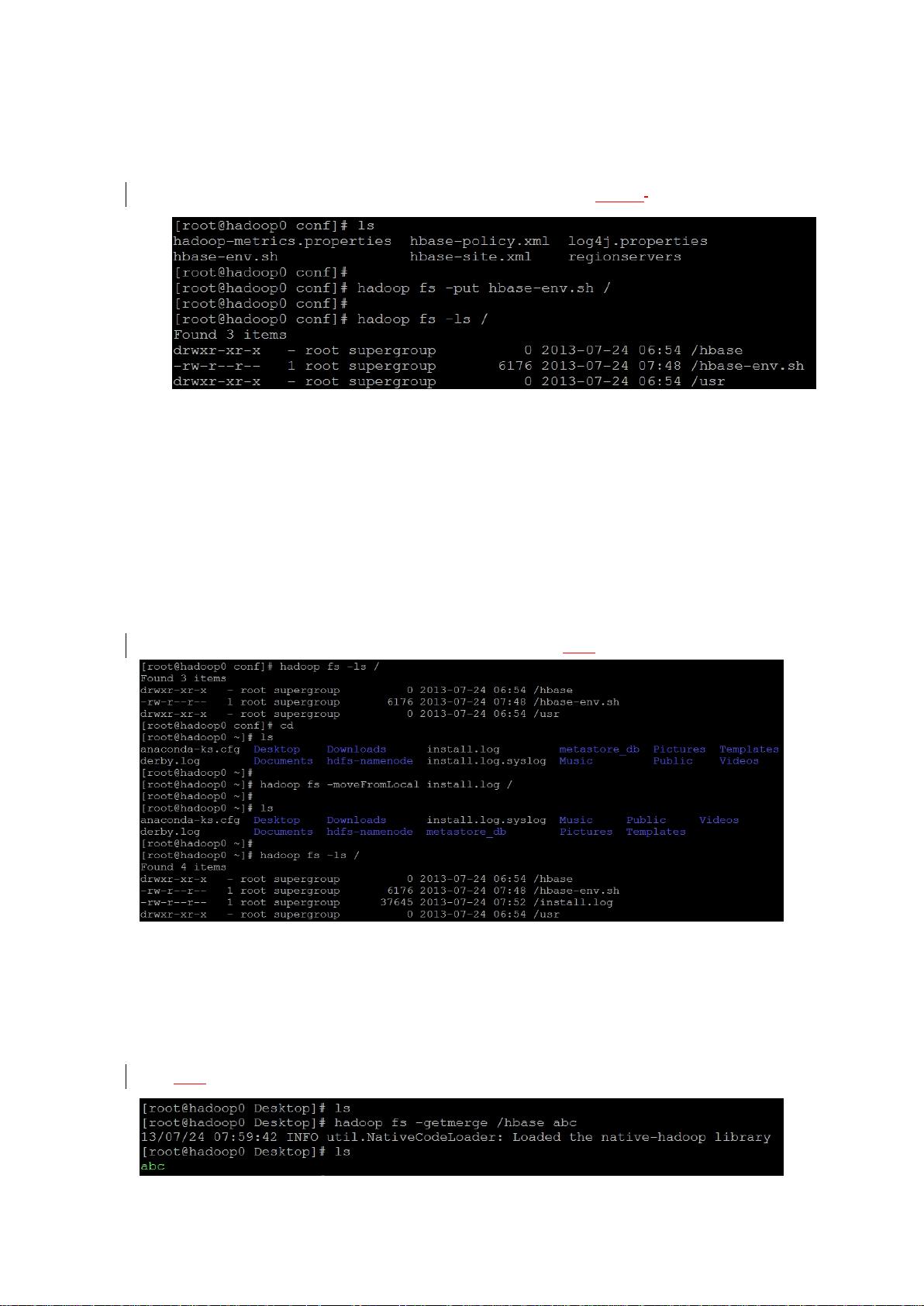

HDFS的shell操作:

在Hadoop环境中,用户可以通过命令行接口(CLI)执行类似于Linux shell的命令来操作HDFS。例如,`ls`用于列出目录内容,`mkdir`用于创建目录,`rm`用于删除文件或目录,`mv`用于移动文件或重命名,`chmod`用于更改文件或目录的权限。这些命令使得在分布式环境中管理文件变得直观和便捷。

HDFS的Java接口及常用API:

对于开发人员,Hadoop提供了Java API来直接与HDFS进行交互,这允许编写应用程序来读取、写入和操作HDFS中的数据。主要的API类包括`FileSystem`、`FSDataInputStream`和`FSDataOutputStream`等,它们提供了丰富的功能,如打开、关闭文件,读写数据,以及执行文件和目录操作。

Hadoop的RPC机制:

HDFS基于Remote Procedure Call (RPC)机制实现节点间的通信。RPC允许客户端程序调用远程服务器上的方法,就像调用本地方法一样。Hadoop中的RPC是基于protobuf协议的,它提供了高效、安全的跨进程通信方式。

Hadoop读写数据的过程分析:

Hadoop读取数据时,首先会通过NameNode找到对应数据块的位置,然后由DataNode提供数据服务。写入数据时,HDFS会先写入副本,确保数据的高可用性,然后再更新元数据信息。

学习Hadoop,尤其是在初期,可以通过模拟Windows文件系统的理解来帮助掌握HDFS的工作原理。理解HDFS的这些基本概念和操作命令,对于理解和使用Hadoop生态系统至关重要。通过实践HDFS的shell命令和开发Java应用,可以深入理解Hadoop的数据存储和处理机制。同时,了解Hadoop的RPC机制也有助于深入掌握Hadoop集群内部的通信方式。

相关推荐

hery_csdn

- 粉丝: 0

最新资源

- C语言实现LED灯控制的源码教程及使用说明

- zxingdemo实现高效条形码扫描技术解析

- Android项目实践:RecyclerView与Grid View的高效布局

- .NET分层架构的优势与实战应用

- Unity中实现百度人脸识别登录教程

- 解决ListView和ViewPager及TabHost的触摸冲突

- 轻松实现ASP购物车功能的源码及数据库下载

- 电脑刷新慢的快速解决方法

- Condor Framework: 构建高性能Node.js GRPC服务的Alpha框架

- 社交媒体图像中的抗议与暴力检测模型实现

- Android Support Library v4 安装与配置教程

- Android中文API合集——中文翻译组出品

- 暗组计算机远程管理软件V1.0 - 远程控制与管理工具

- NVIDIA GPU深度学习环境搭建全攻略

- 丰富的人物行走动画素材库

- 高效汉字拼音转换工具TinyPinYin_v2.0.3发布