Sqoop1安装与使用教程:从入门到实践

需积分: 9 31 浏览量

更新于2024-09-08

收藏 359KB DOCX 举报

"Sqoop安装与使用"

Sqoop是一款强大的数据迁移工具,专为在Hadoop与传统的关系型数据库之间批量转移数据而设计。它利用MapReduce的并行处理能力,加速了大规模数据集的导入和导出过程。尽管存在两个主要版本——Sqoop1和Sqoop2,但 Sqoop1在实际应用中更为稳定,因此这里我们将重点讨论Sqoop1的安装和使用。

** Sqoop1 的功能与特点**

1. **数据迁移**:Sqoop允许用户将关系型数据库(如MySQL、Oracle等)中的数据导入到Hadoop的HDFS,或者将Hadoop中的数据导出回数据库,实现了数据的双向流动。

2. **批处理**:通过MapReduce作业,Sqoop能高效地处理大量数据,尤其适合大规模的数据迁移任务。

3. **全表导入与增量导入**:除了完整的数据表导入外,Sqoop还支持只导入自上次导入以来发生变化的数据,这对于持续监控和更新数据库非常有用。

4. **集成Hive和HBase**:Sqoop能够直接将数据导入Hive数据仓库,以及HBase分布式数据库,便于数据分析和存储。

** Sqoop的安装步骤**

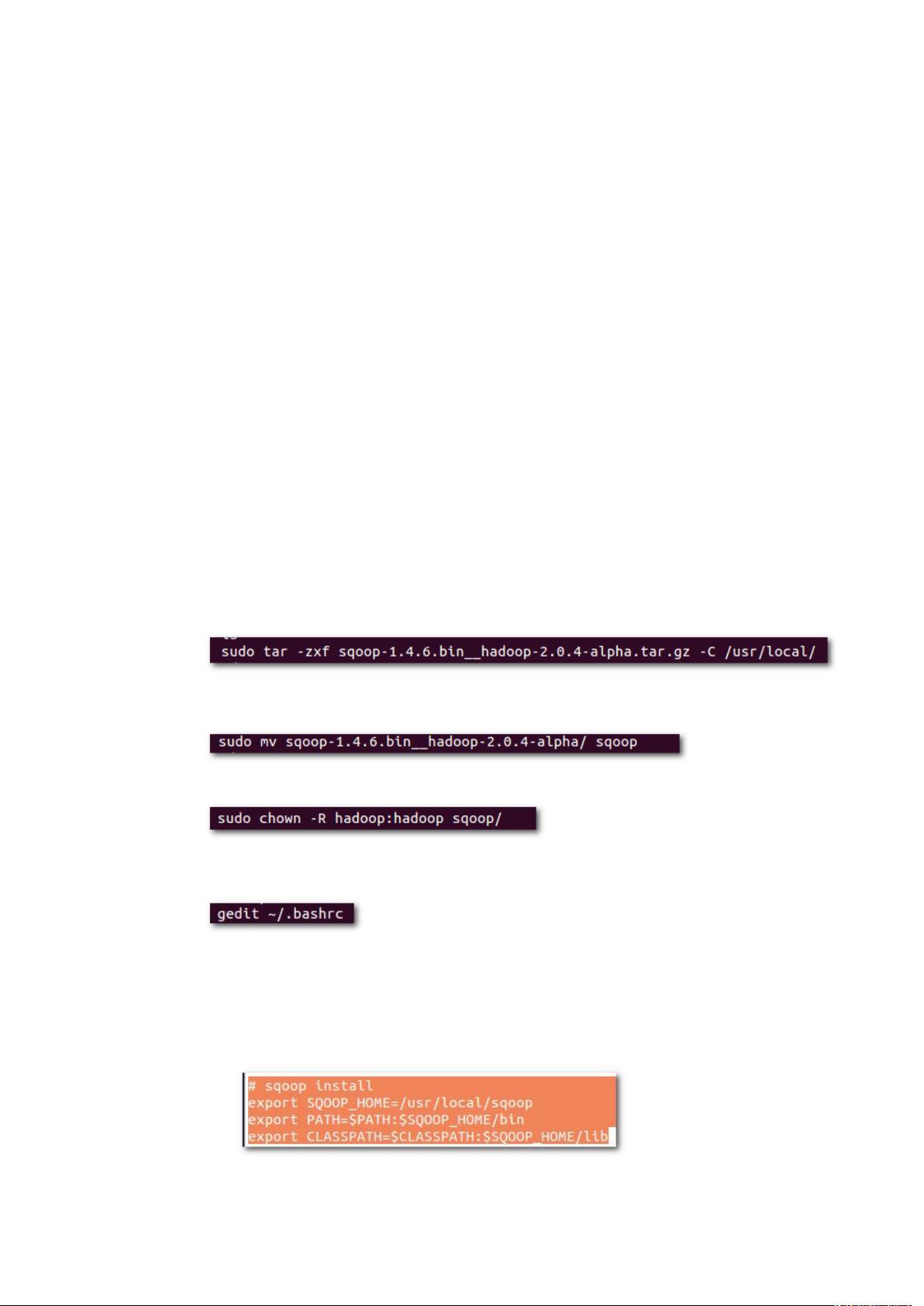

1. **解压与移动**:首先解压缩下载的Sqoop安装包,如`sqoop-1.4.6.bin__hadoop-2.0.4-alpha.tar.gz`,然后将其移动到适当的位置,例如`/usr/local/`,并重命名为`sqoop`。

2. **修改所有者和权限**:使用`chown`命令将目录所有者更改为Hadoop用户,确保正确执行Sqoop命令。

3. **设置环境变量**:编辑用户的`.bashrc`文件,添加`SQOOP_HOME`,`PATH`和`CLASSPATH`,指明Sqoop的安装路径。

4. **使环境变量生效**:运行`source ~/.bashrc`以应用环境变量更改。

5. **配置文件**:复制`sqoop-env-template.sh`到`sqoop-env.sh`,并根据实际环境配置`HADOOP_COMMON_HOME`,`HADOOP_MAPRED_HOME`,`HBASE_HOME`和`HIVE_HOME`等环境变量。

** 使用Sqoop的基本命令**

1. **导入数据**:使用`import`命令将数据库中的表导入HDFS,例如`sqoop import --connect <DB_URL> --table <TABLE_NAME> --target-dir <HDFS_DIR>`。

2. **导出数据**:使用`export`命令将HDFS中的数据导出到数据库,如`sqoop export --connect <DB_URL> --table <TABLE_NAME> --export-dir <HDFS_DIR>`。

3. **增量导入**:通过指定`--incremental`参数和`--check-column`来实现只导入新数据或更新数据的功能。

** Sqoop与其他大数据组件的交互**

1. **与Hive的交互**: Sqoop可以将数据库表直接导入Hive创建的表中,简化数据准备流程,例如`--hive-import`选项。

2. **与HBase的交互**: Sqoop提供了将数据直接导入HBase的功能,通过指定HBase的表和列族信息完成。

通过这些步骤,你可以成功安装和配置 Sqoop,并开始在Hadoop和数据库之间进行数据迁移。理解如何有效地使用Sqoop对于大数据项目来说至关重要,因为它极大地提高了数据处理的效率和灵活性。在实际操作中,还需注意调整配置以适应不同的数据库和Hadoop集群环境。

点击了解资源详情

点击了解资源详情

点击了解资源详情

2017-07-24 上传

2017-04-07 上传

2018-08-01 上传

2022-11-24 上传

2022-11-24 上传

2018-11-15 上传

长安一片月

- 粉丝: 13

- 资源: 5

最新资源

- 俄罗斯RTSD数据集实现交通标志实时检测

- 易语言开发的文件批量改名工具使用Ex_Dui美化界面

- 爱心援助动态网页教程:前端开发实战指南

- 复旦微电子数字电路课件4章同步时序电路详解

- Dylan Manley的编程投资组合登录页面设计介绍

- Python实现H3K4me3与H3K27ac表观遗传标记域长度分析

- 易语言开源播放器项目:简易界面与强大的音频支持

- 介绍rxtx2.2全系统环境下的Java版本使用

- ZStack-CC2530 半开源协议栈使用与安装指南

- 易语言实现的八斗平台与淘宝评论采集软件开发

- Christiano响应式网站项目设计与技术特点

- QT图形框架中QGraphicRectItem的插入与缩放技术

- 组合逻辑电路深入解析与习题教程

- Vue+ECharts实现中国地图3D展示与交互功能

- MiSTer_MAME_SCRIPTS:自动下载MAME与HBMAME脚本指南

- 前端技术精髓:构建响应式盆栽展示网站