机器学习可视化模板:100种图表解析

版权申诉

5 浏览量

更新于2024-06-29

收藏 6.25MB PPTX 举报

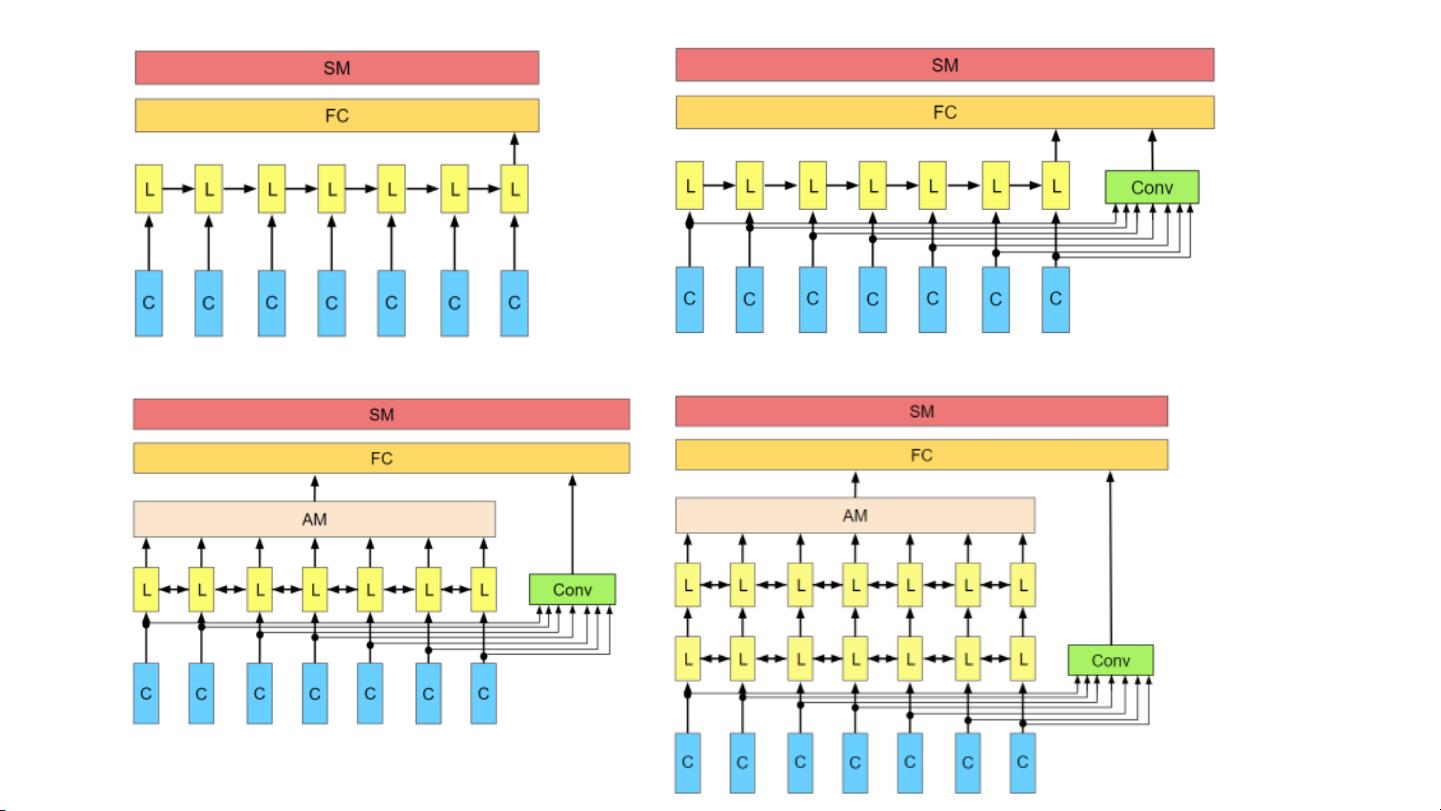

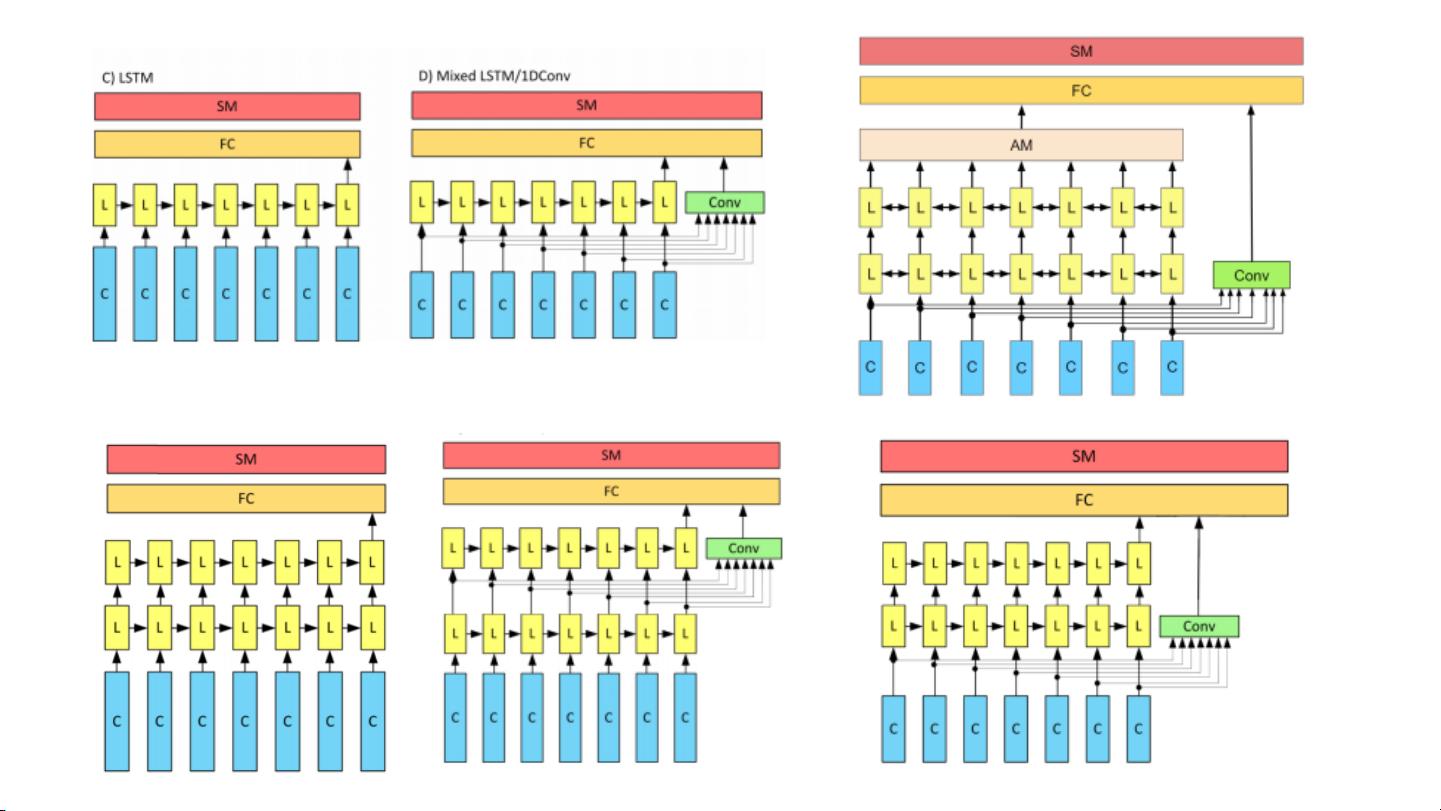

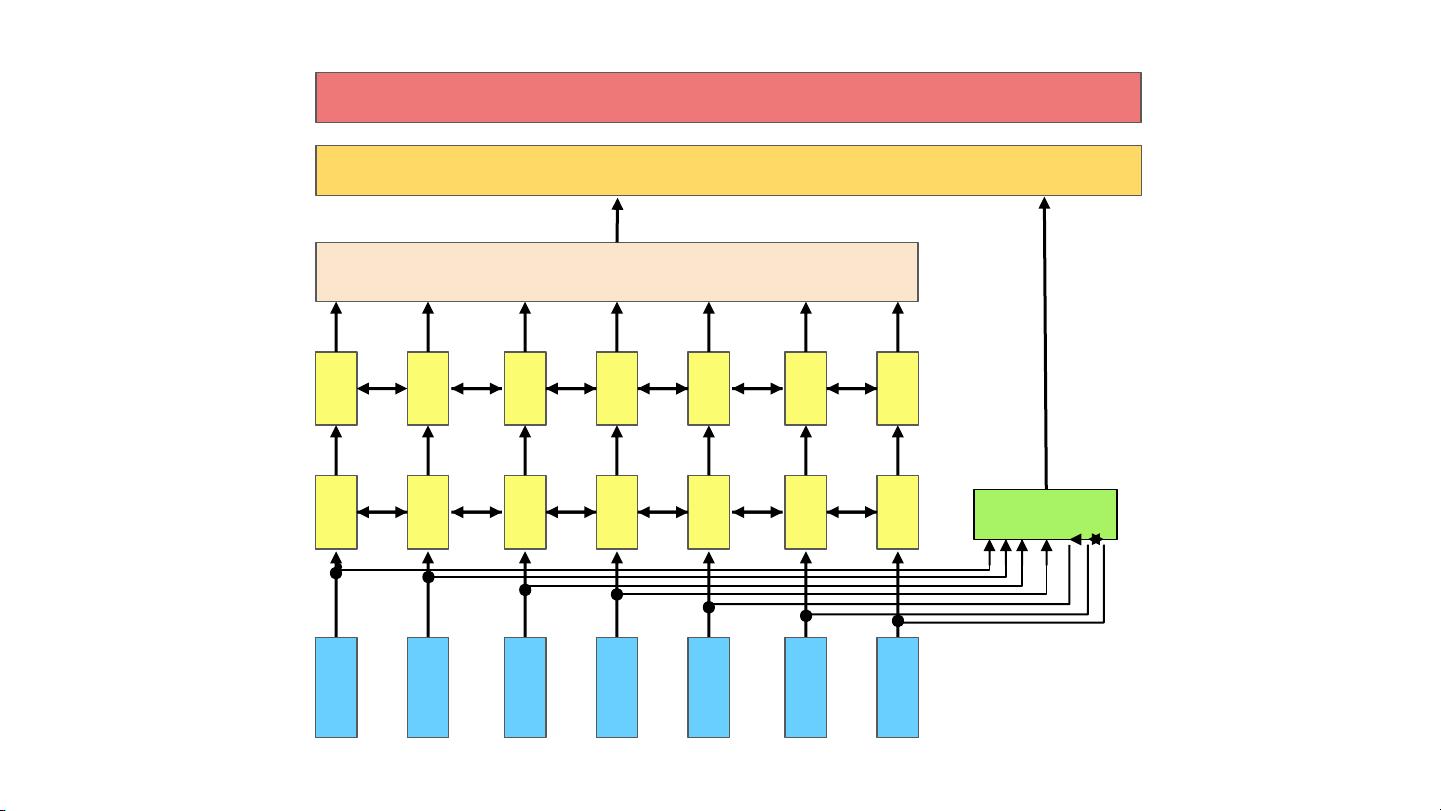

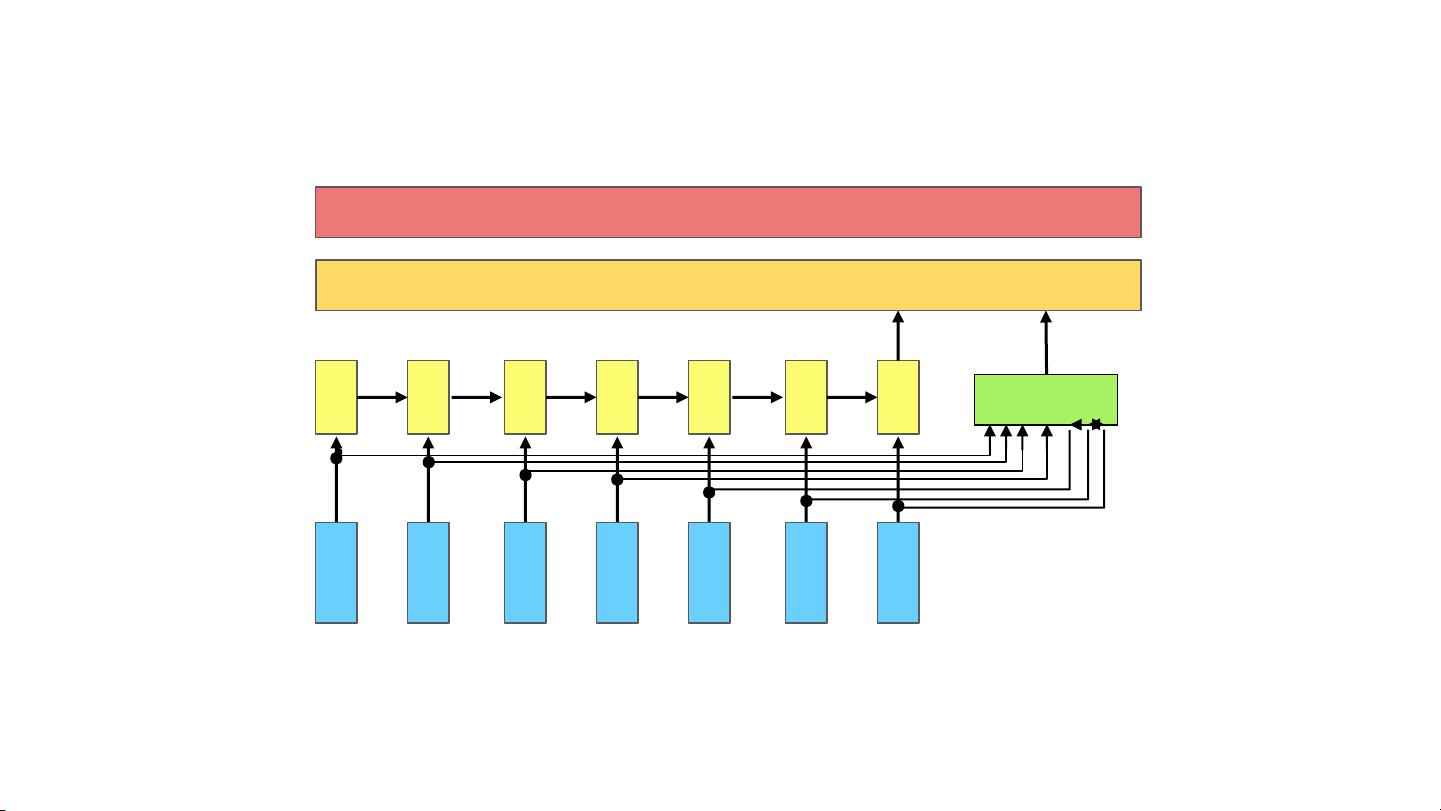

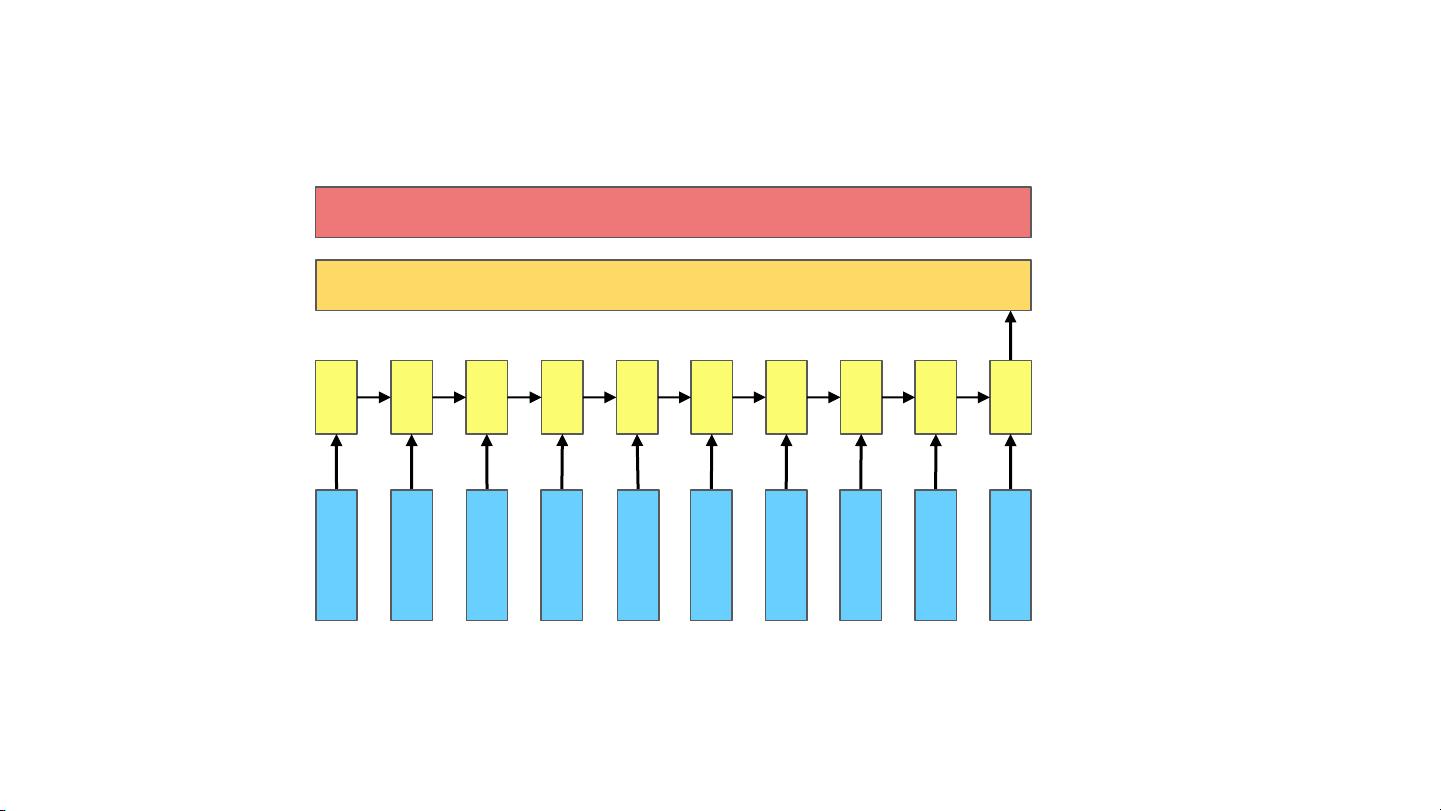

"这是一份关于机器学习的绘图模板集合,包含100张幻灯片,由Bydair.ai提供。模板涵盖了机器学习的基本组件、Softmax、卷积、锐化等概念,以及多种架构示例,如CNN、LSTM、注意力机制等。这些模板适用于讲解和设计机器学习模型的视觉表示,对学习和教学机器学习具有很高的参考价值。"

这篇资料主要涉及的机器学习知识点包括:

1. **基本组件**:这是构建任何机器学习模型的基础,可能包括输入层、隐藏层和输出层。输入层接收原始数据,隐藏层进行特征提取和转换,输出层则生成预测结果。

2. **Softmax**:Softmax函数常用于多分类问题,它将神经网络的输出转化为概率分布,使得所有类别的概率和为1,有助于模型输出更合理的分类概率。

3. **卷积(Convolution)**:在卷积神经网络(CNN)中,卷积层通过滤波器(或称为卷积核)对输入图像进行操作,提取特征。这里提到的Conv3-32、Conv3-64和Conv3-128分别表示3x3大小的卷积核,输出通道分别为32、64和128。

4. **池化(Maxpooling)**:通常跟在卷积层后面,用来减小特征图的尺寸,提高计算效率并保持模型的不变性。例如,Maxpool(2x2)表示2x2的最大池化窗口。

5. **全连接层(FC)**:在CNN的最后,全连接层将特征图展平为一维向量,并通过多个全连接层进行分类或回归。

6. **LSTM (Long Short-Term Memory)**:一种循环神经网络(RNN)的变体,擅长处理序列数据中的长期依赖问题。LSTM层通常用于自然语言处理和其他时间序列任务。

7. **混合LSTM**:混合LSTM可能指结合了不同类型的LSTM单元,如LSTM与1D卷积的组合,或者双向LSTM(BiLSTM)。

8. **注意力机制(Attention)**:注意力机制允许模型在处理序列数据时更加关注某些特定部分,提高模型的表现。这里提到了几种不同的注意力层结构,如Attention layer与CNN层的结合。

9. **CNN与LSTM的结合**:在某些场景下,CNN用于提取局部特征,而LSTM则处理序列信息,这种结合在视频分析、文本理解等领域非常常见。

10. **ReLU (Rectified Linear Unit)**:一种常用的激活函数,其非线性特性有助于模型学习更复杂的特征表示。ReLU在大部分神经网络中取代了传统的Sigmoid和Tanh激活函数,因为其在训练过程中更容易避免梯度消失问题。

这些模板为机器学习的学习者和从业者提供了丰富的视觉工具,可以帮助他们更好地理解和展示机器学习模型的结构和工作原理。通过使用这些模板,可以更直观地解释复杂的模型,提升交流效果。

2023-06-13 上传

2021-10-02 上传

2022-05-29 上传

2021-10-07 上传

2021-11-24 上传

2023-09-16 上传

安全方案

- 粉丝: 2200

- 资源: 3923

最新资源

- Angular实现MarcHayek简历展示应用教程

- Crossbow Spot最新更新 - 获取Chrome扩展新闻

- 量子管道网络优化与Python实现

- Debian系统中APT缓存维护工具的使用方法与实践

- Python模块AccessControl的Windows64位安装文件介绍

- 掌握最新*** Fisher资讯,使用Google Chrome扩展

- Ember应用程序开发流程与环境配置指南

- EZPCOpenSDK_v5.1.2_build***版本更新详情

- Postcode-Finder:利用JavaScript和Google Geocode API实现

- AWS商业交易监控器:航线行为分析与营销策略制定

- AccessControl-4.0b6压缩包详细使用教程

- Python编程实践与技巧汇总

- 使用Sikuli和Python打造颜色求解器项目

- .Net基础视频教程:掌握GDI绘图技术

- 深入理解数据结构与JavaScript实践项目

- 双子座在线裁判系统:提高编程竞赛效率