2022年NAACL对比学习教程:驱动NLP应用的新兴技术

版权申诉

196 浏览量

更新于2024-07-01

收藏 15.37MB PDF 举报

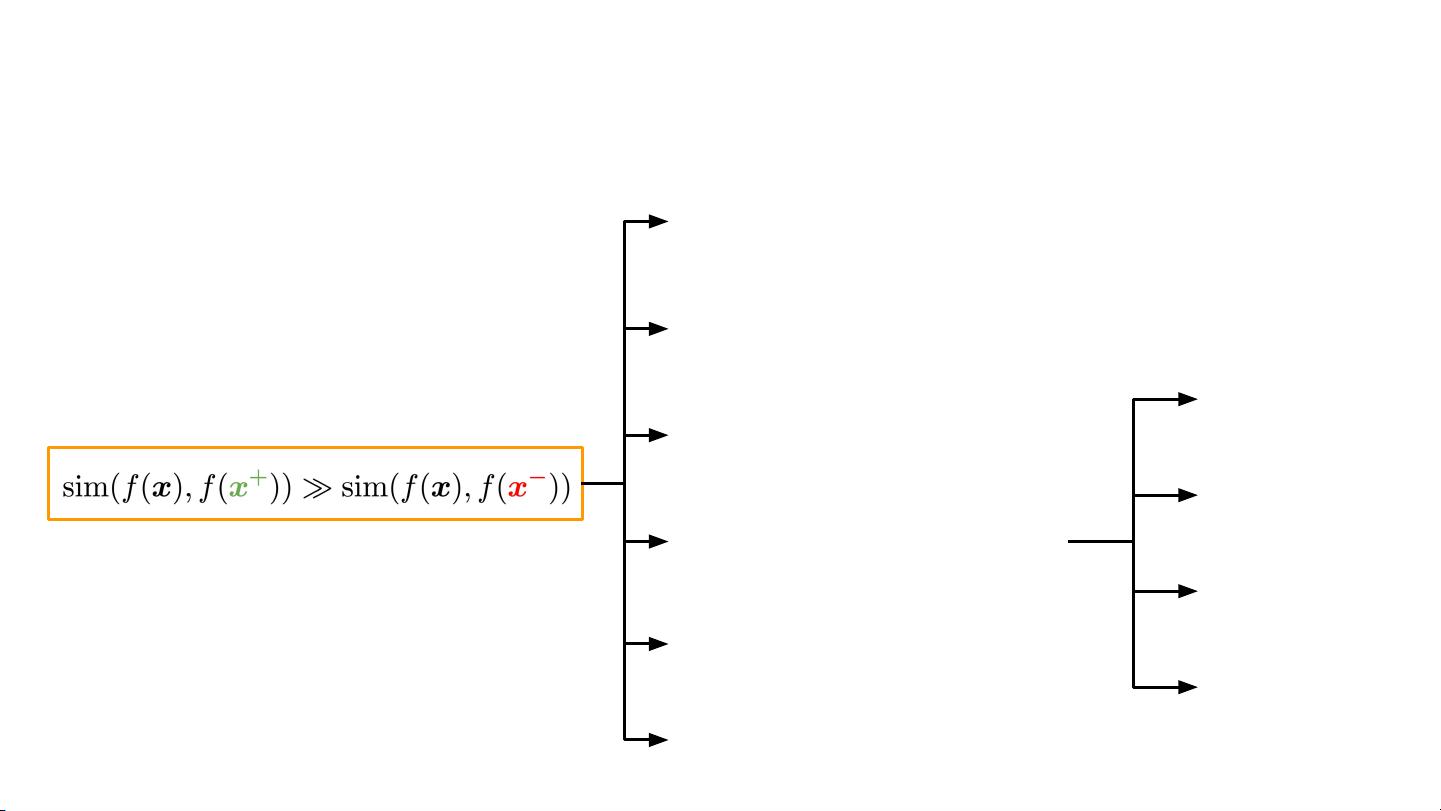

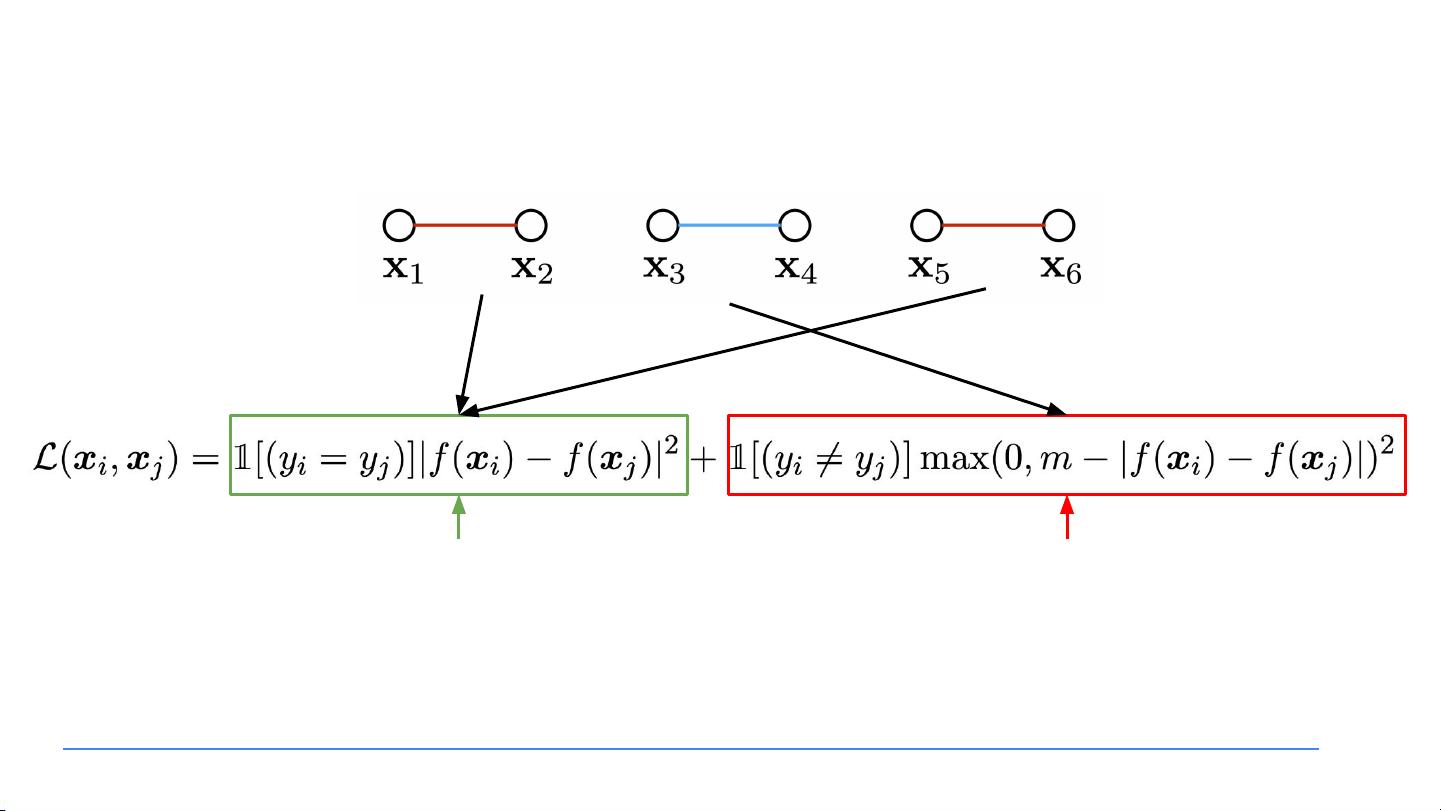

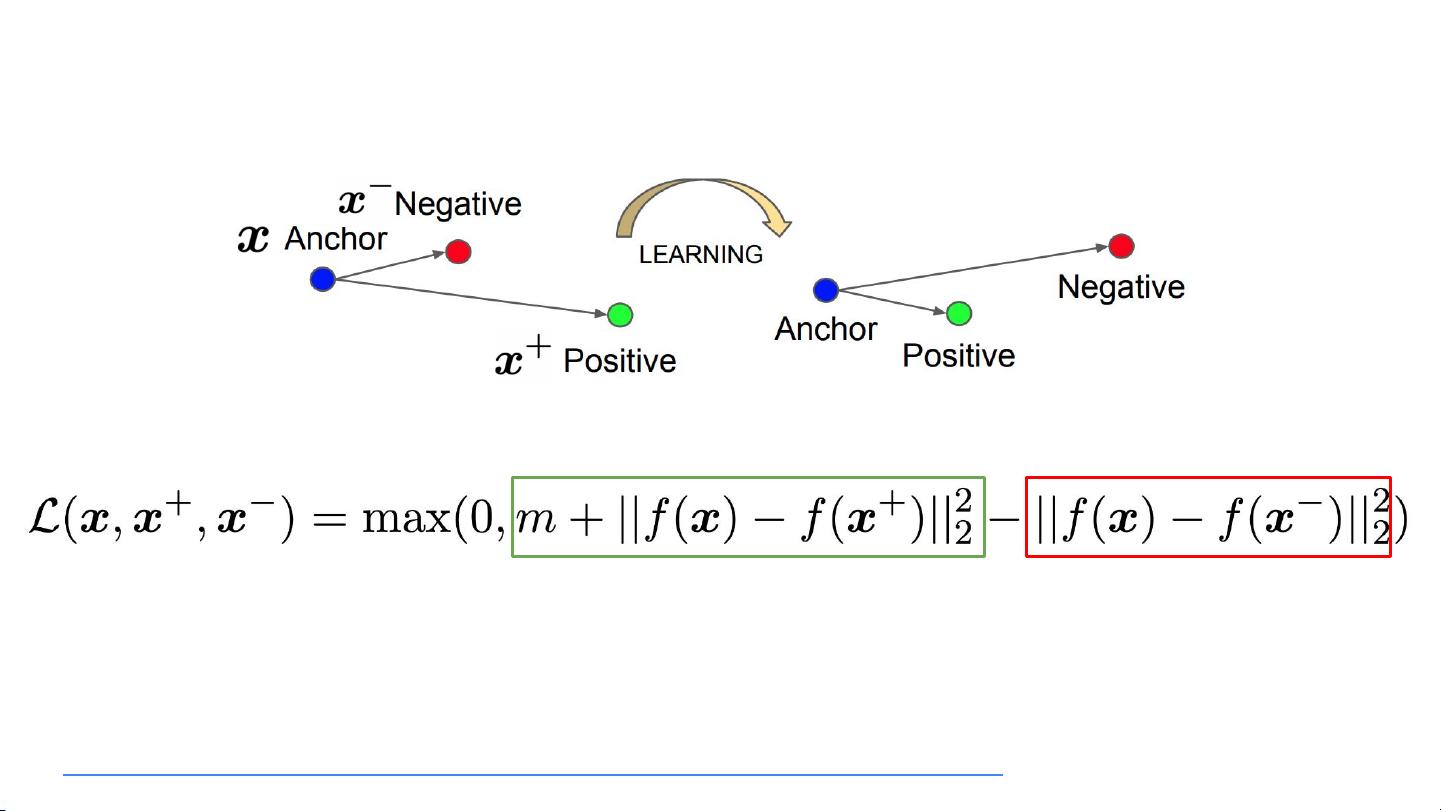

自然语言处理(NLP)的最新进展依赖于先进的表示学习技术,其中对比学习作为一种关键方法崭露头角。对比学习的目标是通过设计算法使模型能够区分相似与不相似的数据样本,从而在嵌入空间中形成结构化的表示。这种方法起源于计算机视觉领域,但近年来逐渐被应用于NLP任务,带来了显著的性能提升和多种有益特性,如任务无关的句子表示、文本生成的忠实度、少样本学习以及增强的可解释性。

在NAACL 2022年的教程《Contrastive Data and Learning for Natural Language Processing》中,Rui Zhang、Yangfeng Ji、Yue Zhang和Rebecca J. Passonneau等专家介绍了对比学习的基本原理,涵盖了诸如文本分类、问题回答、摘要生成、知识推理以及视觉与语言交互等多个NLP应用场景。该教程强调了对比学习的优势,比如在无监督或监督环境下,使用不同的损失函数来训练模型,使其既能适应特定任务,又能生成通用表示。

SimCLR(Chen等人,2020)这样的工作展示了在计算机视觉中的成功应用,它引入了一种强化相似样本聚类、远离不同样本的策略。在NLP领域,早期的努力如Smith和Eisner(2005)的工作首次提出了对比估计作为无监督学习目标,用于改进基于线性模型的训练。

教程的参与者可以利用丰富的材料(<https://contrastive-nlp-tutorial.github.io/>),包括论文列表和两个Zoom会议时间(7月10日,PDT,13:30-14:00和18:00-18:45)进行交流和提问。通过学习对比学习,研究人员可以更好地理解和开发适用于NLP的新型算法,推动该领域在未来的研究和发展。

总结来说,对比学习在NLP中扮演着日益重要的角色,它不仅提升了模型性能,还促进了领域内跨任务、可解释性和数据效率的探索。通过参与教程和深入理解其背后的理论与实践,研究人员能够更好地应对自然语言处理的挑战并推动前沿技术的进步。

2022-03-07 上传

2021-11-20 上传

2023-08-12 上传

2023-10-18 上传

2022-12-20 上传

2022-10-08 上传

2021-03-18 上传

2019-08-26 上传

2023-04-08 上传

努力+努力=幸运

- 粉丝: 3

- 资源: 136

最新资源

- 深入浅出:自定义 Grunt 任务的实践指南

- 网络物理突变工具的多点路径规划实现与分析

- multifeed: 实现多作者间的超核心共享与同步技术

- C++商品交易系统实习项目详细要求

- macOS系统Python模块whl包安装教程

- 掌握fullstackJS:构建React框架与快速开发应用

- React-Purify: 实现React组件纯净方法的工具介绍

- deck.js:构建现代HTML演示的JavaScript库

- nunn:现代C++17实现的机器学习库开源项目

- Python安装包 Acquisition-4.12-cp35-cp35m-win_amd64.whl.zip 使用说明

- Amaranthus-tuberculatus基因组分析脚本集

- Ubuntu 12.04下Realtek RTL8821AE驱动的向后移植指南

- 掌握Jest环境下的最新jsdom功能

- CAGI Toolkit:开源Asterisk PBX的AGI应用开发

- MyDropDemo: 体验QGraphicsView的拖放功能

- 远程FPGA平台上的Quartus II17.1 LCD色块闪烁现象解析