深度学习笔记:卷积神经网络详解

156 浏览量

更新于2024-08-30

收藏 135KB PDF 举报

"《动手学——卷积神经网络基础》笔记介绍了二维卷积层和二维互相关运算在处理图像数据中的应用。通过示例代码解释了如何实现二维互相关运算,并展示了二维卷积层的结构及其参数设定。"

在深度学习领域,卷积神经网络(Convolutional Neural Network, CNN)是处理图像数据的关键组件。本笔记主要关注二维卷积层,这是CNN中最基础且广泛使用的结构,特别是在图像识别、图像分类和图像生成任务中。二维卷积层的核心运算过程是二维互相关运算。

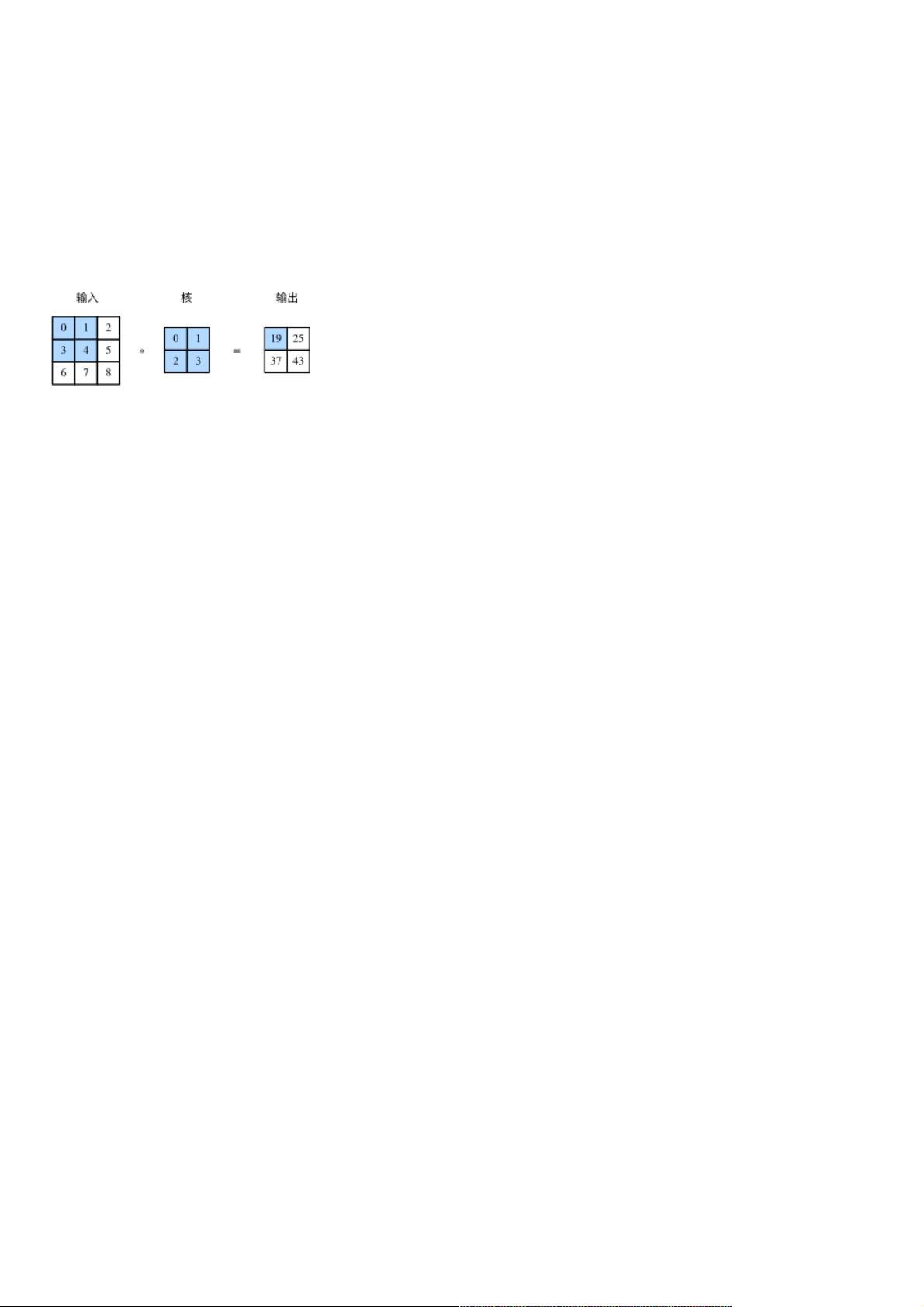

二维互相关运算是一种计算两个二维数组之间相似度的方法,通常用于卷积网络中,将卷积核应用于输入数据上。在图像处理中,输入数组代表图像的像素值,而卷积核则作为一个滤波器,捕捉特定的特征。卷积核在输入数组上滑动,每次滑动时,它与输入的局部区域(即输入子数组)进行逐元素乘法后求和,生成输出数组的对应元素。这种操作可以理解为在图像上“扫瞄”,提取特征。

例如,书中提到的corr2d函数是一个简单的二维互相关运算实现。它接受输入数组X和核数组K,返回经过卷积操作后的输出数组Y。通过实例代码,我们可以看到如何使用这个函数计算给定的输入X和核K的互相关结果。

二维卷积层则在此基础上增加了更多的功能,如学习到的卷积核权重和标量偏置。在定义二维卷积层类Conv2D时,我们初始化卷积核权重self.weight和偏置self.bias。这些参数是可训练的,意味着在反向传播过程中,它们的值会根据梯度更新,从而适应不同任务的需求。卷积层的参数还包括卷积核的大小,这里由kernel_size参数指定,通常是一个包含高度和宽度的元组。

卷积层的结构使得它可以检测局部特征并保持输入的空间结构,这在处理图像数据时具有显著优势。通过堆叠多个卷积层,CNN能够捕获不同层次的特征,从边缘和纹理到更复杂的形状和模式。此外,卷积层还有参数共享的特性,减少了模型的复杂性和所需的参数数量,提高了泛化能力。

《动手学——卷积神经网络基础》笔记深入浅出地介绍了二维卷积层的工作原理,通过实际的Python代码和示例,帮助读者理解并掌握这一关键的深度学习概念。对于想要深入理解和应用卷积神经网络的人来说,这是一个宝贵的资源。

1220 浏览量

428 浏览量

383 浏览量

2021-03-30 上传

393 浏览量

208 浏览量

989 浏览量

173 浏览量

203 浏览量

weixin_38530211

- 粉丝: 1

- 资源: 970

最新资源

- amazon-ec2-metadata-mock:模拟Amazon EC2实例元数据的工具

- changeme:默认的凭据扫描器

- failpointsjs

- SELENIUM 2 自动化测试实战 基于PYTHON语言-虫师_python自动测试_selenium2_python_自动

- Weather-Program

- 试穿

- 基于FPGA的密码锁.zip

- apk反编译工具组.zip

- Phaser

- ICASPHPlus-WCSPH_fluidflow_

- hello-scalikejdbc:ScalikeJDBC初学者的Lightbend激活器模板

- ember-cucumber:用于余烬测试的Cucumber-js适配器

- SimpleWin32Lib

- Heameelega

- 在线考试系统 数据流图 层次图

- metta:进行对抗模拟的信息安全准备工具