美团DB数据同步到Hive:实时CDC与离线处理实践

84 浏览量

更新于2024-08-31

收藏 501KB PDF 举报

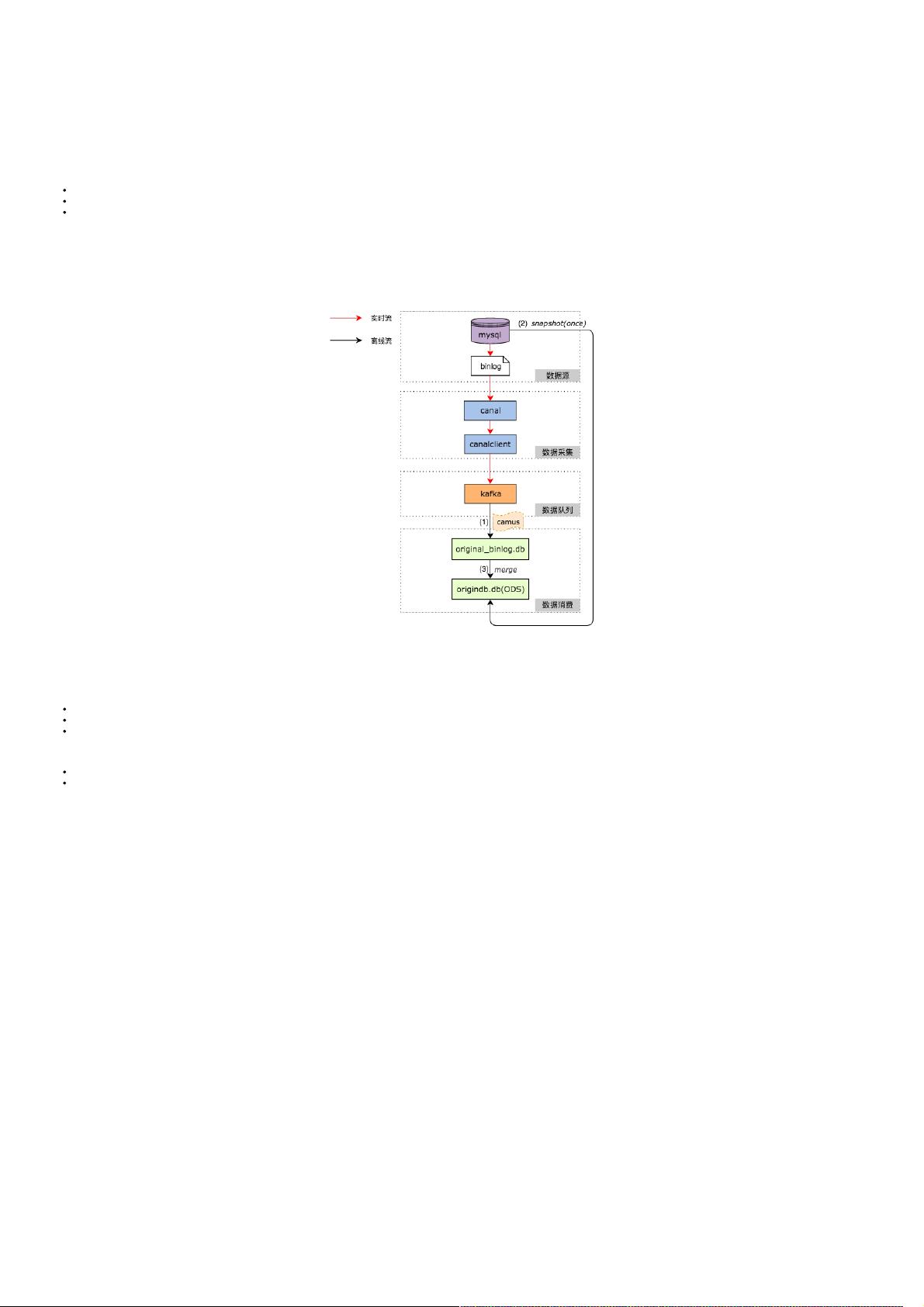

美团DB数据同步到数据仓库的架构与实践主要探讨的是在互联网企业中,特别是美团这样的业务环境中,如何高效地将业务数据库(如MySQL)的数据同步至数据仓库(如Hive)。传统的批量取数方式,即通过直接从MySQL查询数据,然后保存到本地文件并加载到Hive,虽然操作简单,但在业务规模扩大后面临性能瓶颈和对MySQL服务器的影响问题,包括可能导致慢查询和不支持实时更新、删除操作。

为了解决这些问题,美团采用了变化数据捕获(CDC)技术结合离线处理的方法。具体来说,他们利用MySQL的二进制日志(Binlog),通过阿里巴巴开源的Canal项目实时采集MySQL的Binlog事件,Canal负责从MySQL服务器拉取数据并解析,产生的数据流被暂存到Kafka消息队列中,供后续处理系统消费。

离线处理部分,通过LinkedIn的InnoDB Binlog Parser或者类似的工具,将接收到的Binlog事件转换成Hive友好的数据结构,并在Hive上创建一张虚拟表。这个过程通常涉及以下步骤:

1. **实时Binlog采集**:通过Canal或类似工具,持续监听MySQL的Binlog,实时捕获所有数据变更,包括INSERT、UPDATE、DELETE等操作。

2. **数据传输**:采集到的Binlog事件被发送到Kafka,作为一种可靠且高吞吐量的消息队列,保证数据的实时性和可靠性。

3. **离线处理**:从Kafka消费者接收Binlog事件,解析和应用这些变更到Hive中的虚拟表。这可能涉及到数据清洗、转换和聚合,以满足数据仓库的需求。

4. **数据一致性保障**:由于Hive不支持实时更新,通过离线处理确保数据在Hive中的状态始终反映MySQL的最新状态,即使在MySQL发生变更时也能保持一致。

5. **监控与优化**:为了确保整个过程的性能和稳定性,需要实施有效的监控,包括Binlog采集延迟、Kafka队列深度、Hive处理速度等,并根据实际情况进行调整和优化。

这种 CDC + Merge 的架构设计不仅提高了数据同步的效率,还降低了对业务系统的影响,为美团的数据仓库提供了强大且灵活的数据同步能力,是现代大数据场景下常见且实用的数据同步策略。

2021-12-11 上传

2018-02-12 上传

点击了解资源详情

2022-08-03 上传

点击了解资源详情

2024-11-05 上传

2024-11-05 上传

2024-11-05 上传

2024-11-05 上传

2024-11-05 上传

weixin_38694800

- 粉丝: 4

- 资源: 1021

最新资源

- 探索AVL树算法:以Faculdade Senac Porto Alegre实践为例

- 小学语文教学新工具:创新黑板设计解析

- Minecraft服务器管理新插件ServerForms发布

- MATLAB基因网络模型代码实现及开源分享

- 全方位技术项目源码合集:***报名系统

- Phalcon框架实战案例分析

- MATLAB与Python结合实现短期电力负荷预测的DAT300项目解析

- 市场营销教学专用查询装置设计方案

- 随身WiFi高通210 MS8909设备的Root引导文件破解攻略

- 实现服务器端级联:modella与leveldb适配器的应用

- Oracle Linux安装必备依赖包清单与步骤

- Shyer项目:寻找喜欢的聊天伙伴

- MEAN堆栈入门项目: postings-app

- 在线WPS办公功能全接触及应用示例

- 新型带储订盒订书机设计文档

- VB多媒体教学演示系统源代码及技术项目资源大全