RNN详解:时间记忆的神经网络及其在机器学习中的应用

需积分: 6 78 浏览量

更新于2024-07-10

收藏 2.94MB PPTX 举报

循环神经网络(RNN)是一种特别设计的神经网络结构,用于处理序列数据,其灵感来源于人类的记忆机制。相比于传统的BP算法和卷积神经网络(CNN),RNN的特点在于它们能够捕捉输入序列中的时间依赖性,不仅考虑当前时刻的输入,而且还能够通过循环连接保留对先前信息的记忆。这种特性使得RNN在处理诸如自然语言处理(NLP)、语音识别、机器翻译、音乐推荐等需要理解时间序列信息的任务中表现出色。

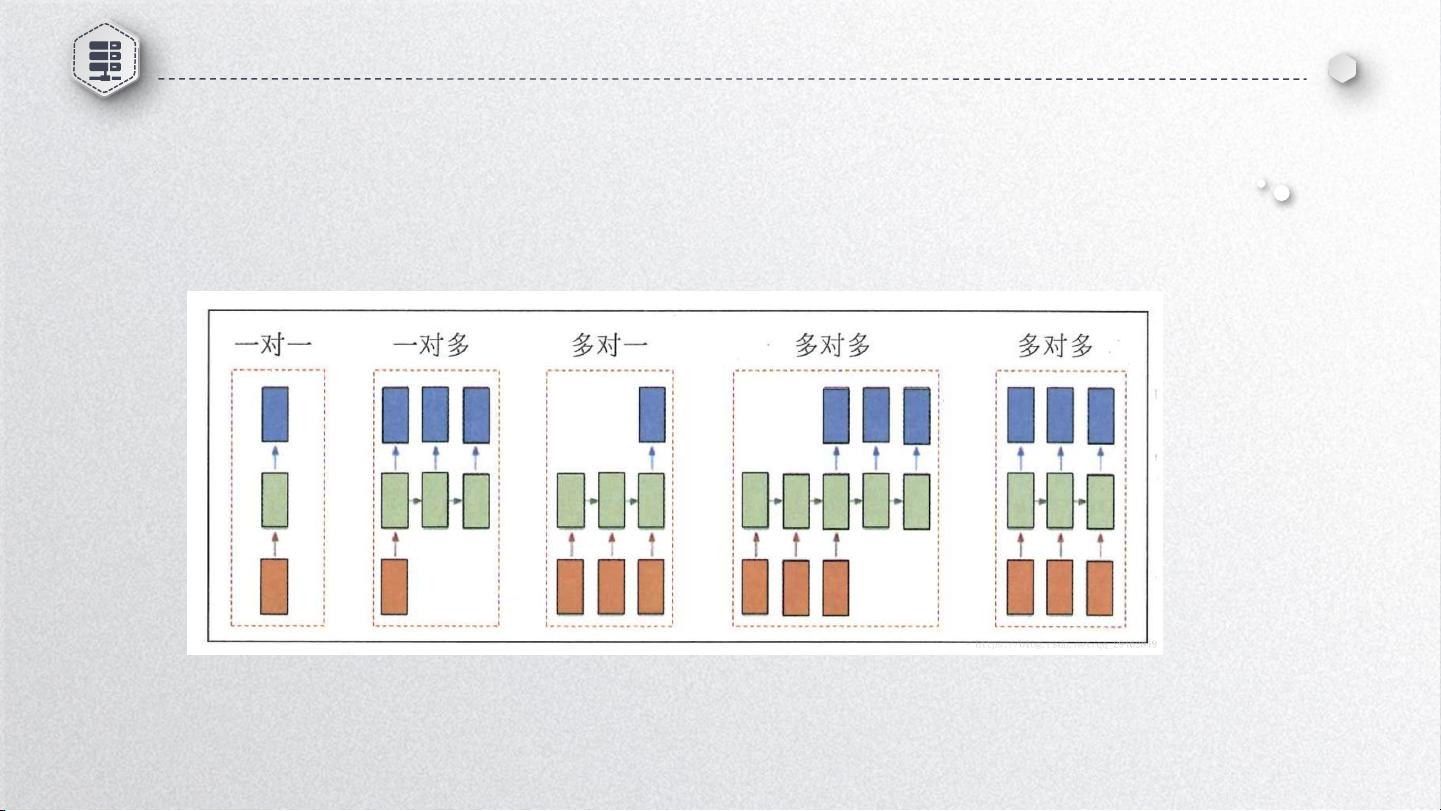

在RNN的模型结构中,主要包括输入层、隐藏层和输出层。输入层接收序列中的每一个元素,隐藏层是关键组件,它通过自循环连接将前一时刻的隐藏状态传递到当前时刻,形成一种“记忆”单元。这个隐藏层不仅处理当前输入,还融合了过去的信息,这使得RNN能够理解和建模序列中的长期依赖关系。RNN的不同连接方式,如一对一、一对多、多对一和多对多,适应了不同的应用场景。例如,一对一连接适用于机器翻译,而多对多连接则常用于视频分类和帧级标注。

在实际应用中,RNN被广泛用于文本生成(如聊天机器人)、情感分析、文本摘要和问答系统;语音识别任务中,RNN可以捕获说话者的语音特征并转化为文字;图像描述生成则是结合视觉信息生成相应的文本描述;此外,音乐推荐和个性化商品推荐等领域也利用RNN来理解用户的历史行为和偏好。

RNN的训练通常采用反向传播(Backpropagation Through Time, BPTT)算法,这是一种针对序列数据的特殊版本,通过分段梯度计算来处理隐藏层的状态更新,解决了传统BP算法在处理长序列时的梯度消失或爆炸问题。尽管RNN在许多场景下表现出强大的性能,但它的训练过程可能会比较复杂,特别是当序列长度很长时,需要适当的技巧如长短时记忆网络(LSTM)或门控循环单元(GRU)来改善长期依赖的学习效率。

循环神经网络是机器学习领域中不可或缺的一部分,它们通过独特的循环结构和记忆机制,使得模型能够在处理时间序列数据时展现出超越传统方法的优势。随着技术的发展,RNN及其变体将持续在人工智能领域发挥核心作用,推动着众多应用领域的进步。

2024-05-15 上传

2021-09-19 上传

2019-11-05 上传

2023-04-23 上传

2024-04-19 上传

2024-04-19 上传

2024-04-19 上传

于小野

- 粉丝: 59

- 资源: 13

最新资源

- 集成测试工作流程指南.pdf

- 《Core Java-VOLUME I-FUNDAMENTALS EIGHTH EDITION》

- Ospf协议讲解及配置

- java的JNI跨平台技术

- 关于SQL注入的资料-2

- 卫星测高--GPS测高的原理

- 如何使用C语言来编写 MSP430的高质量代码

- linux下建立自动编译环境.pdf

- 8259a单片机程序

- CImg库参考手册.pdf

- 网络工程师考试2008年下半年下午试题解析

- 使用+Visual+Studio+[1].NET+创建+BREW_+应用程序.pdf

- JAVA面试题解惑系列

- Struts In Action PDF 完整中文版

- 武汉大学选修课Matlab作业

- PICC编程简介PIC单片机C语言编程入门