非流深度框架:动态场景下HDR成像的革命性解决方案

PDF格式 | 2.34MB |

更新于2024-06-19

| 94 浏览量 | 举报

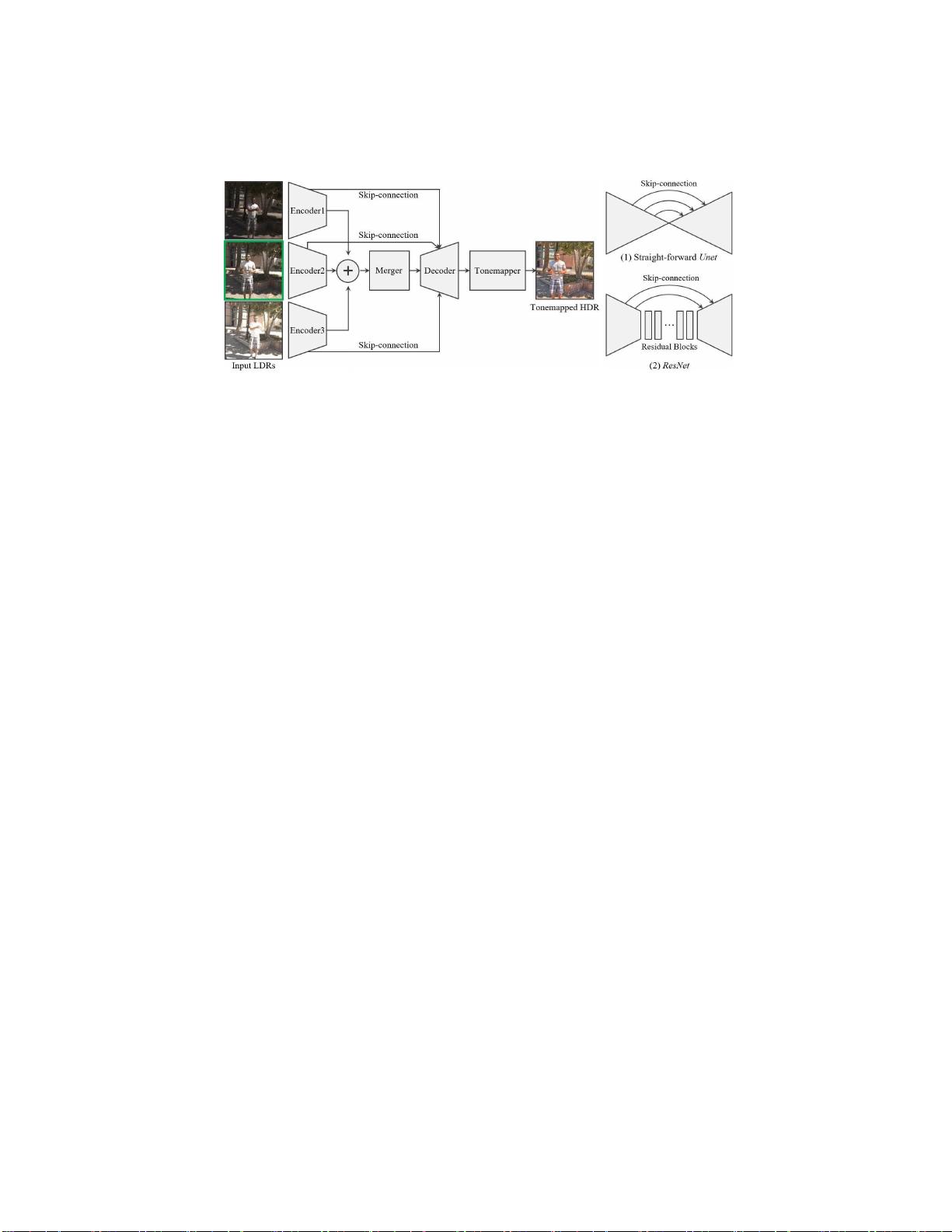

本文主要探讨了"非流深度框架实现动态场景下高动态范围成像"这一主题。作者团队,由吴尚哲、徐家瑞、戴玉荣和邓志强等人组成,来自香港科技大学、腾讯优图和牛津大学,提出了一种创新的深度学习解决方案,旨在处理具有大规模前景运动的动态场景中的高动态范围(HDR)成像问题。传统方法在深度HDR成像中依赖于光流对齐,但这种方法在存在遮挡和大运动时易出错。作者将HDR成像问题重新定义为无需光流的图像翻译问题,设计了一个简单的翻译网络,能够自动处理完全遮挡、饱和和曝光不足的情况,从而生成合理的HDR细节,这在传统优化方法中难以实现。

与基于光流的传统方法形成鲜明对比,新框架能够有效减少颜色伪影和几何失真,即使在没有辐射校准的图像输入下也能展现出良好的鲁棒性。作者团队通过广泛的定性和定量比较,证明了他们的方法在性能上显著优于现有的最先进的HDR合成技术,特别在处理复杂动态场景时,能提供更高质量的HDR图像。

这项研究对于移动摄影和实时场景捕捉有着重要意义,因为它提供了更加便捷和准确的HDR成像解决方案,使得普通用户能够轻松捕捉并重现高动态范围的视觉效果,而不必依赖专业设备。通过计算摄影技术,这个非流深度框架为HDR图像的生成开辟了新的可能性,展示了深度学习在图像处理领域的强大潜力。

相关推荐

344 浏览量

444 浏览量

点击了解资源详情

769 浏览量

点击了解资源详情

256 浏览量

点击了解资源详情

376 浏览量

cpongm

- 粉丝: 6

最新资源

- libuv在VC2015++中的应用实例解析

- Linux CRT绿色版解压工具发布

- Wow.js动画插件:配合animate.css的页面元素动画效果

- 利用百度地图开发工具轻松获取SHA1签名

- 个性化屏保制作与应用教程

- CPU信息MD5多重加密注册机实现方法

- CsipSimple-master:轻松实现Android语音电话功能

- VC++6.0环境下实现哈夫曼编码及译码操作

- 跨平台人脸检测与识别实现:HTML与Python结合教程

- 基于JSP+Struts+Hibernate+Oracle的在线考试系统设计与实现

- QT开发环境搭建全攻略与工具下载指南

- Java操作Excel工具类库jxl-2.6.jar使用详解

- 苹果电脑与手机PPT背景图片下载

- 期末大作业参考:精选JSP项目源码分享

- SenchaCmd 4.0.5.87 Windows版本发布

- 基于Android Studio的GridLayout计算机界面实现