Monash FIT5217 自然语言处理期末复习:n-gram,Markov假设与OOV解析

"Monash大学FIT5217自然语言处理课程的期末复习材料,包含所有课后习题解答及每周课程重点知识点总结,适用于期末考试复习。"

在自然语言处理(NLP)领域,理解和掌握n-gram模型是至关重要的。n-gram是一种统计语言模型,用于预测序列中下一个元素的概率,常被用来模拟人类语言的生成过程。在描述中提到的题目中,第一部分讨论了n-gram模型的参数估计:

1. n-gram模型的参数数量与词汇表大小有关。例如,在一个拥有1000个单词的词汇表中:

- 对于二元模型(bigram, n=2),我们需要估计999对连续单词的概率(𝑃(𝑤𝑖|𝑤{𝑖−1})),即1000^2 - 1个参数。

- 对于三元模型(trigram, n=3),需要估计1000^3 - 1个参数(𝑃(𝑤𝑖|𝑤{𝑖−1,𝑖−2}))。

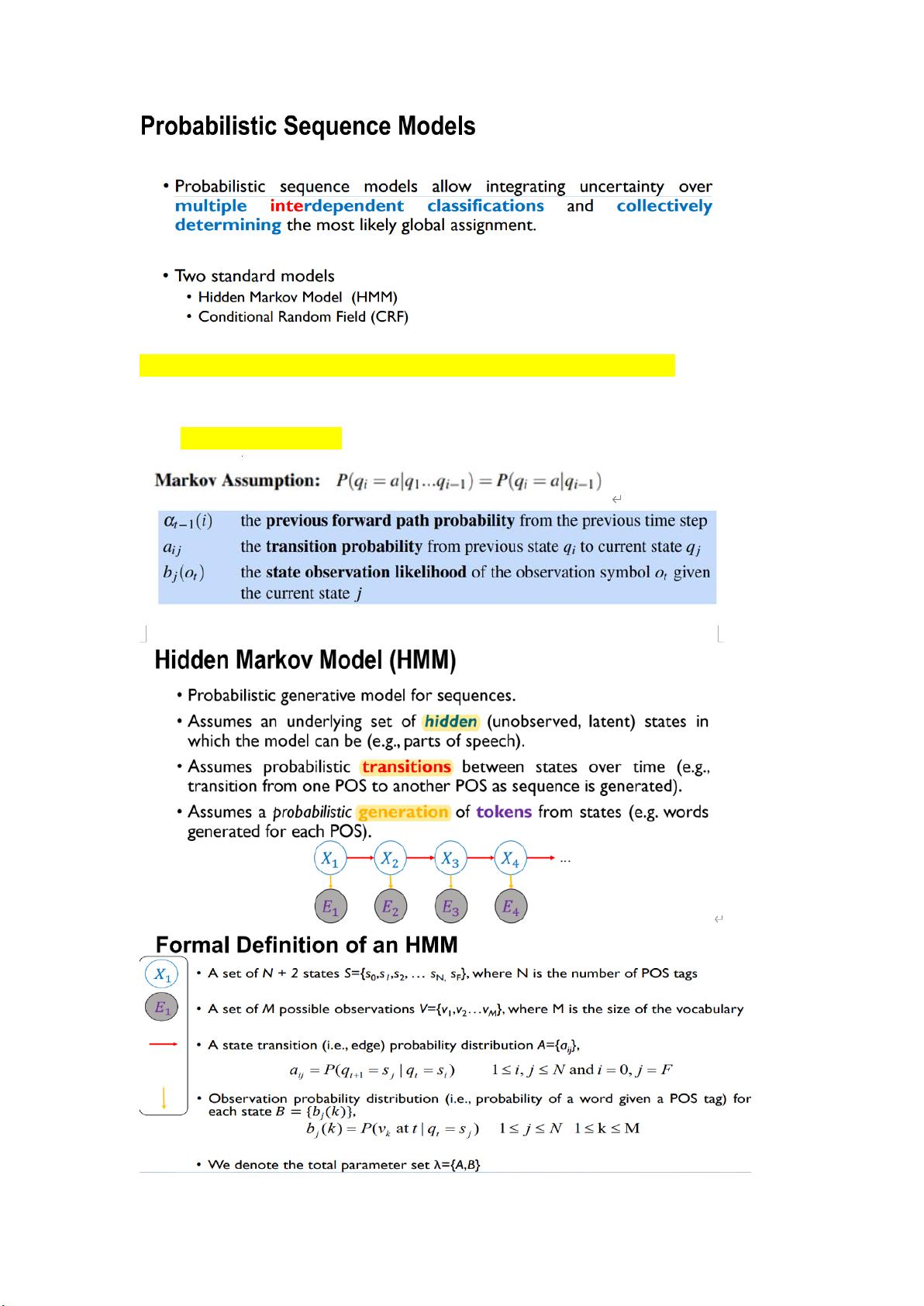

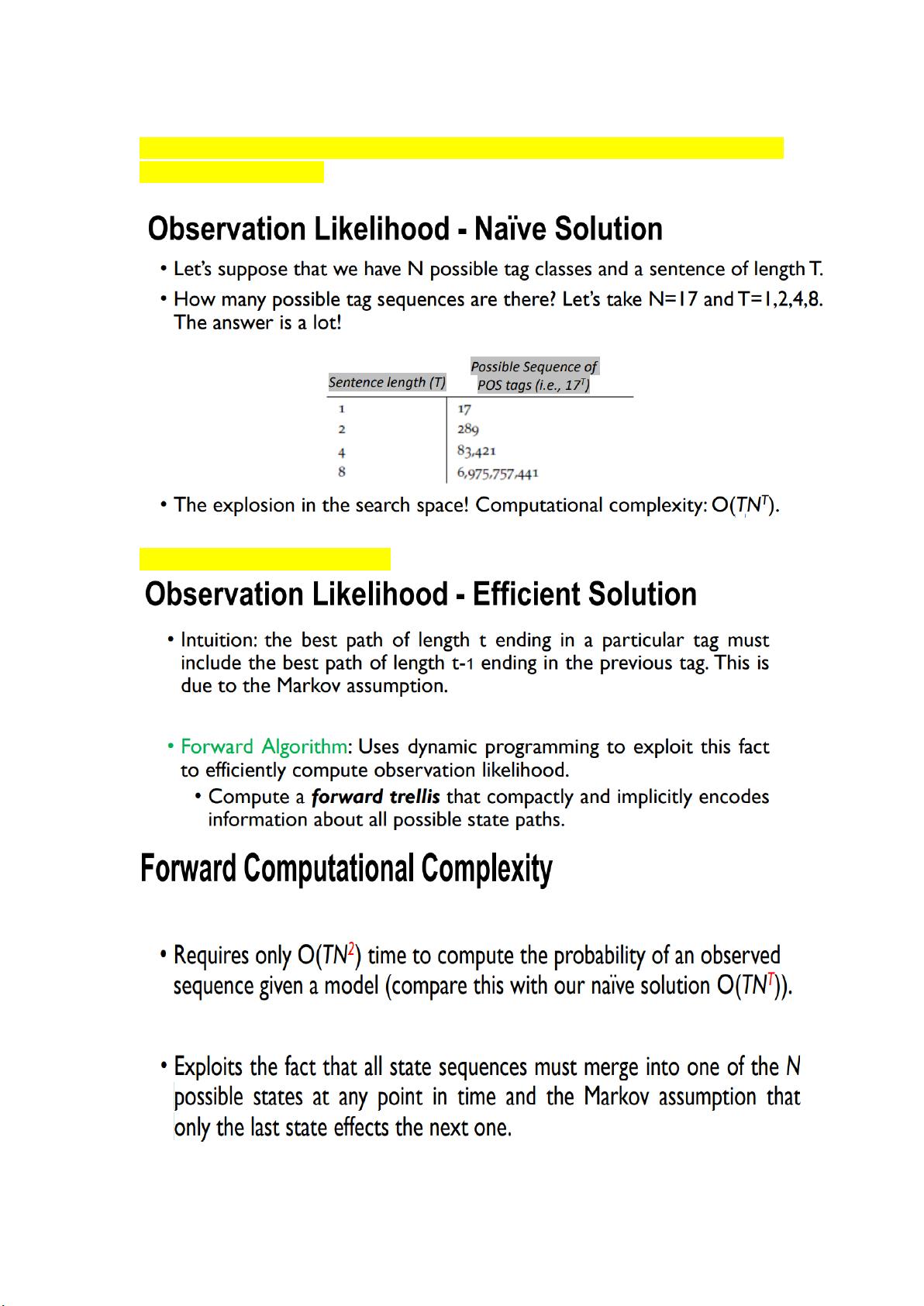

2. 马尔可夫假设是n-gram模型的基础,它假设当前单词出现的概率只依赖于其前n个单词。链式规则是概率计算的基础,而马尔可夫近似简化了这一计算,只考虑最近的n个单词。

3. 在一个小语料库中,可以列出所有的n-gram(例如,当n=2时为bigrams)及其最大似然估计(MLE)概率。然后,基于这些概率,可以计算出给定句子的概率。

4. add-1平滑是处理概率为零的问题的一种方法,它在每个计数上加1,以避免在未观察到的n-gram上得到概率为零的情况。这样会使得计算更稳定,但可能导致概率分布的总体概率略高于1。

5. OOV(词汇表外)问题指的是在训练数据中未出现的单词,这对任何语言都是挑战。对于英语,由于其广泛使用和丰富的资源,OOV问题可能相对较轻。然而,对于像芬兰语这样的小众语言,由于词汇表可能更小且资源有限,遇到OOV的情况可能会更严重,因为新词或外来词出现的概率更高。

自然语言处理还包括其他重要概念,如词性标注、句法分析、情感分析、机器翻译等。此外,还有更高级的模型,如条件随机场(CRFs)、隐马尔可夫模型(HMMs)、以及近年来流行的深度学习方法,如循环神经网络(RNNs)、长短时记忆网络(LSTMs)和Transformer模型等。这些模型和方法在处理语言任务时,能更有效地捕捉上下文信息和语言结构,从而提高预测性能。

2023-10-19 上传

2024-10-26 上传

2024-10-26 上传

2024-10-27 上传

2021-05-02 上传

2021-05-10 上传

2022-10-05 上传

金州饿霸

- 粉丝: 719

- 资源: 7

最新资源

- IEEE 14总线系统Simulink模型开发指南与案例研究

- STLinkV2.J16.S4固件更新与应用指南

- Java并发处理的实用示例分析

- Linux下简化部署与日志查看的Shell脚本工具

- Maven增量编译技术详解及应用示例

- MyEclipse 2021.5.24a最新版本发布

- Indore探索前端代码库使用指南与开发环境搭建

- 电子技术基础数字部分PPT课件第六版康华光

- MySQL 8.0.25版本可视化安装包详细介绍

- 易语言实现主流搜索引擎快速集成

- 使用asyncio-sse包装器实现服务器事件推送简易指南

- Java高级开发工程师面试要点总结

- R语言项目ClearningData-Proj1的数据处理

- VFP成本费用计算系统源码及论文全面解析

- Qt5与C++打造书籍管理系统教程

- React 应用入门:开发、测试及生产部署教程