词嵌入技术:从Word2Vec到Glove

需积分: 0 74 浏览量

更新于2024-08-05

收藏 9.59MB PDF 举报

"本文介绍了词嵌入技术,特别是Word2Vec和GloVe两种方法,以及相关的相似性计算和学习过程。"

在自然语言处理中,词嵌入(Word Embeddings)是一种将词汇转换为实数值向量的方法,使得词汇间的语义关系能够被数学化地表达。传统的词表示方法如独热编码(One-hot Encoding)虽然可以唯一标识每个词,但忽略了词与词之间的关联性。词嵌入则通过学习词的分布式表示,将每个词映射到一个低维向量空间,使得语义相近的词在空间中距离较近。

其中,Word2Vec是一种广泛应用的词嵌入模型,由两种主要的训练方法组成:CBOW(Continuous Bag of Words)和Skip-gram。CBOW模型通过预测上下文词来学习词的嵌入,而Skip-gram则是反过来,预测目标词给定其上下文。在Skip-gram中,有几种上下文的选择策略,例如取目标词前面或后面的4个词,或者只使用最后一个词,或者采用N-gram模型选择更广泛的上下文。

GloVe(Global Vectors for Word Representation)是另一种词嵌入技术,它结合了统计共现矩阵的线性代数特性与神经网络的学习能力。GloVe的目标是最大化词汇共现矩阵的对数似然,从而捕捉词与词之间的全局统计信息。相比于Word2Vec,GloVe更注重词汇的全局共现统计,适合大规模语料库的训练。

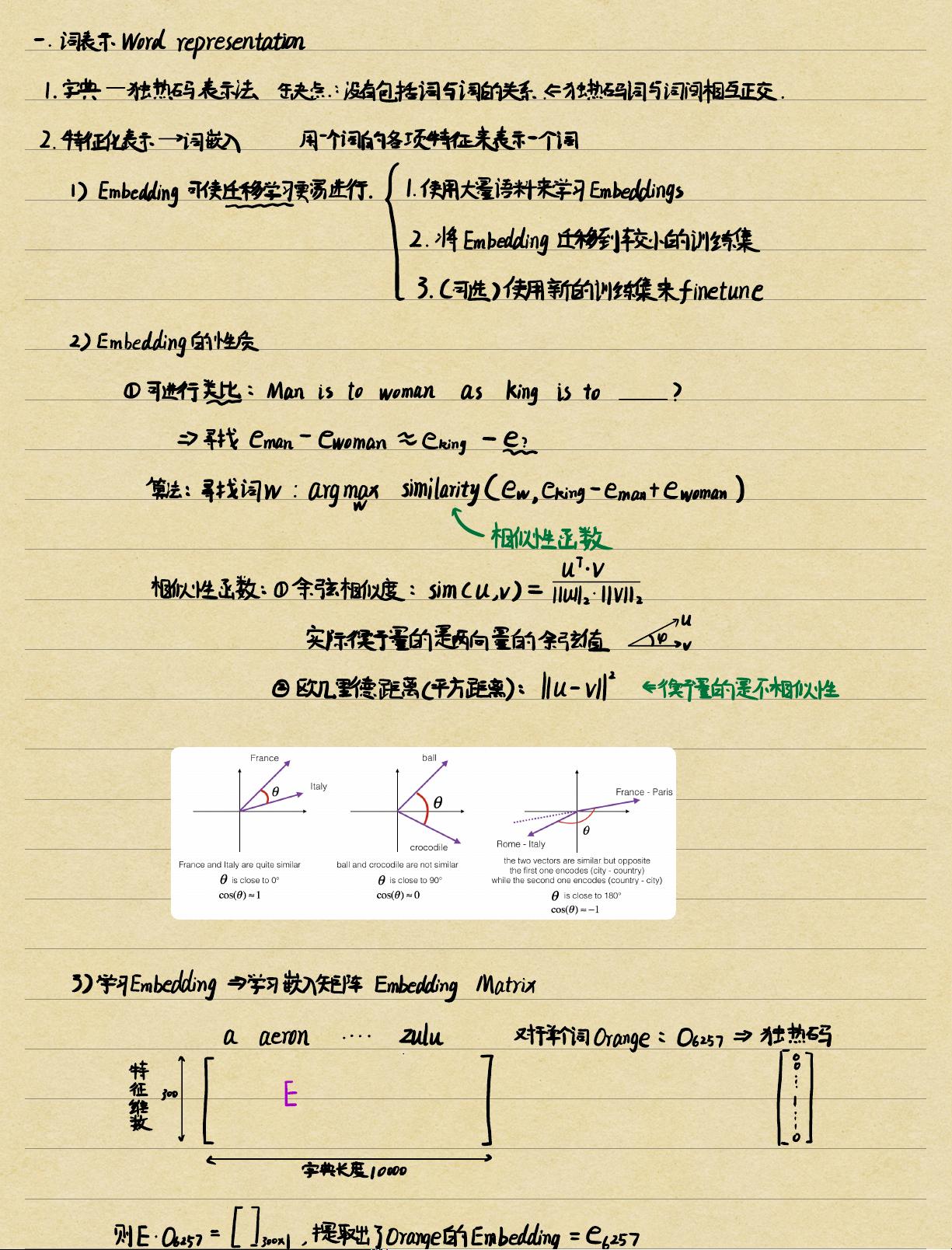

在评估词嵌入的效果时,常常会使用相似性函数,比如余弦相似度和欧氏距离。余弦相似度衡量两个向量在高维空间中的夹角,而欧氏距离则计算它们的直线距离。这些相似性度量常用于寻找词与词之间的语义关系,例如找出“man”到“king”的关系与“woman”到“queen”的关系。

学习词嵌入的过程通常涉及构建嵌入矩阵(Embedding Matrix),矩阵的每一列代表一个词的向量表示。例如,如果字典长度为10000,而“Orange”的索引是6257,那么矩阵的第6257列就是“Orange”的词嵌入向量。训练过程中,可以通过梯度下降等优化方法更新这个矩阵,以提升预测输出词的能力。

在实际应用中,预训练的词嵌入可以迁移到较小的数据集上进行微调(fine-tuning),以适应特定任务的需求。同时,词嵌入的性质使其能够捕获词义的细微差异,这对于自然语言理解和生成等任务非常有价值。

2022-08-03 上传

2021-04-16 上传

2021-02-20 上传

185 浏览量

152 浏览量

2021-05-04 上传

点击了解资源详情

154 浏览量

焦虑肇事者

- 粉丝: 1154

最新资源

- 隐私数据清洗工具Java代码实践教程

- UML与.NET设计模式详细教程

- 多技术领域综合企业官网开发源代码包及使用指南

- C++实现简易HTTP服务端及文件处理

- 深入解析iOS TextKit图文混排技术

- Android设备间Wifi文件传输功能的实现

- ExcellenceSoft热键工具:自定义Windows快捷操作

- Ubuntu上通过脚本安装Deezer Desktop非官方指南

- CAD2007安装教程与工具包下载指南

- 如何利用Box平台和API实现代码段示例

- 揭秘SSH项目源码:实用性强,助力开发高效

- ECSHOP仿68ecshop模板开发中心:适用于2.7.3版本

- VS2012自定义图标教程与技巧

- Android新库Quiet:利用扬声器实现数据传递

- Delphi实现HTTP断点续传下载技术源码解析

- 实时情绪分析助力品牌提升与趋势追踪:交互式Web应用程序