深度学习实践:LSTM详解与从零实现

132 浏览量

更新于2024-08-30

收藏 952KB PDF 举报

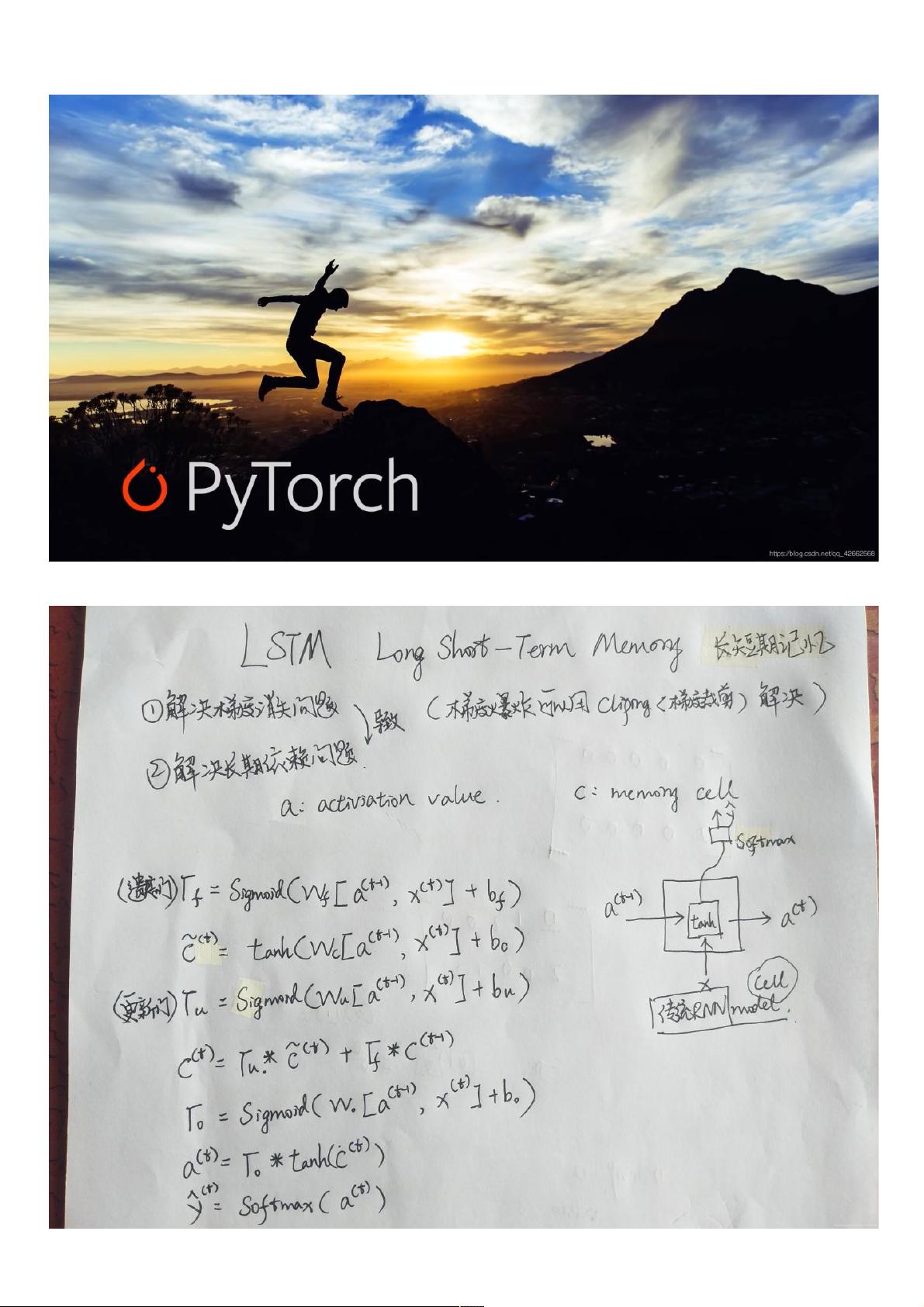

在深度学习笔记的第6部分,我们深入探讨了循环神经网络(Recurrent Neural Networks, RNNs)中的一个关键组件:长短期记忆(Long Short-Term Memory, LSTM)。这部分内容主要分为两个部分:理论知识理解和从零开始实现。

**6.1 长短期记忆(LSTM)**

**6.1.1 理论知识理解**

LSTM是一种特殊的RNN,设计用于解决传统RNN在处理长期依赖性问题时的梯度消失或爆炸问题。LSTM通过引入三个门控机制(输入门、遗忘门和输出门)以及一个称为“候选记忆细胞”的隐藏状态,有效地控制了信息的流动。这些门控单元允许网络根据当前输入和先前状态决定哪些信息应被保留、遗忘或输出。输入门(Input Gate)控制新信息的添加,遗忘门(Forget Gate)控制旧信息的丢弃,输出门(Output Gate)决定输出哪些经过处理的信息,而候选记忆细胞(Candidate Cell State)则负责存储和更新长期记忆。

**6.1.2 LSTM的从零开始实现**

在这个部分,作者使用PyTorch库进行代码示例。首先,导入了必要的库,如`numpy`、`torch`、`torch.nn`、`torch.nn.functional`等,并确保在GPU上运行,如果可用的话。接下来,加载数据集并定义了模型参数,包括输入大小(词汇表大小)、隐藏层神经元数量、以及输出层神经元数量。函数`get_params`用于创建随机初始化的模型权重,如输入门、遗忘门、输出门、候选记忆细胞的权重矩阵和偏置项。

模型的核心组成部分包括:

- 输入门参数(W_xi, W_hi, b_i)

- 遗忘门参数(W_xf, W_hf, b_f)

- 输出门参数(W_xo, W_ho, b_o)

- 候选记忆细胞参数(W_xc, W_hc, b_c)

- 输出层权重(W_hq)和偏置项(b_q)

通过这些门和细胞的状态转换,LSTM网络能够在处理文本序列等时间序列数据时捕捉到长期依赖关系,使得深度学习在诸如机器翻译、语音识别和自然语言处理等领域取得了显著进步。

总结来说,这一节重点讲解了LSTM的基本原理和如何在实践中构建一个简单的LSTM模型,通过实例展示了模型结构的组成以及其在处理序列数据时的优势。这对于理解和应用深度学习在实际问题中的表现至关重要。通过动手实践,读者可以更深入地掌握LSTM的工作机制及其在深度学习框架中的应用。

2024-12-23 上传

487 浏览量

254 浏览量

280 浏览量

494 浏览量

494 浏览量

935 浏览量

weixin_38733676

- 粉丝: 5

最新资源

- 久度免费文件代存系统 v1.0:全技术领域源码分享

- 深入解析caseyjpaul.github.io的HTML结构

- HTML5视频播放器的实现与应用

- SSD7练习9完整答案解析

- 迅捷PDF完美转PPT技术:深度识别PDF内容

- 批量截取子网页工具:Python源码分享与使用指南

- Kotlin4You: 探索设计模式与架构概念

- 古典风格茶园茶叶酿制企业网站模板

- 多功能轻量级jquery tab选项卡插件使用教程

- 实现快速增量更新的jar包解决方案

- RabbitMQ消息队列安装及应用实战教程

- 简化操作:一键脚本调用截图工具使用指南

- XSJ流量积算仪控制与数显功能介绍

- Android平台下的AES加密与解密技术应用研究

- Место-响应式单页网站的项目实践

- Android完整聊天客户端演示与实践