PyTorch深度学习应用接口评审:问题与改进意见

需积分: 0 26 浏览量

更新于2024-08-04

收藏 26KB DOCX 举报

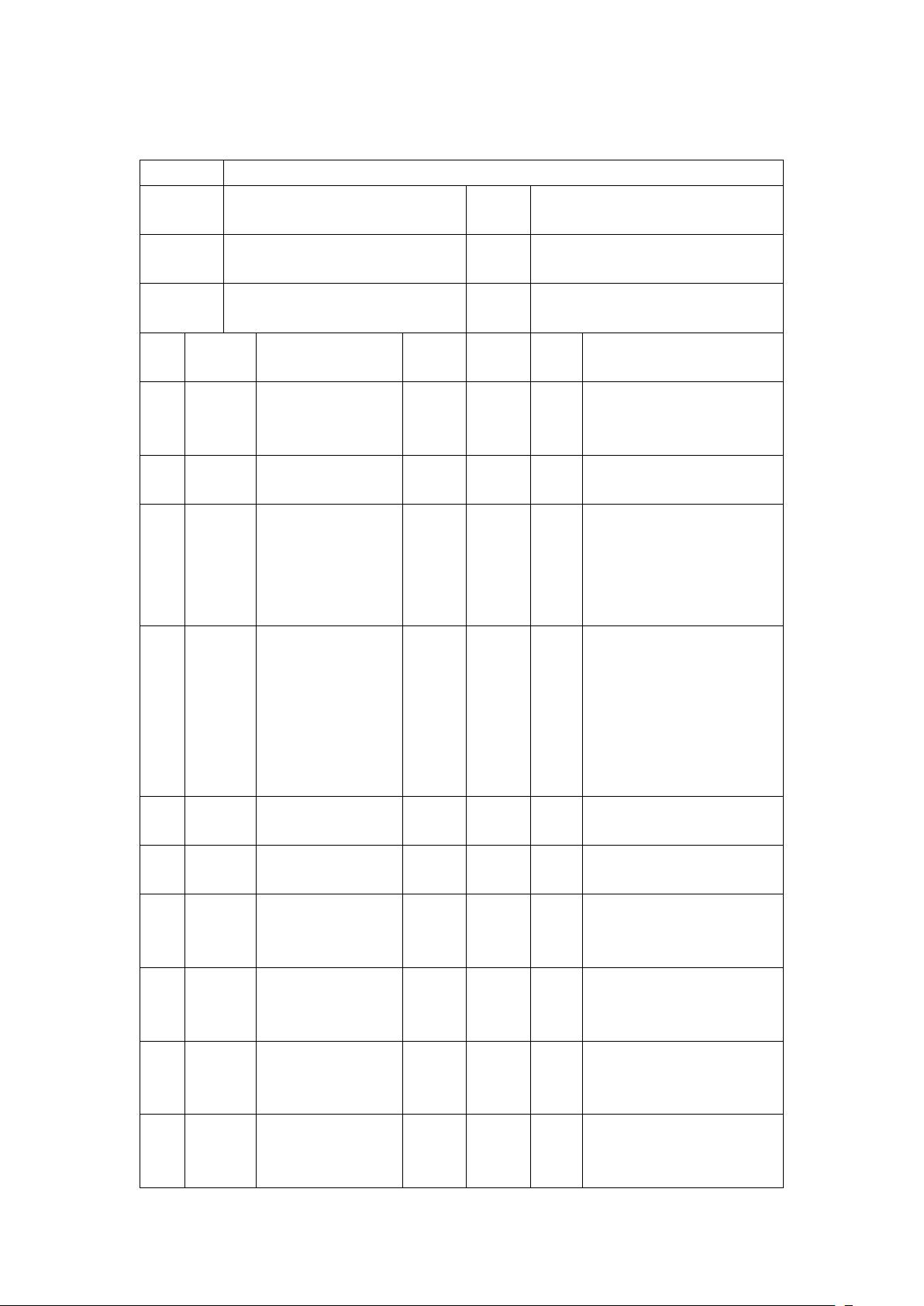

在本次E组对A组的评审单-反馈1中,针对"基于PyTorch的前沿深度学习算法集成应用程序接口"的测试报告,评审团队提供了详细的评估和建议。以下是评审过程中发现的主要问题和对应的处理意见:

1. 完整性问题:评审对象TeamA的测试报告缺少实际运行的测试用例代码(编号1),评审者张延钊建议在适当时间进行修改,确保测试流程的可执行性。

2. 支持性证据:在报告中,测试结论缺乏具体的支持性数据或证据(编号3),同样由张延钊指出,需要补充以增强报告的可信度。

3. 逻辑一致性:在测试目标部分,提到API的优劣性后,后续内容未跟进(编号4),建议作者补充详细分析。

4. 语言准确性:在描述模块间交互时,"是否检查可用性关及时释放"的表述不够清晰(编号5),需改进表达以确保读者理解。

5. 命名规范:评审者发现报告中"python"的首字母大小写不一致(编号6)以及"Plckle"的拼写错误(编号6),虽然轻微,但仍需要注意保持专业命名的规范。

6. 术语一致性:在报告的不同部分,"Pytorch"和"torch"的用法不统一(编号7),建议统一使用标准术语。

7. 步骤清晰度:在3.3表3-3中的步骤1,描述与后续步骤关联不明(编号8),需明确指示操作之间的逻辑关系。

8. 拼写一致性:在4.3.1中,"PyThon"的拼写有误(编号9),应保持一致性。

9. 报告结构:在4.4章节,建议删除多余的"测试用例名称"表头(编号11),同时确保每个测试用例与实际内容对应。

10. 重复内容:在4.4.1中,提及的"可选择另外安装"已在第3章的工具包安装测试用例中涵盖,因此不应单独列出(编号10)。

通过这份评审反馈,A组成员可以了解到他们在报告编写过程中需要注意的细节,以便提高报告的专业性和准确性。同时,这也有助于整个团队提升文档标准化,提高深度学习算法集成应用程序接口开发的规范程度。

2021-10-25 上传

2022-08-08 上传

2021-10-11 上传

2022-08-08 上传

2022-08-03 上传

2022-08-08 上传

点击了解资源详情

点击了解资源详情

点击了解资源详情

袁大岛

- 粉丝: 39

- 资源: 305

最新资源

- SSM动力电池数据管理系统源码及数据库详解

- R语言桑基图绘制与SCI图输入文件代码分析

- Linux下Sakagari Hurricane翻译工作:cpktools的使用教程

- prettybench: 让 Go 基准测试结果更易读

- Python官方文档查询库,提升开发效率与时间节约

- 基于Django的Python就业系统毕设源码

- 高并发下的SpringBoot与Nginx+Redis会话共享解决方案

- 构建问答游戏:Node.js与Express.js实战教程

- MATLAB在旅行商问题中的应用与优化方法研究

- OMAPL138 DSP平台UPP接口编程实践

- 杰克逊维尔非营利地基工程的VMS项目介绍

- 宠物猫企业网站模板PHP源码下载

- 52简易计算器源码解析与下载指南

- 探索Node.js v6.2.1 - 事件驱动的高性能Web服务器环境

- 找回WinSCP密码的神器:winscppasswd工具介绍

- xctools:解析Xcode命令行工具输出的Ruby库