Hadoop上的数据仓库:Hive入门与实践

需积分: 10 67 浏览量

更新于2024-07-26

收藏 806KB PDF 举报

"Hive编程入门课程"

Hive是一款基于Hadoop的数据仓库工具,它提供了对大规模数据集进行SQL-like查询和分析的能力。由Facebook赞助开发,Hive最初是为了处理和存储海量日志数据而设计的,现在已经成为大数据领域中一个重要的组件。Hive的核心优势在于它的可扩展性和对SQL的支持,使得非Java背景的分析师也能轻松进行大数据分析。

Hadoop是开源的MapReduce框架,由Yahoo!发起,是Hive的基础。Hive作为Hadoop生态系统的一部分,主要负责将SQL查询转化为适合Hadoop MapReduce的任务进行执行,从而处理PB级别的数据。

选择Hive的原因:

1. 扩展性:基于Hadoop,Hive能够处理非常大的数据集,且随着硬件的增加,可以线性扩展。

2. SQL-like语法:Hive提供了一种与SQL类似的查询语言——HiveQL,使用户能用熟悉的语法进行数据分析,降低了学习成本。

3. 统一元数据管理:Hive管理着所有数据的元数据,包括表结构、分区等,使得数据管理和查询更为便捷。

Hive架构包括客户端应用程序、元数据和编程接口。客户端用于与Hive交互,元数据服务器负责存储表、数据库、分区等信息,编程接口则允许开发者通过API来访问Hive的功能。

配置和部署Hive涉及客户端安装、设置元数据服务器以及定义数据存储位置。客户端可以是Hive Shell、Beeline或其他支持Hive协议的工具。

HiveQL编程是Hive的主要使用方式。虽然与SQL相似,但并不完全相同,比如在数据类型、DDL(数据定义语言)和DML(数据操作语言)上有一些差异。例如,Hive支持基本类型如整型、布尔型、浮点型、字符串,以及复杂类型如数组、映射和结构体。然而,它不支持日期/时间类型,并且在数据类型上没有精度或长度限制。

数据模型包括数据库、表、分区和文件。数据库是逻辑上的容器,表是数据的基本单位,可以被划分为多个分区,每个分区对应一组特定条件的数据。文件则是实际存储数据的地方。

DDL语句用于创建表、分区等,如`CREATE TABLE`用于创建新表,`CREATE EXTERNAL TABLE`创建外部表,`PARTITIONED BY`定义分区,`STORED AS`指定数据存储格式,`LOCATION`指定数据的HDFS路径。

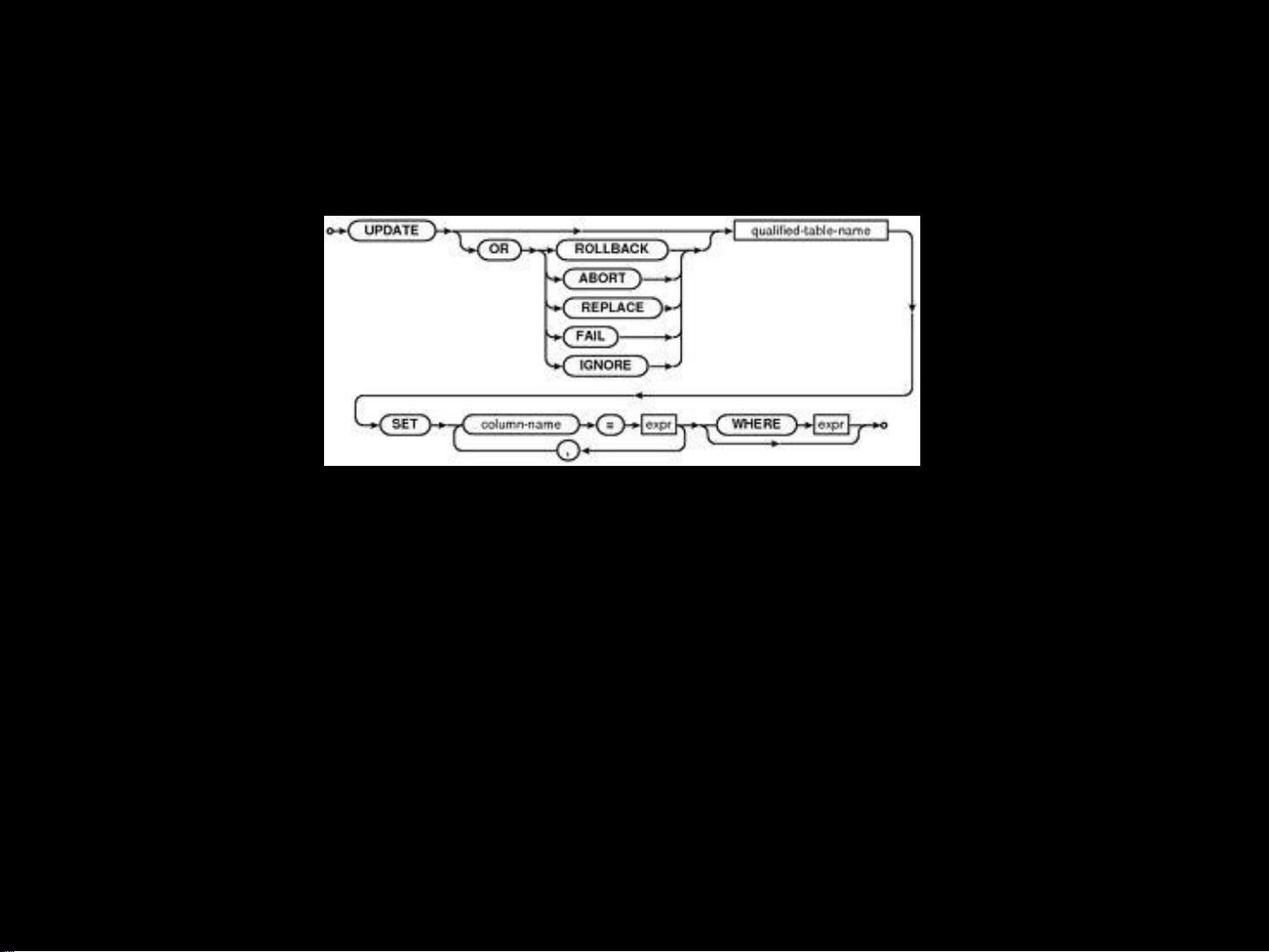

DML操作包括加载数据、插入数据、更新和删除。`LOAD DATA`用于将文件加载到表中,`INSERT INTO/OVERWRITE`用于向表中插入或覆盖数据,`SELECT`用于查询数据,`DELETE`则用于删除数据。

Hive的查询优化涉及到对查询计划的改进,包括使用恰当的分区策略、选择高效的JOIN算法、使用索引等方法,以提高查询效率。

Hive是大数据分析的重要工具,它通过提供SQL-like查询接口简化了对Hadoop集群上大数据的处理,使得数据科学家和分析师能够更高效地探索和理解海量数据。

2020-01-17 上传

2017-10-17 上传

2022-02-02 上传

2023-03-16 上传

2023-06-28 上传

2023-03-17 上传

2023-06-08 上传

2023-08-13 上传

2024-05-23 上传

xq0804200134

- 粉丝: 0

- 资源: 14

最新资源

- 基于Python和Opencv的车牌识别系统实现

- 我的代码小部件库:统计、MySQL操作与树结构功能

- React初学者入门指南:快速构建并部署你的第一个应用

- Oddish:夜潜CSGO皮肤,智能爬虫技术解析

- 利用REST HaProxy实现haproxy.cfg配置的HTTP接口化

- LeetCode用例构造实践:CMake和GoogleTest的应用

- 快速搭建vulhub靶场:简化docker-compose与vulhub-master下载

- 天秤座术语表:glossariolibras项目安装与使用指南

- 从Vercel到Firebase的全栈Amazon克隆项目指南

- ANU PK大楼Studio 1的3D声效和Ambisonic技术体验

- C#实现的鼠标事件功能演示

- 掌握DP-10:LeetCode超级掉蛋与爆破气球

- C与SDL开发的游戏如何编译至WebAssembly平台

- CastorDOC开源应用程序:文档管理功能与Alfresco集成

- LeetCode用例构造与计算机科学基础:数据结构与设计模式

- 通过travis-nightly-builder实现自动化API与Rake任务构建