Hadoop深度解析:分布式存储与分析的关键技术

需积分: 5 114 浏览量

更新于2024-07-16

收藏 2.75MB PDF 举报

Hadoop Notebook是一份全面介绍Hadoop技术的详细指南,它涵盖了Hadoop生态系统的核心组件:Hadoop Distributed File System (HDFS)、YARN、MapReduce以及相关的技术细节。这份文档旨在帮助读者理解Hadoop如何处理海量数据,并实现数据的可靠存储、高效分析和处理。

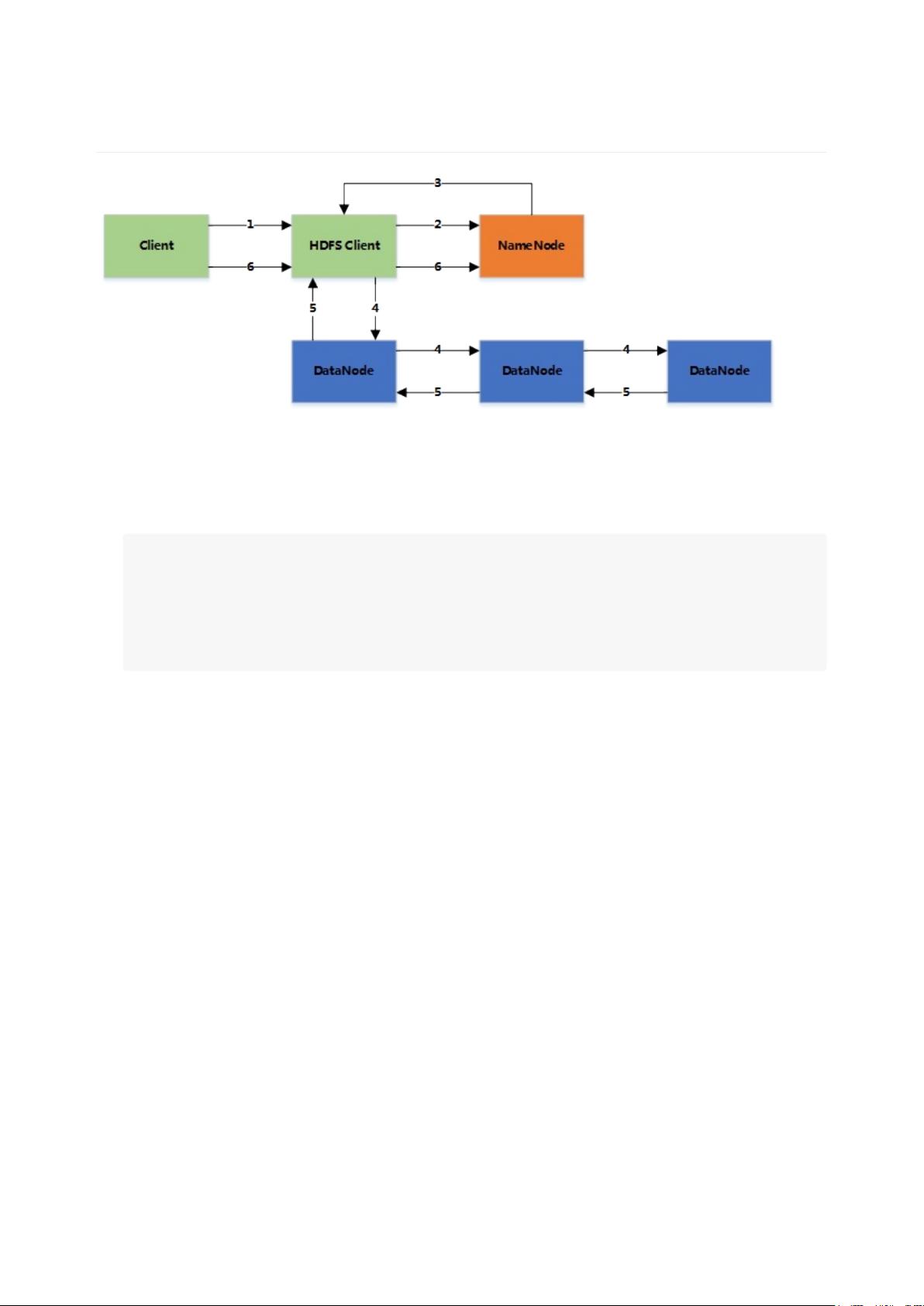

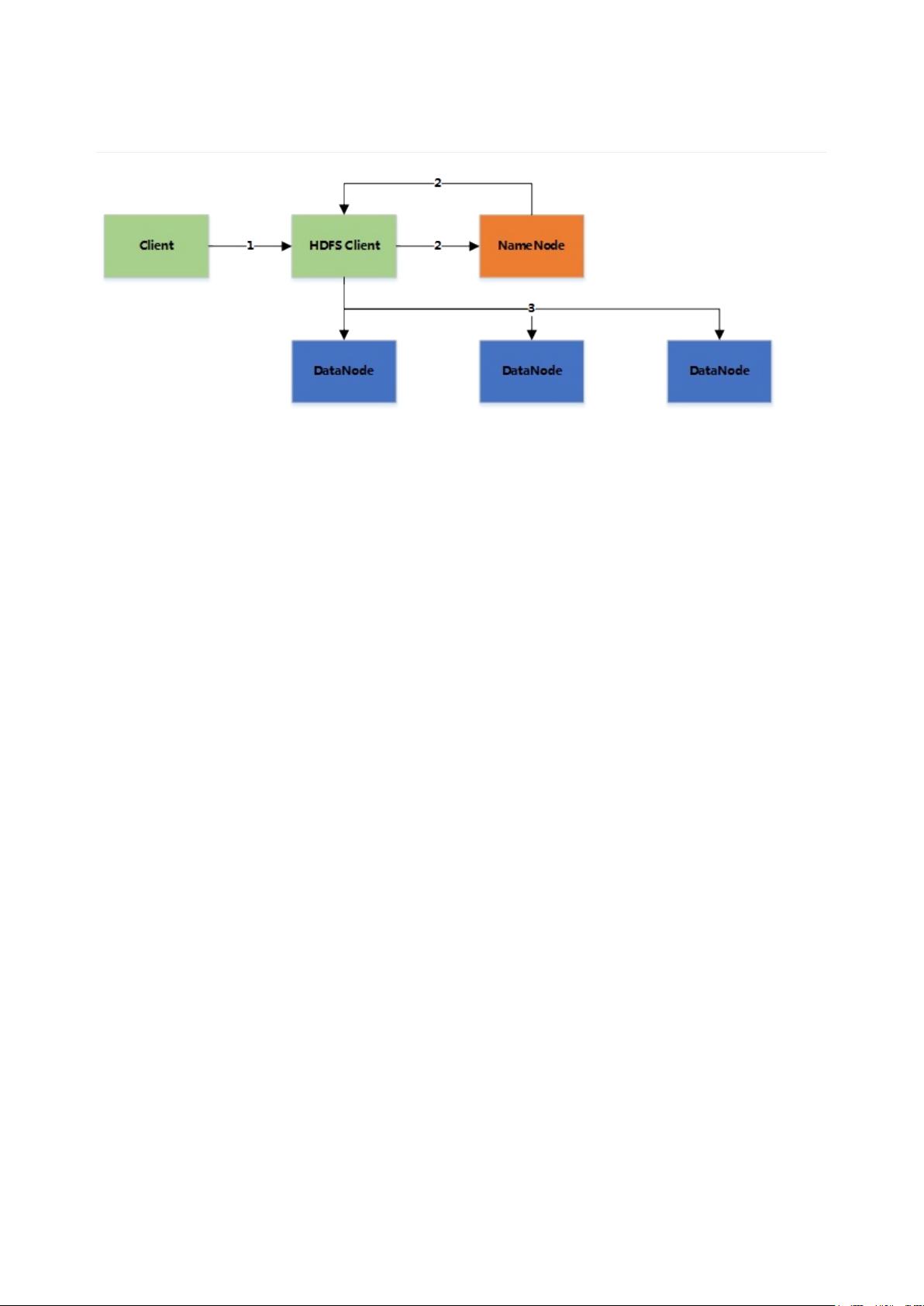

1. HDFS:HDFS是Hadoop的主要存储组件,设计用于处理大规模数据。它将大文件分割成64M(可配置)的Block,分散存储在集群的不同节点上,以提高数据访问速度和容错能力。每个Block默认复制三份,确保数据安全性和高可用性。文件操作包括写入(Write)、读取(Read),以及故障恢复策略,确保即使部分节点失效,数据仍能被完整访问。

2. YARN:Yet Another Resource Negotiator是Hadoop的资源调度器,负责任务的分配和管理。它包括Resource Manager(全局资源管理器)、Node Manager(节点资源管理器)、ApplicationMaster(应用程序主进程)、Container(可执行的容器)以及故障处理机制,支持在分布式环境中执行复杂的任务。

3. MapReduce:这是一种分布式计算模型,用于并行处理大量数据。它包括读取数据(Input)、Map阶段(将输入切分成小块进行处理)、Shuffle(数据重新排序和分发)、Reduce阶段(汇总和合并中间结果)以及编程模型的设计。MapReduce允许用户编写简单的函数来处理数据,无需关心底层细节。

4. 大数据特性:Hadoop针对大数据的特性,如大量性(volume)、快速性(velocity)、多样性(variety)和易变性(variability),提供解决方案。数据的分布式存储和分析使得系统能够处理超出单机处理能力的数据。同时,Hadoop强调数据的准确性和复杂性管理,通过有效的方法抽取、转换和加载数据以获取有价值的信息。

5. 关键技术:Hadoop Notebook详细讲解了Hadoop的关键技术,包括分布式存储、数据分片、任务调度、数据处理模型和性能优化。这些技术共同构成了Hadoop在处理大规模数据时的核心竞争力。

通过这份笔记,读者可以深入理解Hadoop的工作原理,掌握如何使用Hadoop生态系统中的工具进行数据处理和分析,从而应对日益增长的数据挑战。无论是初次接触Hadoop的开发者还是经验丰富的专业人士,这份资源都是提升大数据处理能力的重要参考资料。

2024-07-11 上传

2020-02-06 上传

2021-05-20 上传

2019-11-22 上传

2022-02-09 上传

2023-03-21 上传

2022-11-24 上传

2022-10-27 上传

2024-04-14 上传

宇直豪

- 粉丝: 110

- 资源: 4

最新资源

- 血色素沉着病:混合了性别和基因型的血液样本具有铁血毒性

- 参考资料-基于soc单片机的ph值检测与控制.zip

- Copy Tab-crx插件

- pandas_flavor-0.1.2.tar.gz

- Tcldrop-开源

- zTail-开源

- 通往软件架构师的道路-Python开发

- Laboratorio7_CVDS

- 恶意软件收集:计算机的恶意软件,压力测试等的源代码

- whiteboard-angular-client:白板前端。 Whiteboard Web App的Angular客户端。 :books:

- pandas_flavor-0.1.1.tar.gz

- iTab - Awesome Tab Manager-crx插件

- aria2c-android-app:aria2c-android-app

- projecting

- x70talk-开源

- DPDraggableButton-Swift:拖动或点击按钮以触发手势事件