深度学习理论详析:从神经网络到卷积与Transformer

需积分: 5 194 浏览量

更新于2024-06-25

2

收藏 8.82MB DOCX 举报

深度学习理论学习资料是一份详尽的教程,共计41页,涵盖了深度学习的基础理论。这份资料首先深入讲解了深度前馈神经网络,强调了激活函数的重要性,如sigmoid、tanh和ReLU。激活函数通过引入非线性,使网络能够进行分层非线性建模,避免了深度神经网络仅限于线性映射的问题。ReLU因其在x>0时的线性行为和避免梯度消失的优点,成为了首选。然而,ReLU的硬饱和区可能导致部分神经元死亡。

在深度前馈网络的推导过程中,包括了权重w和偏置b的求导,以及对梯度消失和爆炸现象的解释。梯度消失发生在反向传播过程中,梯度随层数递减,而梯度爆炸则因权重过大导致梯度急剧增长。为解决这些问题,人们发展出了各种改进的激活函数和权重初始化策略。

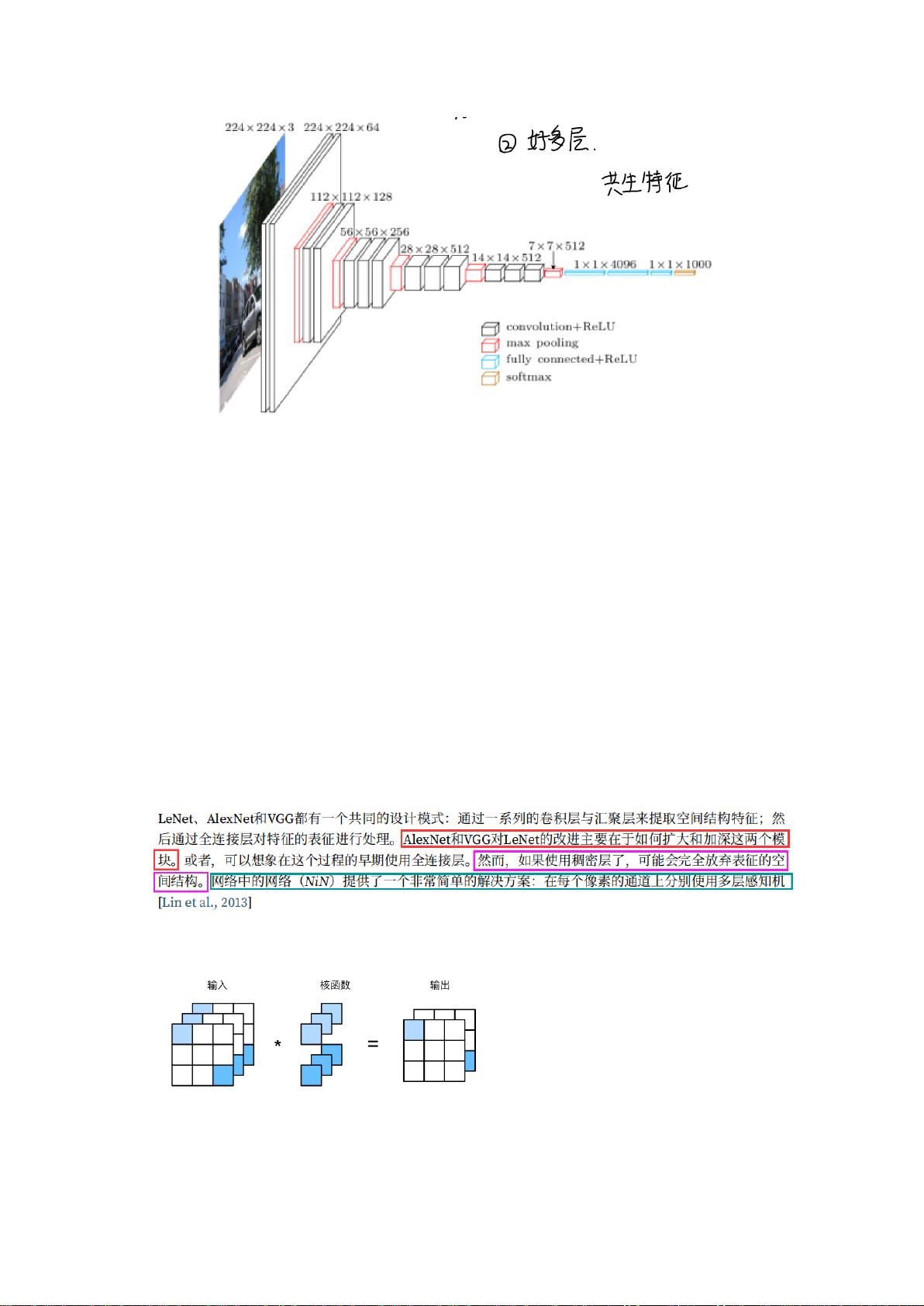

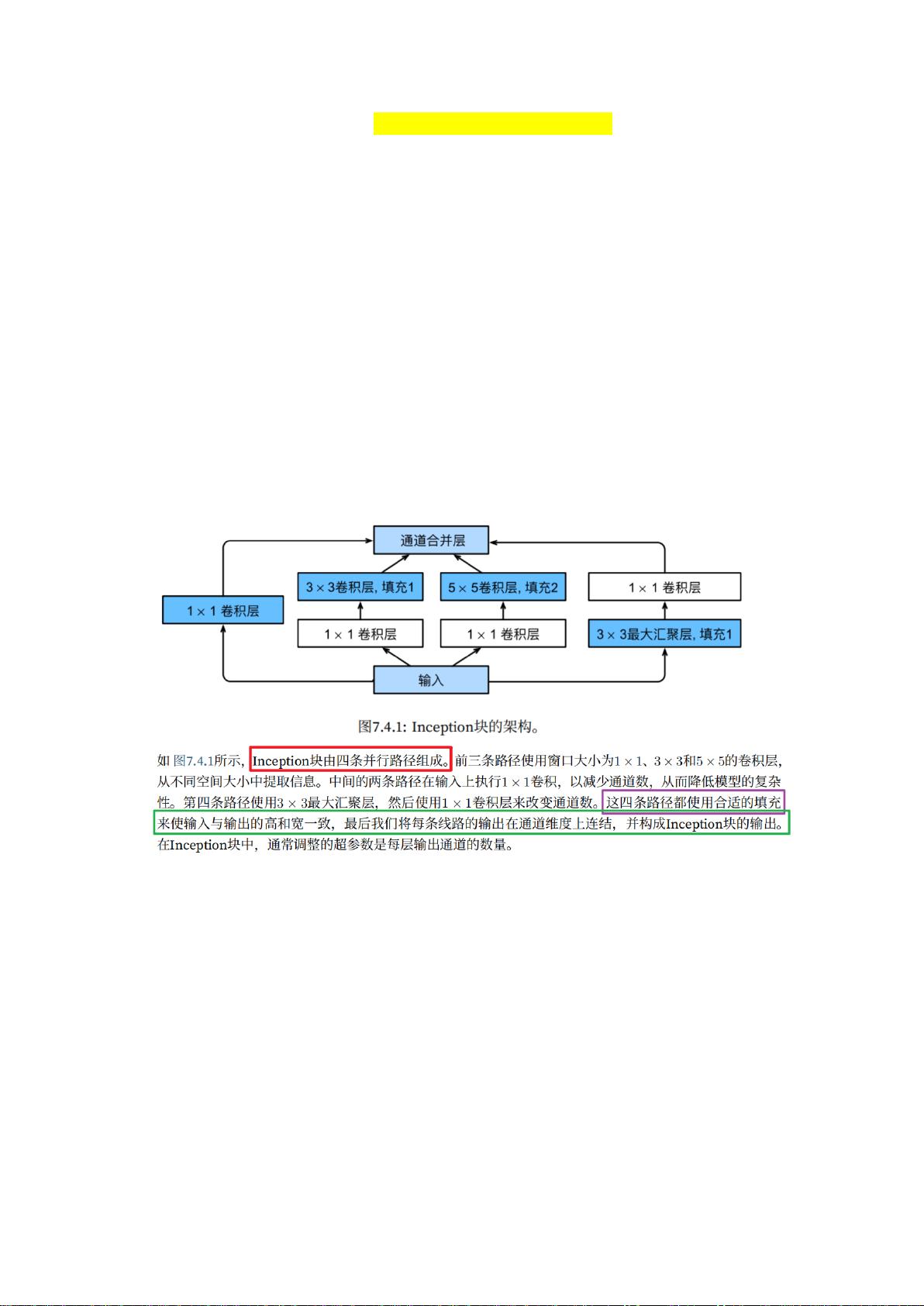

接下来,资料转向了卷积神经网络(CNN),这是深度学习中的关键组件。它介绍了卷积操作的原理,包括局部感知、权重共享和池化,这有助于减少模型复杂度并提高效率。计算特征图大小的方法通过输入尺寸、卷积核、步长和填充来确定。CNN的结构通常包含卷积层、池化层和全连接层,其特点是局部连接、权值共享、层次特征提取、平移不变性及位置信息保留,以及数据增强的利用。此外,预训练和微调技术也被广泛应用于CNN,以提升模型的性能和适应性。

这份资料进一步探讨了高级CNN和轻量级CNN,以及诸如间隔损失softmax函数、特征白化、正则化、优化算法(如Adam或SGD)、RNN(循环神经网络)和它们的变种如Attention机制、Transformer模型、自编码器(AE)、BERT、VAE(生成对抗网络GAN)等。最后,还提到了元学习和零样本学习这两个前沿领域的基本概念,展示了深度学习的广阔应用范围和不断演进的技术趋势。

这份资料提供了深度学习的系统学习路径,不仅覆盖了基础知识,还涵盖了深度学习中的关键技术和最新进展,适合对深度学习有深入理解和实践需求的学习者。

2018-02-03 上传

2023-07-14 上传

2021-05-31 上传

2021-10-10 上传

2021-02-01 上传

2021-09-30 上传

南门听露

- 粉丝: 11

- 资源: 2

最新资源

- JDK 17 Linux版本压缩包解压与安装指南

- C++/Qt飞行模拟器教员控制台系统源码发布

- TensorFlow深度学习实践:CNN在MNIST数据集上的应用

- 鸿蒙驱动HCIA资料整理-培训教材与开发者指南

- 凯撒Java版SaaS OA协同办公软件v2.0特性解析

- AutoCAD二次开发中文指南下载 - C#编程深入解析

- C语言冒泡排序算法实现详解

- Pointofix截屏:轻松实现高效截图体验

- Matlab实现SVM数据分类与预测教程

- 基于JSP+SQL的网站流量统计管理系统设计与实现

- C语言实现删除字符中重复项的方法与技巧

- e-sqlcipher.dll动态链接库的作用与应用

- 浙江工业大学自考网站开发与继续教育官网模板设计

- STM32 103C8T6 OLED 显示程序实现指南

- 高效压缩技术:删除重复字符压缩包

- JSP+SQL智能交通管理系统:违章处理与交通效率提升