优化方法详解:机器学习中的梯度下降与PCA应用

需积分: 0 43 浏览量

更新于2024-06-18

收藏 26.35MB PDF 举报

本课程笔记涵盖了机器学习中的优化方法论,重点讨论了在dsml课程中的关键概念和技术。从L10开始,内容涉及以下几个主要部分:

1. **定义与基础概念**:

- **开放球(openball)**:数学中的一个概念,用于描述在某点周围的一组所有具有特定半径的点集合。

- **最小化(minimization)**:机器学习的核心目标,寻找使目标函数达到最低值的参数或模型。

- **内点(interior point)**:优化问题中指函数在某个区域内非边界点,对于凸优化问题有特殊意义。

- **梯度向量(gradiente vector)**:多变量函数中关于每个自变量的导数构成的向量,用于指示函数增加最快的方向。

- **海森矩阵(hessian matrix)**:二阶导数矩阵,用于衡量函数曲率,对局部最优点的确定至关重要。

2. **凸性与局部最小值**:

- **正定矩阵(positive definite matrix)**:矩阵的特征值全为正,保证了优化问题的性质。

- **stationary point**:满足梯度等于零的点,可能是局部极小值、极大值或鞍点。

- **局部最小的条件**:包括必要条件(如梯度为零)和充分条件(如凸集),确保找到的是局部最优解。

3. **特征值分解与PCA(主成分分析)**:

- **标准化数据预处理**:确保各特征之间尺度一致,便于后续分析。

- **协方差矩阵(covariance matrix)**:衡量属性之间的线性关系,最大特征值对应最大方差方向。

- **特征值分解**:将协方差矩阵分解为特征值和特征向量,用于降维和数据可视化。

- **PCA应用**:通过保留主要的特征向量,提取数据的主要模式。

4. **搜索方向与优化算法**:

- **搜索方向(search direction)和下降方向(descent direction)**:优化过程中调整参数的指导方向。

- **最速下降法(steepest descent method)**:基于梯度的简单优化策略,寻找函数下降最快的方向。

- **线搜索(line search)**:两种方法:

- **精确线搜索(exact line search)**:理想情况下找到最优步长,但计算复杂。

- **回溯线搜索(backtracking line search)**:在精确搜索不可行时,采用试探性减小步长的方式。

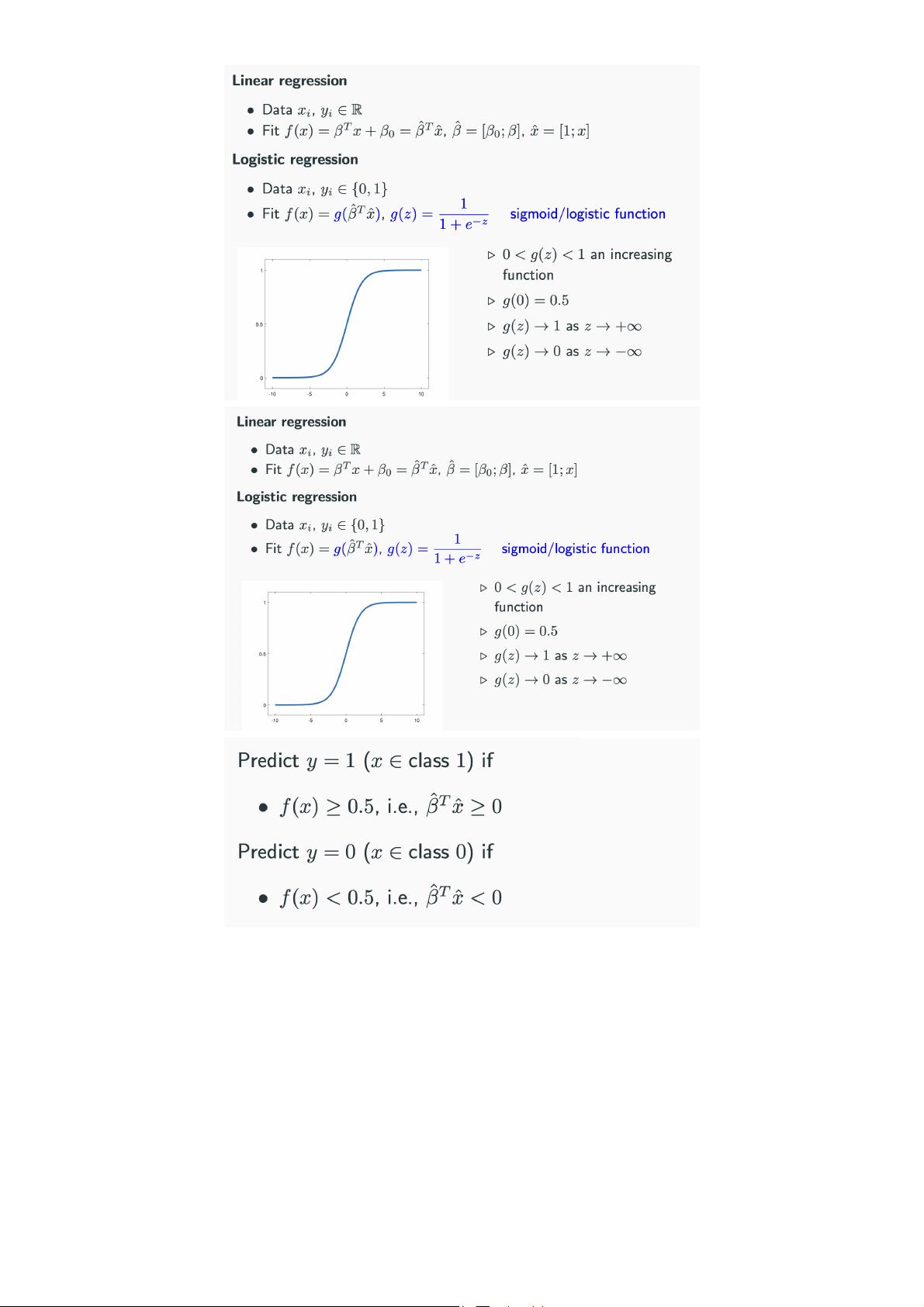

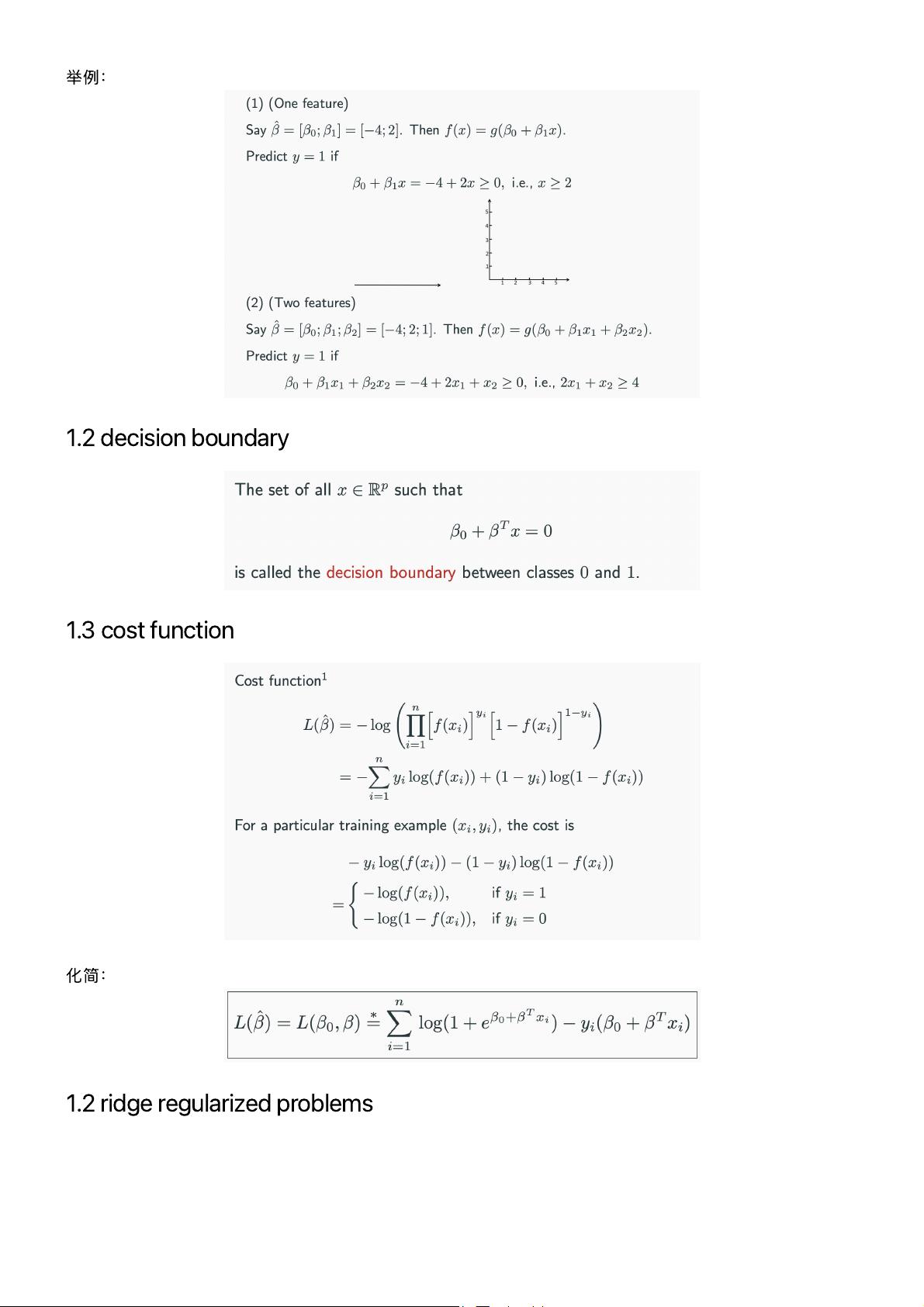

5. **逻辑回归与正则化**:

- **逻辑回归(logistic regression)**:一种广泛使用的分类模型,涉及损失函数和正则化的调整。

- **ridge regularization**(岭回归):通过引入L2范数惩罚,防止过拟合,改善模型泛化能力。

这些笔记提供了对机器学习优化方法的深入理解,包括理论基础、常见算法以及它们在实际问题中的应用。通过这些内容,学生可以掌握如何有效地解决机器学习中的优化问题,特别是在数据预处理、特征选择和模型训练等方面。

225 浏览量

点击了解资源详情

点击了解资源详情

2021-04-10 上传

2021-04-09 上传

2021-04-11 上传

江南无妖

- 粉丝: 3994

- 资源: 1

最新资源

- detectBrowserVisibility:检测浏览器可见性状态变化

- stomp-websocket-server:使用Spring的STOMP实现Websocket服务器

- python代码自动办公 Excel_案例_用Excel画画项目源码有详细注解,适合新手一看就懂.rar

- jQuery带备忘录功能的日期选择器特效代码

- NAS-DIP-pytorch:[ECCV 2020] NAS-DIP

- kj6682-library:我的图书馆

- Archive-1844_C++_

- 互联网站点:存储库,可扩展性或永久性

- breakout-rooms:分组讨论室附加到Jitsi Meet和Jitsi Videobridge项目中

- PHP实例开发源码-易优实验报告管理系统 PHP源码 v1.0.zip

- bikeshop:网络开发课程项目

- python代码自动办公 用Python在Excel中查找并替换数据 项目源码有详细注解,适合新手一看就懂.rar

- KonradLinkowski:我的GitHub操作配置文件README :)

- WEB1:某种html内容

- Node-Chat:建立在Node.js,Socket.io和WebRTC上的类似omegle的应用程序

- Leveon Bell HD Wallpapers Game Theme-crx插件