Idea中Java与Spark项目:Maven工程创建与打包详解

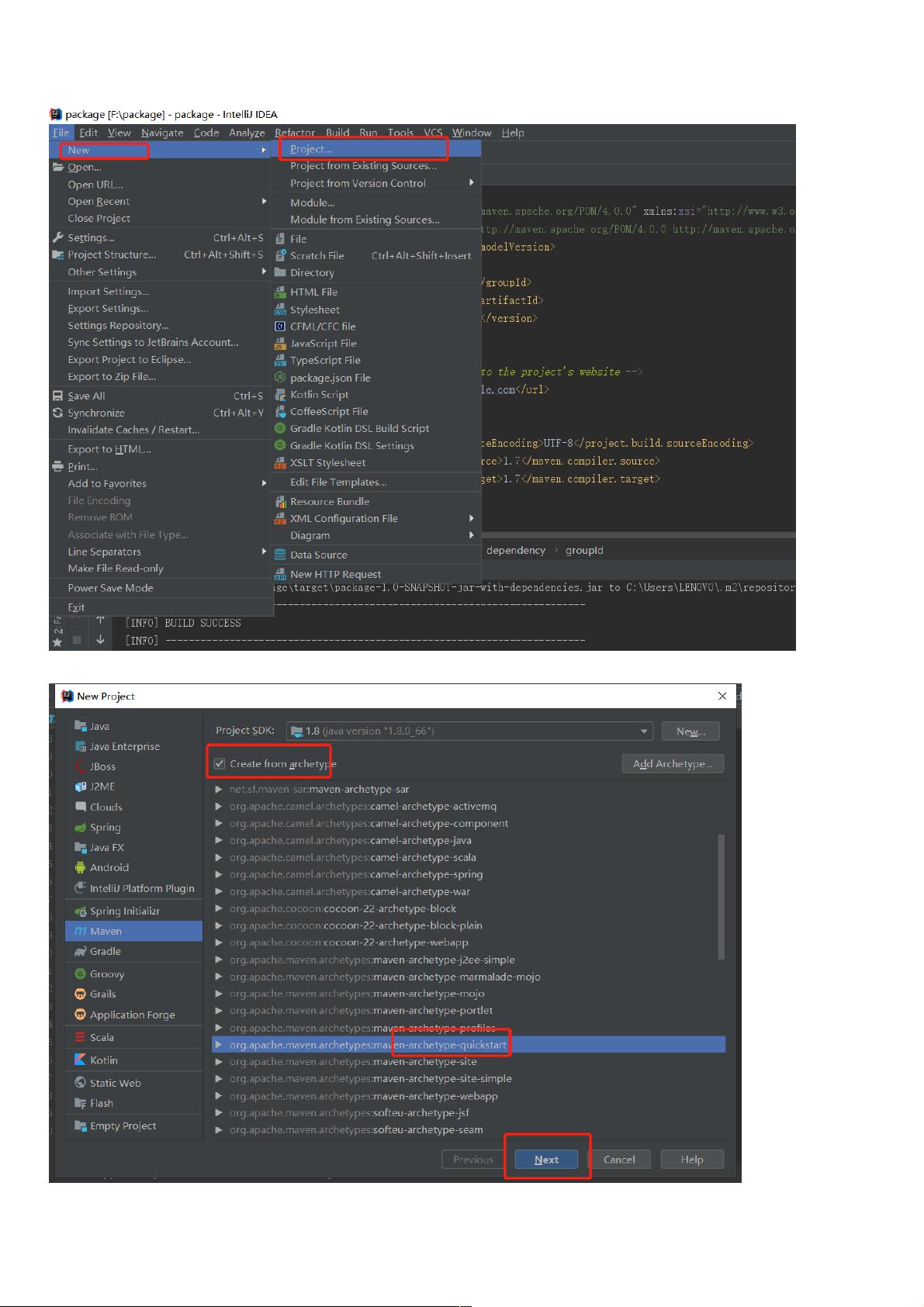

在使用IntelliJ IDEA创建Java和Spark项目的教程中,首先介绍如何在IDEA中初始化一个新的工程。步骤如下:

1. **新建工程**: 打开IntelliJ IDEA,选择"New Project",然后选择"Maven"作为构建系统,因为我们将使用Maven进行项目管理。

2. **创建Maven工程**: 在新项目向导中,输入项目名称,确保选择正确的项目类型,如"Java"或"Spark",具体取决于你需要构建的是Java应用还是Spark项目。在创建过程中,注意勾选适当的配置选项,以便IDE自动生成必要的设置。

3. **工程命名与设置**: 填写项目的基本信息,例如包名和模块结构,保持默认的"source"目录,如果需要创建Scala文件(针对Spark),则会在此阶段创建对应的模块。

4. **导入依赖**:在项目创建后,通过快捷键`Ctrl+Alt+S`打开Settings/Preferences,搜索"Maven",然后选择"Import"。在这里添加所需的库依赖,如JUnit测试框架和Siddhi流处理框架。对于Java项目,引入`junit`、`siddhi-core`、`siddhi-query-api`和`maven-assembly-plugin`等;对于Spark项目,还需要添加Scala相关依赖,如`scala-library`、`spark-core`, `spark-sql`, `spark-streaming`以及Hadoop和MySQL连接器等。

5. **修改POM.xml**:在项目的`pom.xml`文件中,详细列出每个依赖的版本号,确保与项目的实际需求匹配。例如,Spark的版本号为2.11,Hadoop的版本可能根据实际情况有所不同。

6. **打包与执行**:对于Java项目,使用`maven-assembly-plugin`进行打包,选择合适的配置(如`jar-with-dependencies`)以包含所有依赖,然后运行`mvn install`命令进行编译和打包。打包完成后,可以通过`java -jar XXXX.jar`来执行生成的jar文件。

7. **Spark项目处理**:对于Spark项目,除了Java代码外,还需要编写Scala代码。在Scala模块中,创建对应的Scala类,实现Spark任务。同样,也需要在`pom.xml`中正确配置Scala的版本(如2.11)以及Spark及其相关组件的版本。

这个教程指导用户在IntelliJ IDEA中创建Java项目,并集成Spark,同时管理依赖和打包过程,包括配置Maven、添加必要的库、编写和执行代码,以及打包成可执行的jar文件。在实际操作时,确保遵循提供的版本信息,以便正确地集成和运行Spark应用程序。

1985 浏览量

1390 浏览量

5884 浏览量

1933 浏览量

6004 浏览量

615 浏览量

338 浏览量

weixin_38513565

- 粉丝: 4

- 资源: 899

最新资源

- pass4side 000-M15题库下载

- GDB中文文档 linux下调试方法

- NB的TCL语言入门

- 经典SQL 高手总结的

- Manning.Publications.Windows.Forms.in.Action.2nd.Edition.Apr.2006 c#

- Object Oriented Programming With Microsoft Vb Net And C# Step By Step.pdf

- ARM开发入门(S3C)

- 深入编程内幕——Visual C++.

- SQL Server语句大全

- Apress_Expert one on one Oracle

- 网通WLAN测试规范

- 2001年度网络程序员级上午试卷

- maximo6体系架构

- 视频会议系统解决方案

- Solaris internals PPT

- Racer的用户文档