深度学习与自然语言处理:信息熵与N-Gram模型探索

需积分: 0 51 浏览量

更新于2024-08-05

收藏 568KB PDF 举报

"SY2106318-深度学习和自然语言处理第一次作业1"

本次作业主要涉及深度学习和自然语言处理领域的基础知识,特别是信息熵的计算以及统计语言模型的介绍。作业要求包括对中文文本的平均信息熵进行计算,以词和字为单位,这涉及到对信息论中熵这一概念的理解和应用。

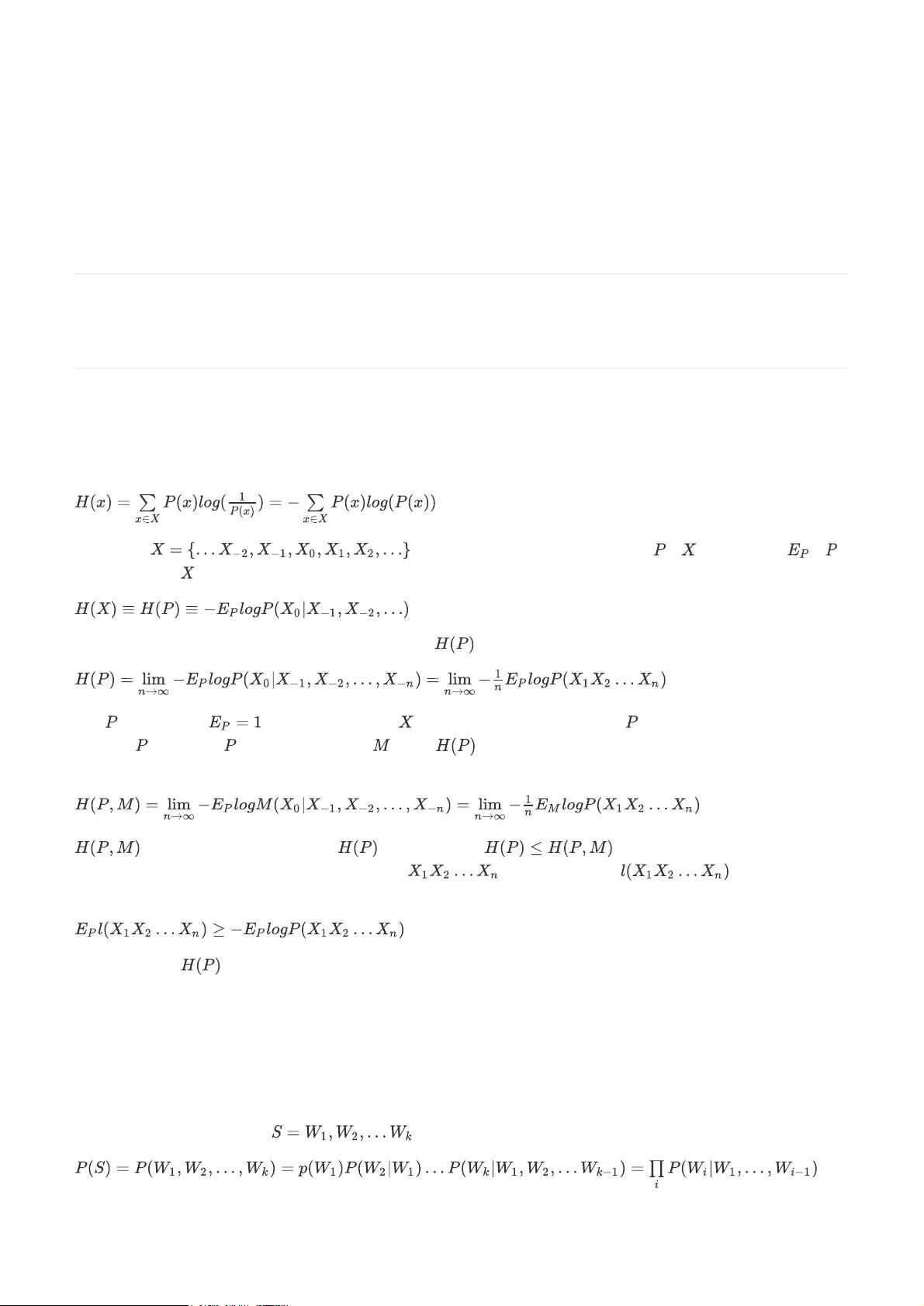

1. 信息熵 是信息论中的核心概念,由克劳德·香农提出,用于衡量信息的不确定性。熵的值越大,表示信息的不确定程度越高。公式表达为 \( H = -\sum_{i} p_i \log_2 p_i \),其中 \( p_i \) 是第 \( i \) 个事件发生的概率。在文本压缩中,信息熵可以看作是对文本编码所需平均位数的下限,高熵意味着字符携带的信息量大,压缩效率相对较低。

2. 中文信息熵的计算 需要根据《Entropy_of_English_PeterBrown》这篇文章的方法,对中文文本进行处理。由于中文与英文的字符集不同,计算时可能需要将汉字视为字符单元或词单元。为了估计中文文本的熵,需要获取字符或词的概率分布,这通常通过大量文本样本的统计来近似。在实际操作中,可能会使用N-Gram模型等方法来简化计算。

3. 统计语言模型,如N-Gram,是处理自然语言的重要工具。统计语言模型利用大规模语料库来预测词序列出现的概率,以此评估文本的合理性。N-Gram模型假设当前词的出现仅与其前n-1个词有关,减少了计算复杂性。例如,一元模型(unigram)认为每个词独立出现,二元模型(bigram)则考虑相邻的两个词的关系。这种方法在机器翻译、语音识别、自动文摘等领域有广泛应用。

4. N-Gram模型的挑战:随着n值的增加,计算所有可能的n元组的概率会面临数据稀疏问题,导致模型性能下降。为解决这一问题,实践中常采用平滑技术,如Laplace平滑或Kneser-Ney平滑,以避免某些n元组的概率为0。

5. 深度学习与自然语言处理:尽管作业未详细提及,但深度学习在NLP领域的应用广泛,如循环神经网络(RNN)、长短时记忆网络(LSTM)、门控循环单元(GRU)以及Transformer等模型,它们能捕获更复杂的语言结构和上下文依赖,提高了语言建模和理解的准确性。

综上,完成本次作业需要对信息熵有深入理解,掌握统计语言模型的基本原理,以及如何应用这些理论到中文文本中。同时,了解深度学习在NLP中的应用也是必要的背景知识。通过这个作业,学生将深化对自然语言处理中信息量化和概率建模的理解。

2013-08-06 上传

2024-04-03 上传

2021-02-23 上传

2021-04-18 上传

2021-05-27 上传

2021-08-11 上传

2021-05-05 上传

张盛锋

- 粉丝: 31

- 资源: 297

最新资源

- Java毕业设计项目:校园二手交易网站开发指南

- Blaseball Plus插件开发与构建教程

- Deno Express:模仿Node.js Express的Deno Web服务器解决方案

- coc-snippets: 强化coc.nvim代码片段体验

- Java面向对象编程语言特性解析与学生信息管理系统开发

- 掌握Java实现硬盘链接技术:LinkDisks深度解析

- 基于Springboot和Vue的Java网盘系统开发

- jMonkeyEngine3 SDK:Netbeans集成的3D应用开发利器

- Python家庭作业指南与实践技巧

- Java企业级Web项目实践指南

- Eureka注册中心与Go客户端使用指南

- TsinghuaNet客户端:跨平台校园网联网解决方案

- 掌握lazycsv:C++中高效解析CSV文件的单头库

- FSDAF遥感影像时空融合python实现教程

- Envato Markets分析工具扩展:监控销售与评论

- Kotlin实现NumPy绑定:提升数组数据处理性能