Android 应用开发培训 PDF 指南

需积分: 10 195 浏览量

更新于2024-07-22

收藏 13MB PDF 举报

Android Developer Training PDF 格式文档概述

Android Developer Training PDF 格式文档是 Google 官方提供的 Android 开发者培训文档的 PDF 格式版本,该文档将官方网站上的内容编辑成了一个便于查看的 PDF 文档。

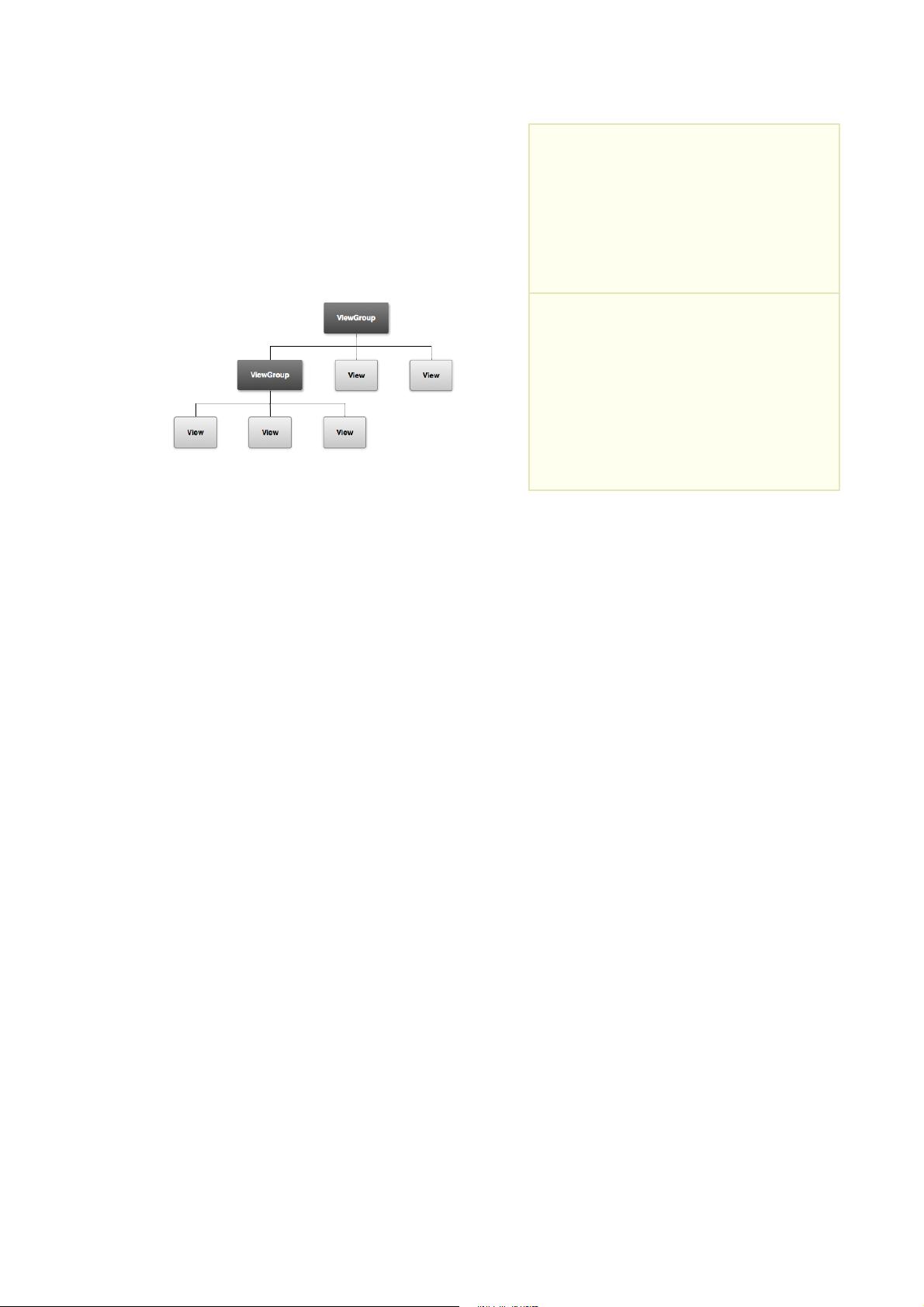

Android 开发者培训文档的主要内容包括 Android 应用程序开发的基础知识、Android 应用程序开发的进阶知识、Android 应用程序开发的高级知识等。该文档涵盖了 Android 应用程序开发的各个方面,包括 Android 基础知识、用户界面设计、数据存储、网络编程、多媒体处理、安全性等。

Android 开发者培训文档的优点包括:

* 官方认证:该文档是 Google 官方提供的,确保了文档的权威性和准确性。

* 全面性:该文档涵盖了 Android 应用程序开发的各个方面,无论是基础知识还是高级知识。

* 易读性:该文档的内容清晰易懂,适合不同水平的开发者。

* 实践性:该文档提供了许多实践项目和代码示例,帮助开发者快速掌握 Android 应用程序开发的技能。

Android 开发者培训文档的结构包括:

* 基础知识:介绍 Android 应用程序开发的基础知识,包括 Android 基础知识、用户界面设计、数据存储等。

* 进阶知识:介绍 Android 应用程序开发的进阶知识,包括网络编程、多媒体处理、安全性等。

* 高级知识:介绍 Android 应用程序开发的高级知识,包括 Android sistema 架构、Android NDK 等。

Android 开发者培训文档的license 信息包括:

* Creative Commons 2.5 Attribution License:该License 适用于 Android Open Source Project 的一些部分。

* Apache 2.0 License:该License 适用于代码示例。

* Creative Commons Attribution-NonCommercial 3.0 Unported License:该License 适用于该文档的其他部分。

Android Developer Training PDF 格式文档是 Android 应用程序开发者的必备资源,该文档提供了全面、实践的 Android 应用程序开发知识,帮助开发者快速掌握 Android 应用程序开发的技能。

189 浏览量

2021-07-16 上传

点击了解资源详情

197 浏览量

2015-04-03 上传

107 浏览量

2021-03-26 上传

2021-03-15 上传

大雀儿飞飞

- 粉丝: 58

- 资源: 15

最新资源

- 液压支架立柱和千斤顶自动化试验系统工装设计与应用.rar

- 使用XML优化配置的动态菜单,以及智能的超级列表框-易语言

- 死人开关:对于funzys

- Ziplyne Player Johns Hopkins Production -crx插件

- shortly-express

- bruhtus:古典胡话

- 安装ObjectArx的zh-chs包

- CircleIndicatorComponent.7z

- 炫彩编写的聊天框例子-易语言

- css_chris:CSS-我的网站

- Tempofila-crx插件

- c#学生管理系统

- App-Clima-GeoLocation-OpenWeatherMaps:控制台应用程序,用于使用NodeJs + GeoLocation + OpenWeatherMaps检查天气

- 将超像素作为输入MATLAB代码-medical-labeling:这个存储库包含我在伯尔尼大学的硕士论文的材料

- RayTracer:我的博客的WIP光线跟踪程序

- Foreign Domain Alerter-crx插件