深入学习大数据技术:Apache Hadoop 分布式计算框架

需积分: 12 192 浏览量

更新于2024-07-19

收藏 4.64MB PPT 举报

"大数据技术网络课程,讲解Apache Hadoop在大数据处理中的作用,涵盖Hadoop的组件如HDFS、MapReduce、Hbase、Hive、Sqoop及Spark,并深入解析大数据的4V特性,以及Hadoop在各行业的广泛应用。"

本文将深入探讨大数据技术,特别是Apache Hadoop框架,它是处理大规模数据的关键工具。大数据,以其"4V"特征——大量化(Volume)、多样化(Variety)、快速化(Velocity)和价值密度低(Value)——正在改变各行各业的运营方式。Hadoop作为Java语言实现的分布式计算框架,能够在大规模集群中高效处理PB级别的数据。

首先,我们来看看Hadoop的主要工作岗位,包括Hadoop开发者、数据工程师、大数据分析师等,这些角色共同构成了大数据生态系统的重要组成部分。大数据的背景是由不断增长的数据量和复杂性驱动的,企业需要能够处理和提取价值的工具和技术。

Hadoop包含的关键技术有:

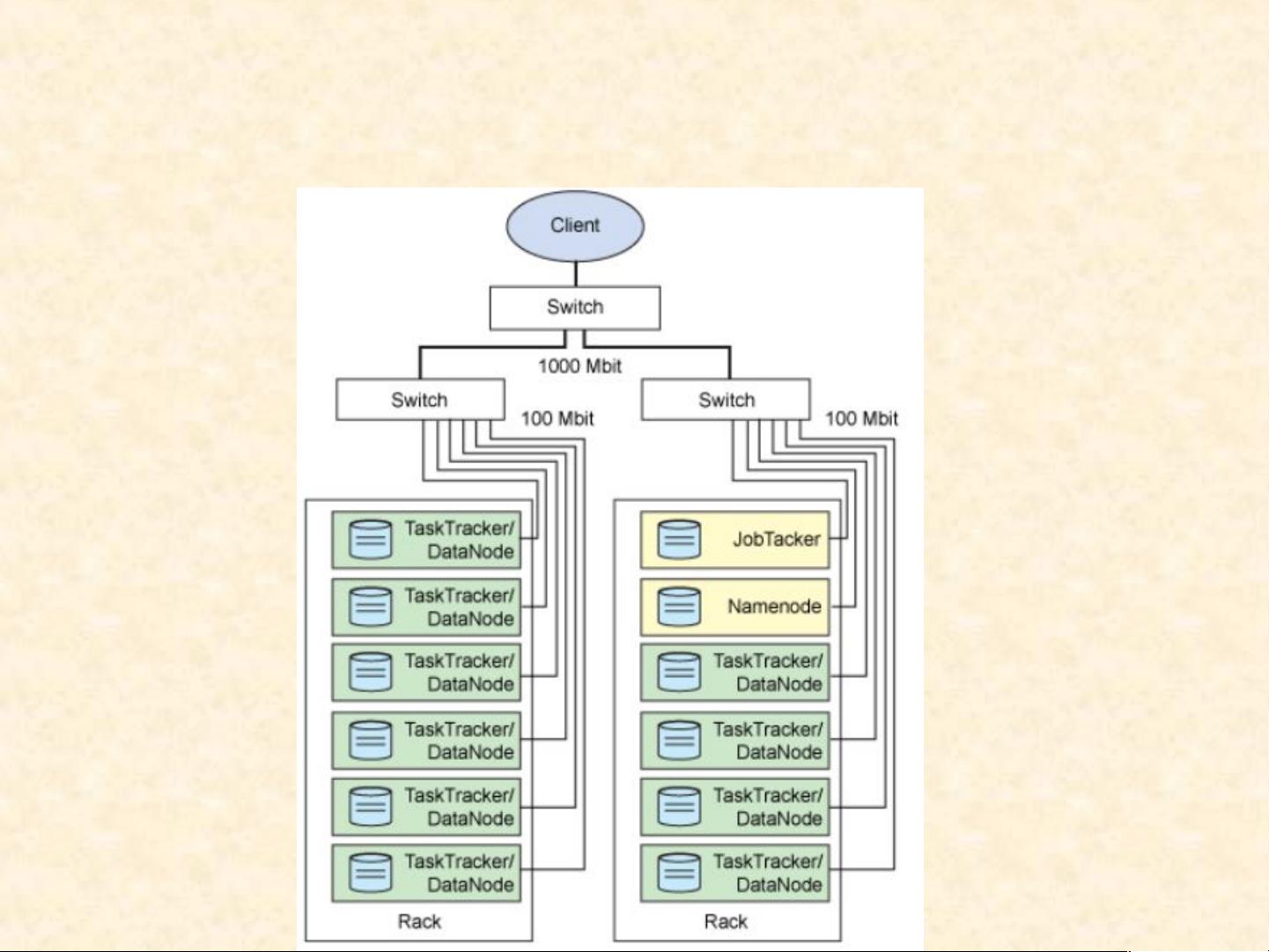

1. **HDFS(Hadoop Distributed File System)**:分布式文件系统,负责存储大规模数据。NameNode作为元数据管理器,DataNode则存储实际数据,而Client接口供用户访问文件。

2. **MapReduce**:并行计算模型,分为Map阶段(数据拆分与处理)和Reduce阶段(结果聚合)。这两个阶段确保了数据的高效处理。

3. **HBase**:基于HDFS的分布式数据库,适用于实时查询和大数据存储。

4. **Hive**:数据仓库工具,用于简化SQL-like查询,适合批处理分析。

5. **Sqoop**:用于在Hadoop和传统数据库之间高效传输数据。

6. **Spark**:快速、通用的分布式计算系统,提供内存计算,加速数据处理速度。

Hadoop不仅提供了处理大数据的基础架构,还与云计算紧密结合。云计算的弹性扩展性和按需付费模式使得大数据处理变得更加经济高效。同时,大数据应用广泛,涵盖了消费行业、金融服务业、食品安全、医疗健康、军事、交通、环保和电子商务等多个领域。

Hadoop作为Apache软件基金会的开源项目,得到了全球众多企业的支持,尤其是Yahoo!。其主要特点包括强大的扩容能力,可以处理PB级别的数据;低成本,因为可以使用普通硬件构建大规模集群;以及高效率,通过分布式计算加速处理速度。

大数据技术和Apache Hadoop是当前和未来数据密集型行业的核心,它们帮助企业从海量数据中挖掘潜在价值,推动创新和决策制定。通过学习和掌握这些技术,专业人士可以在大数据时代抢占先机,为企业带来显著的竞争优势。

2019-01-09 上传

2022-12-14 上传

2022-12-17 上传

2022-12-17 上传

2024-07-24 上传

2021-10-17 上传

2021-10-17 上传

2021-07-05 上传

2021-11-01 上传

awude

- 粉丝: 1

- 资源: 6

最新资源

- 前端面试必问:真实项目经验大揭秘

- 永磁同步电机二阶自抗扰神经网络控制技术与实践

- 基于HAL库的LoRa通讯与SHT30温湿度测量项目

- avaWeb-mast推荐系统开发实战指南

- 慧鱼SolidWorks零件模型库:设计与创新的强大工具

- MATLAB实现稀疏傅里叶变换(SFFT)代码及测试

- ChatGPT联网模式亮相,体验智能压缩技术.zip

- 掌握进程保护的HOOK API技术

- 基于.Net的日用品网站开发:设计、实现与分析

- MyBatis-Spring 1.3.2版本下载指南

- 开源全能媒体播放器:小戴媒体播放器2 5.1-3

- 华为eNSP参考文档:DHCP与VRP操作指南

- SpringMyBatis实现疫苗接种预约系统

- VHDL实现倒车雷达系统源码免费提供

- 掌握软件测评师考试要点:历年真题解析

- 轻松下载微信视频号内容的新工具介绍